Hoàng Đức

Writer

Vào ngày 6/ 10, giờ địa phương, sự kiện DevDay 2025 của OpenAI đã chính thức khai mạc. Trong bài phát biểu quan trọng, CEO của OpenAI, Sam Altman, đã công bố một cột mốc quan trọng: ChatGPT đã vượt qua 800 triệu người dùng hoạt động hàng tuần trên toàn thế giới.

Trong bài phát biểu khai mạc hội nghị, Altman cho biết: “Hiện nay, hơn 4 triệu nhà phát triển đang xây dựng các sản phẩm OpenAI; hơn 800 triệu người sử dụng ChatGPT mỗi tuần, và API của chúng tôi xử lý hơn 6 tỷ token mỗi phút. Tôi xin cảm ơn tất cả các nhà phát triển và người dùng đã giúp chúng tôi biến AI từ một ‘đồ chơi’ thành một ‘công cụ’ thực sự.”

Dữ liệu đáng kinh ngạc này tiếp tục đà tăng trưởng nhanh chóng của OpenAI trong năm qua. Altman chỉ ra rằng sự tăng trưởng này không chỉ phản ánh nhu cầu mạnh mẽ từ người tiêu dùng mà còn phản ánh sự tích hợp ChatGPT trên quy mô lớn của các nhà phát triển và doanh nghiệp vào sản phẩm và quy trình làm việc của họ. Ông nhấn mạnh rằng thế hệ công cụ dành cho nhà phát triển tiếp theo sẽ hỗ trợ việc xây dựng các ứng dụng tương tác, thích ứng và cá nhân hóa trực tiếp trong ChatGPT, đồng thời sẽ tạo ra một thế hệ kiến trúc "hệ thống đại lý" mới có thể giao tiếp với người dùng theo thời gian thực, hiểu ngữ cảnh và hoạt động tự chủ, đặt nền tảng vững chắc cho "kỷ nguyên ứng dụng AI".

Về mặt thương mại, tuần trước, OpenAI đã hoàn tất giao dịch vốn cổ phần tư nhân trị giá 6,6 tỷ đô la, nâng định giá lên 500 tỷ đô la, trở thành công ty tư nhân có giá trị nhất thế giới. Hơn nữa, công ty duy trì nhịp độ phát hành sản phẩm mạnh mẽ, bao gồm việc phát hành Sora 2 gần đây, một mô hình tạo video thế hệ tiếp theo, và ra mắt Giao thức Thương mại Agentic, một sản phẩm hợp tác với gã khổng lồ thanh toán trực tuyến Stripe. Điều này cho phép AI không chỉ tạo ra văn bản và hình ảnh mà còn trực tiếp tham gia vào các hoạt động kinh tế.

ChatGPT mở ra "kỷ nguyên ứng dụng": Apps SDK tạo ra một hệ sinh thái ứng dụng đàm thoại

Ngay sau khi công bố cột mốc 800 triệu người dùng hoạt động hàng tuần, Ultraman đã ra mắt một bản nâng cấp mang tính bước ngoặt khác: Ứng dụng trong ChatGPT và bản xem trước của SDK Ứng dụng . Động thái này trực tiếp nâng tầm định vị của ChatGPT từ "mô hình AI đơn lẻ" lên "nền tảng ứng dụng đàm thoại", đánh dấu sự gia nhập chính thức của ChatGPT vào "kỷ nguyên ứng dụng", với mục tiêu cải thiện năng suất người dùng, kích thích sáng tạo và giúp đạt được các mục tiêu cuộc sống thông qua tương tác đàm thoại.

Ứng dụng trong ChatGPT: Vượt xa các ứng dụng truyền thống để tương tác trò chuyện

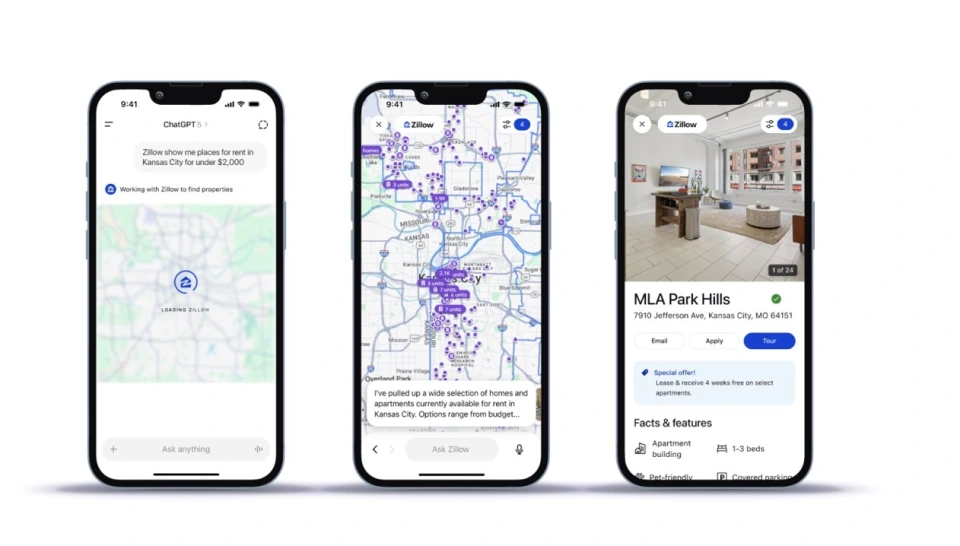

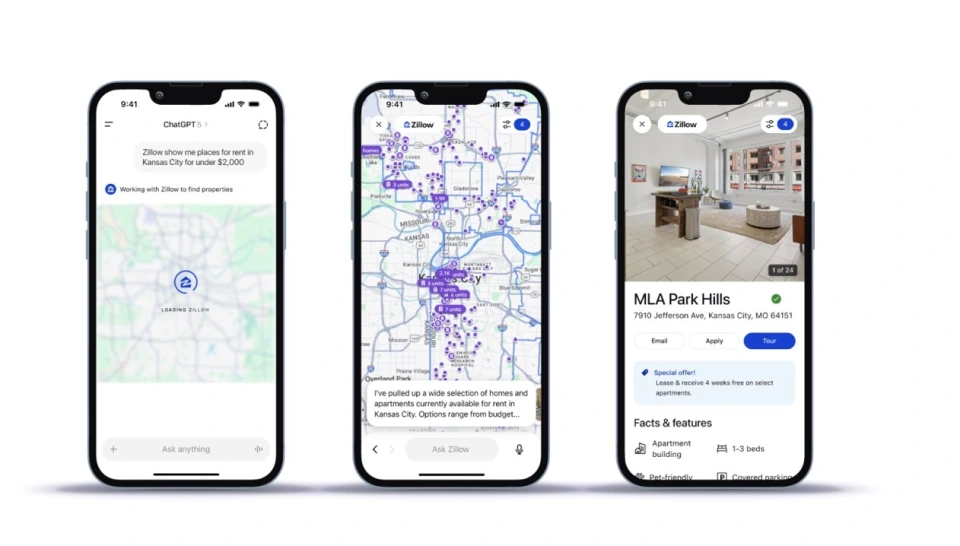

Các ứng dụng tích hợp sẵn của ChatGPT đã định hình lại hoàn toàn mô hình tương tác của các ứng dụng truyền thống. Không cần rời khỏi cửa sổ ChatGPT, các ứng dụng có thể tự động xuất hiện dựa trên ngữ cảnh hoặc được gọi trực tiếp thông qua các lệnh, mang lại tương tác liền mạch, nhận biết ngữ cảnh. Đây là một sự khác biệt rõ rệt so với Cửa hàng GPT độc lập trước đây. Ví dụ: người dùng có thể truy cập trực tiếp ứng dụng tương ứng bằng cách nhập "Figma, biến bản phác thảo này thành biểu đồ khả thi" hoặc "Coursera, dạy tôi những điều cơ bản về học máy" . Yêu cầu "danh sách phát nhạc tiệc cuối tuần" sẽ tự động kích hoạt ChatGPT truy cập Spotify. Tìm kiếm "căn hộ trong một khu vực cụ thể" sẽ kích hoạt ứng dụng Zillow tạo bản đồ tương tác và hỗ trợ chi tiết truy vấn.

Đồng thời, các ứng dụng nhúng này cũng có khả năng đa phương thức, có thể tích hợp các yếu tố tương tác như bản đồ, danh sách, slide Canva, nội dung khóa học Coursera và video được cố định ở đầu trang web, có thể điều chỉnh trong cuộc trò chuyện. Hiện tại, tính năng này mở cửa cho tất cả người dùng đã đăng nhập ChatGPT, ngoại trừ Liên minh Châu Âu, bao gồm toàn bộ gói Free, Go, Plus và Pro. Các đối tác đầu tiên bao gồm Booking.com, Canva, Coursera, Expedia, Figma, Spotify, Zillow, v.v. và sẽ được kết nối với 11 thương hiệu quốc tế như AllTrails, DoorDash, Instacart và Uber trong tương lai.

Apps SDK (Bộ phát triển phần mềm ứng dụng): Nền tảng để xây dựng các ứng dụng thế hệ tiếp theo

Công cụ cốt lõi hỗ trợ việc triển khai các ứng dụng nhúng này và xây dựng hệ sinh thái ứng dụng đối thoại là Apps SDK do OpenAI phát hành. Nó dựa trên Giao thức Bối cảnh Mô hình ( MCP).) để đảm bảo kết nối an toàn và khả năng tương tác giữa các hệ thống AI và các nguồn dữ liệu bên ngoài; nó cũng mang lại cho các nhà phát triển sự tự do phát triển hoàn toàn, hỗ trợ logic ứng dụng tùy chỉnh và giao diện tương tác trong ChatGPT, đồng thời có thể tích hợp với mã nguồn phụ trợ và hệ thống máy khách của riêng họ để duy trì tính nhất quán của thương hiệu. Quan trọng hơn, OpenAI đã khẳng định rõ ràng rằng Apps SDK sẽ hoàn toàn là mã nguồn mở, với mục tiêu tạo ra một "hệ sinh thái ứng dụng AI đa nền tảng" vượt ra ngoài bản thân ChatGPT, giảm đáng kể rào cản gia nhập cho các nhà phát triển và đặt nền tảng cho việc mở rộng hệ sinh thái.

Về mặt thương mại hóa và quy hoạch hệ sinh thái, hệ thống này đã thiết lập một chuỗi hoàn chỉnh từ phát triển, phân phối đến thương mại hóa. Việc phân phối, tận dụng lợi thế của việc ứng dụng được nhúng trực tiếp vào các cuộc trò chuyện ChatGPT, cung cấp cho các nhà phát triển một kênh hiệu quả hơn, loại bỏ nhu cầu người dùng phải tải xuống các ứng dụng riêng lẻ. Về mặt thương mại, OpenAI dự định hỗ trợ thương mại hóa ứng dụng trong ChatGPT trong tương lai, tích hợp tính năng "Thanh toán tức thì ChatGPT" đã ra mắt và cho phép các ứng dụng AI tham gia trực tiếp vào các hoạt động kinh tế như dịch vụ trả phí và thanh toán giao dịch thông qua Giao thức Thương mại Đại lý. Về việc mở rộng hệ sinh thái, OpenAI cũng có kế hoạch mở chức năng ứng dụng cho người dùng phiên bản Enterprise và Education, đồng thời ra mắt "Danh mục Ứng dụng" chuyên dụng.

Tuy nhiên, hệ sinh thái ứng dụng đàm thoại hiện tại vẫn đang đối mặt với những thách thức quan trọng. Về quyền riêng tư, mặc dù OpenAI yêu cầu các nhà phát triển "chỉ thu thập dữ liệu tối thiểu cần thiết và minh bạch về quyền", nhưng họ vẫn chưa làm rõ phạm vi dữ liệu người dùng mà các nhà phát triển có thể truy cập, bao gồm việc liệu họ có thể truy cập toàn bộ lịch sử trò chuyện, tin nhắn gần đây hay chỉ các lời nhắc của ứng dụng. Về lựa chọn dịch vụ cạnh tranh, ChatGPT hiện thiếu một cơ chế rõ ràng để lựa chọn giữa các dịch vụ cạnh tranh như DoorDash và Instacart. Mặc dù OpenAI đã tuyên bố "ưu tiên trải nghiệm người dùng", nhưng họ vẫn chưa làm rõ liệu có bất kỳ mô hình kinh doanh nào, chẳng hạn như "ưu tiên trả phí" hay không. Những vấn đề này cần được làm rõ thêm để thúc đẩy sự phát triển lành mạnh của hệ sinh thái.

Ra mắt AgentKit: Chuyển đổi từ công cụ sang hệ sinh thái đại lý thông minh

Altman cũng đã phát hành một sản phẩm bom tấn, AgentKit. Bộ công cụ này bao quát toàn bộ vòng đời "xây dựng, triển khai, tối ưu hóa và kết nối" các tác nhân AI. Điểm hấp dẫn cốt lõi của nó là phá vỡ thế tiến thoái lưỡng nan của "sự phát triển rời rạc và rào cản gia nhập cao" trong quá trình phát triển các tác nhân cấp doanh nghiệp trước đây, đồng thời nâng cấp nó lên một mô hình thực hành kỹ thuật có hệ thống và hiệu quả, thúc đẩy các tác nhân AI từ "công cụ phụ trợ" trở thành phương tiện thực thi cốt lõi trong các quy trình doanh nghiệp. Đây cũng là một cột mốc quan trọng trong định hướng hệ sinh thái tác nhân thông minh của OpenAI.

Altman đã tuyên bố rõ ràng rằng AgentKit là "một bộ các khối xây dựng hoàn chỉnh trong Nền tảng OpenAI, bao gồm mọi thứ cần thiết để xây dựng, triển khai và tối ưu hóa quy trình làm việc của tác nhân thông minh. Điều này giảm đáng kể sự trì trệ trong quá trình phát triển và giúp các nhà phát triển nhanh chóng đưa tác nhân từ nguyên mẫu lên sản xuất." Động thái này không chỉ là một sáng kiến quan trọng của OpenAI nhằm tăng cường sự chấp nhận của các nhà phát triển mà còn tạo ra một lợi thế khác biệt trong bối cảnh nền tảng AI cạnh tranh. Trước sự bùng nổ của các công cụ tích hợp tác nhân thông minh, AgentKit, với trọng tâm cốt lõi là "phạm vi bao phủ toàn bộ quy trình và hoạt động ngưỡng thấp", giải quyết những điểm khó khăn thực tế của các doanh nghiệp khi xây dựng các tác nhân tự động có thể thực hiện các tác vụ phức tạp, thay vì chỉ đơn thuần phản hồi lời nhắc.

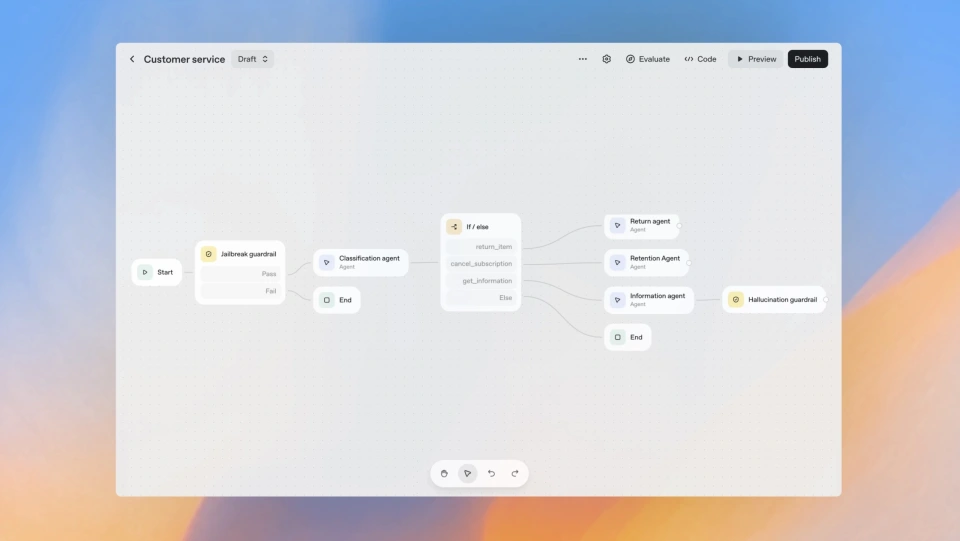

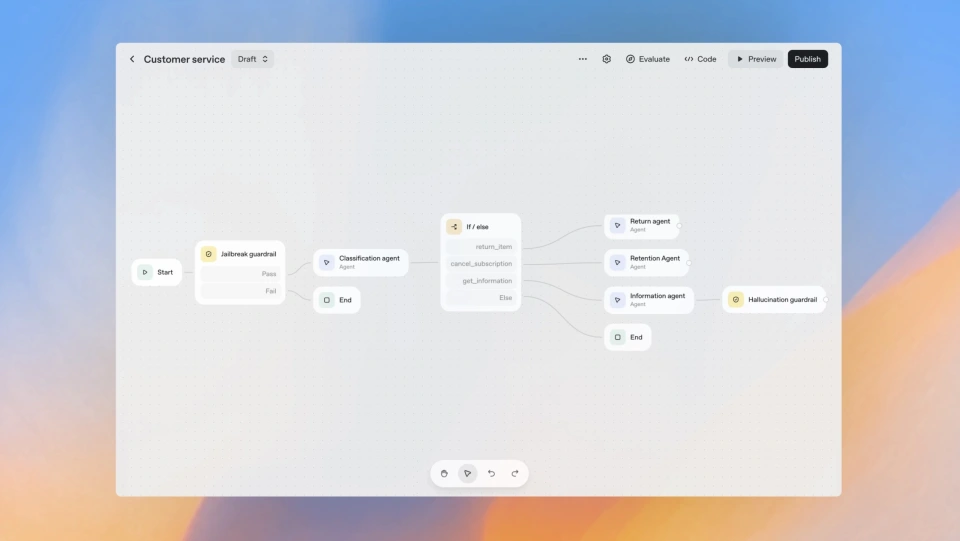

Các mô-đun chức năng cốt lõi của AgentKit hoạt động cùng nhau để tạo thành một hệ thống phát triển agent hoàn chỉnh. Đầu tiên là Agent Builder, được Altman ví như "Canva của phát triển agent". Thông qua một khung vẽ trực quan và giao diện kéo thả, các nhà phát triển có thể thiết kế logic, các bước và kết nối agent với các công cụ bên ngoài mà không cần mã hóa phức tạp. Hỗ trợ kiểm soát phiên bản đầy đủ, AgentKit giúp đơn giản hóa đáng kể việc điều phối các quy trình làm việc phức tạp của nhiều agent, vốn trước đây đòi hỏi nhiều tháng viết mã tùy chỉnh.

Agent Builder cũng bao gồm mô-đun Guardrails (vòng bảo mật) mã nguồn mở, dạng mô-đun, giúp ngăn chặn hiệu quả các hành vi độc hại của tác nhân, phát hiện các cuộc tấn công bẻ khóa và che giấu thông tin nhạy cảm, đảm bảo tính tuân thủ và độ tin cậy cho các triển khai cấp doanh nghiệp. Công ty công nghệ tài chính Ramp đã tận dụng công cụ này để chuyển đổi một quy trình mua sắm phức tạp thành một tác nhân có thể chạy được chỉ trong vài giờ, giảm chu kỳ lặp lại khoảng 70%, chứng minh giá trị hiệu quả của nó.

Thành phần thứ hai là Connector Registry, một cổng quản trị dữ liệu cấp doanh nghiệp cung cấp cho các tổ chức lớn một nền tảng quản lý thống nhất để kết nối các tác nhân với các hệ thống bên ngoài. Quản trị viên có thể xem và cấu hình tập trung tất cả các kết nối dữ liệu trong các tổ chức ChatGPT và API từ một bảng điều khiển duy nhất, bao gồm các trình kết nối được xây dựng sẵn như Dropbox, Google Drive, SharePoint và Microsoft Teams, cũng như các giao diện MCP của bên thứ ba. Bảng điều khiển Quản trị Toàn cầu cũng cho phép quản lý tập trung tên miền, đăng nhập một lần (SSO) và nhiều tổ chức API, đảm bảo quyền truy cập dữ liệu chi tiết và an toàn.

Thứ ba là ChatKit, tập trung vào việc giải quyết vấn đề "chặng đường cuối" của việc triển khai tác nhân. Bộ công cụ dễ sử dụng này cho phép các nhà phát triển nhanh chóng nhúng giao diện tác nhân dựa trên trò chuyện vào ứng dụng hoặc trang web của riêng họ. Nó hỗ trợ các chủ đề thương hiệu có thể tùy chỉnh, xử lý phản hồi trực tuyến và quản lý luồng, tích hợp liền mạch trải nghiệm tương tác của tác nhân với giao diện gốc của thương hiệu. Ví dụ: nền tảng thiết kế Canva đã tích hợp một tác nhân thân thiện với nhà phát triển thông qua ChatKit chỉ trong một giờ, cải thiện đáng kể hiệu quả tương tác của người dùng với tài liệu.

Để đảm bảo độ tin cậy ở cấp độ sản xuất, AgentKit cũng tích hợp phiên bản nâng cấp của Evals for Agents, một hệ thống đánh giá hiệu suất có hệ thống. Mô-đun này bao gồm Trace Grading, cho phép đánh giá toàn diện quy trình làm việc của tác nhân, xác định điểm yếu trong các chuỗi quyết định phức tạp. Nó cũng cung cấp các tập dữ liệu chuyên dụng để đánh giá từng thành phần và Automated Prompt Optimization, tự động tạo ra các lời nhắc được cải thiện dựa trên các chú thích và điểm số thủ công, hoàn thành chu trình đánh giá-tối ưu hóa. Hơn nữa, nó hỗ trợ chạy đánh giá trực tiếp trên các mô hình bên ngoài từ nền tảng OpenAI, phá vỡ các hạn chế của mô hình và thiết lập nó như một tiêu chuẩn phù hợp với ngành để đánh giá tác nhân.

Để chứng minh tính dễ sử dụng của AgentKit, kỹ sư Christina Huang của OpenAI đã trình diễn trực tiếp tại hội nghị: chỉ trong tám phút, cô đã hoàn thành quy trình làm việc AI hoàn chỉnh và xây dựng được hai tác nhân AI. Altman phát biểu: "AgentKit là công cụ mà chúng tôi mong muốn có khi cố gắng xây dựng các tác nhân đầu tiên." Một số đối tác đã đăng ký sử dụng công cụ này để mở rộng các kịch bản ứng dụng.

AgentKit cũng tích hợp các khả năng đào sâu mô hình: Reinforcement Fine-Tuning (RFT), hiện đã có sẵn đầy đủ cho mô hình o4-mini và bản beta riêng tư cho mô hình GPT-5, tận dụng các Lệnh Gọi Công Cụ Tùy Chỉnh để lựa chọn chính xác các công cụ huấn luyện mô hình. Các Trình Phân Loại Tùy Chỉnh sẽ liên kết việc tối ưu hóa mô hình với các mục tiêu kinh doanh, nâng cao hơn nữa khả năng suy luận và khả năng thích ứng của tác nhân với các tình huống cụ thể, đặt nền tảng kỹ thuật vững chắc cho sự phát triển lâu dài của hệ sinh thái tác nhân.

Bản phát hành chính thức của Codex: Biến AI thành "Nhà phát triển thứ hai" của Nhóm Kỹ thuật

Altman cũng công bố phiên bản đầy đủ của Codex, trợ lý lập trình thông minh, và ra mắt ba công cụ được tích hợp sâu vào quy trình làm việc của doanh nghiệp. Bản phát hành này không chỉ đánh dấu bước tiến chính thức của Codex từ một "công cụ hỗ trợ lập trình" thành "đối tác phát triển cộng tác" cho các nhóm kỹ thuật, mà còn tái cấu trúc hoàn toàn mô hình cộng tác hàng ngày của nhóm kỹ thuật, thúc đẩy sự cải thiện vượt bậc về hiệu quả R&D và biến AI thành "nhà phát triển thứ hai" thực sự đáng tin cậy trong nhóm.

Trọng tâm của bản phát hành này là phiên bản chính thức của Codex, được hỗ trợ bởi mô hình cốt lõi GPT-5-Codex, hiện đã có thể truy cập đầy đủ. Nhờ hiệu suất mạnh mẽ, mô hình này đã trở thành một trong những mô hình phát triển nhanh nhất của OpenAI, xử lý hơn 40 nghìn tỷ token chỉ trong ba tuần. Về mặt ứng dụng thực tế, hơn 90% kỹ sư OpenAI đã tích hợp Codex vào quy trình làm việc hàng ngày của họ. So với dữ liệu tháng 7, số lượng yêu cầu kéo được hợp nhất hàng tuần của nhóm đã tăng 70% và chức năng đánh giá tự động của Codex hiện bao gồm gần như tất cả các thay đổi mã. Codex có thể chủ động xác định các lỗ hổng cú pháp tiềm ẩn, rủi ro logic và các vấn đề quan trọng khác, giúp giảm đáng kể chi phí gỡ lỗi sau này và chứng minh giá trị của nó trong việc cải thiện hiệu quả kỹ thuật.

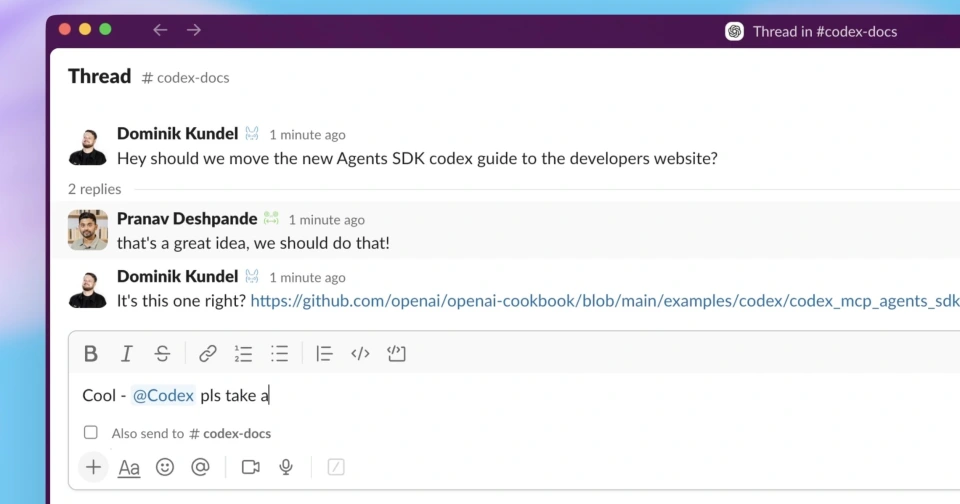

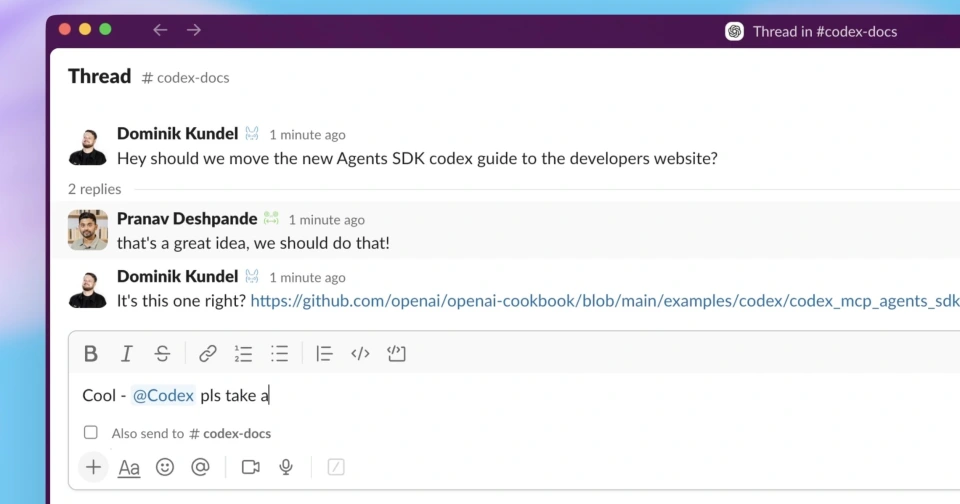

Tính năng tích hợp Slack mới ra mắt là một bước đột phá quan trọng trong quá trình chuyển đổi Codex từ một "công cụ" thành một "đồng nghiệp ảo". Các nhà phát triển không cần phải chuyển đổi nền tảng; chỉ cần gắn thẻ @Codex trong kênh Slack hoặc chuỗi hội thoại, Codex sẽ tự động trích xuất ngữ cảnh hội thoại, hiểu chính xác các yêu cầu phát triển, nhanh chóng thực hiện các tác vụ như tạo mã và xử lý sự cố, đồng thời trả về liên kết đến tác vụ mã để có thể tiếp tục chỉnh sửa hoặc hợp nhất trực tiếp trên Codex Cloud. Thiết kế này hoàn toàn phá vỡ rào cản giữa các công cụ AI và các tình huống cộng tác nhóm, biến Codex thành một "cộng tác viên nội bộ" trong các cuộc họp nhóm kỹ thuật và giao tiếp hàng ngày lần đầu tiên, thay vì một ứng dụng bên ngoài cần được mở riêng biệt, giúp thu hẹp hơn nữa khoảng cách giữa AI và quy trình làm việc nhóm.

Codex SDK cung cấp cho doanh nghiệp và nhà phát triển một cổng cốt lõi để nhúng các khả năng AI vào quy trình làm việc của họ. Bộ công cụ này tích hợp liền mạch các tác nhân hiệu suất cao, tương tự như Codex CLI, vào các hệ thống kỹ thuật doanh nghiệp, công cụ phát triển và ứng dụng kinh doanh. Nó cũng bao gồm các tính năng tích hợp như đầu ra có cấu trúc, quản lý ngữ cảnh tích hợp và phục hồi luồng phiên. Các nhà phát triển có thể gọi các tác nhân này chỉ với một vài dòng mã, giúp giảm đáng kể rào cản tích hợp.

Đồng thời, SDK được phát hành cùng với thành phần GitHub Action mới: Thông qua thành phần này, Codex có thể được kết nối trực tiếp với quy trình CI/CD để đạt được tự động hóa toàn bộ quy trình đánh giá mã, xây dựng tự động, xác minh triển khai và các liên kết khác, thực sự đưa khả năng AI vào mọi nút chính của vòng đời phát triển phần mềm.

Đối với người dùng thương mại, giáo dục và doanh nghiệp, OpenAI đã đồng thời ra mắt các công cụ quản lý và giám sát cấp doanh nghiệp để bảo vệ việc triển khai Codex trên quy mô lớn. Ở cấp độ kiểm soát môi trường, quản trị viên có thể trực tiếp chỉnh sửa hoặc xóa môi trường phát triển đám mây, dọn dẹp các phiên bản không sử dụng và xóa thông tin cấu hình nhạy cảm để tránh lãng phí tài nguyên và rủi ro rò rỉ dữ liệu. Về bảo mật và tuân thủ, một nền tảng cấu hình tập trung cho phép kiểm soát chi tiết quyền truy cập cho các CLI cục bộ và plugin IDE, đồng thời giám sát hành vi vận hành theo thời gian thực để đảm bảo tuân thủ các quy định bảo mật dữ liệu của doanh nghiệp.

Ngoài ra, Bảng điều khiển phân tích mới có thể theo dõi hoạt động sử dụng Codex trên nhiều nền tảng, bao gồm CLI, IDE và Web, đồng thời cung cấp các chỉ số định lượng như độ chính xác của việc xem xét mã và hiệu quả hoàn thành nhiệm vụ, giúp người quản lý đánh giá trực quan sự đóng góp thực tế của AI vào năng suất kỹ thuật và cung cấp hỗ trợ dữ liệu để phân bổ tài nguyên và tối ưu hóa quy trình.

Nâng cấp Ma trận Mô hình API: GPT-5 Pro, Sora 2 và Mô hình Giọng nói Nhẹ giúp Mở rộng Hệ sinh thái Nhà phát triển

OpenAI cũng công bố các bản cập nhật lớn cho hệ thống API của mình, bao gồm mô hình ngôn ngữ GPT-5 Pro, mô hình tạo video Sora 2 và mô hình giọng nói nhẹ "gpt-realtime mini". Những nâng cấp mô hình này, cùng với các công cụ xây dựng tác nhân đã phát hành trước đó và khả năng ứng dụng nhúng ChatGPT, tạo thành một sáng kiến cốt lõi của OpenAI nhằm thu hút các nhà phát triển và phát triển hệ sinh thái của mình, hướng đến mục tiêu cung cấp cho các nhà phát triển trong nhiều lĩnh vực khả năng AI linh hoạt và tiết kiệm chi phí hơn.

Open GPT-5 Pro API: Tập trung vào các tình huống "Độ chính xác cao và Lý luận sâu sắc"

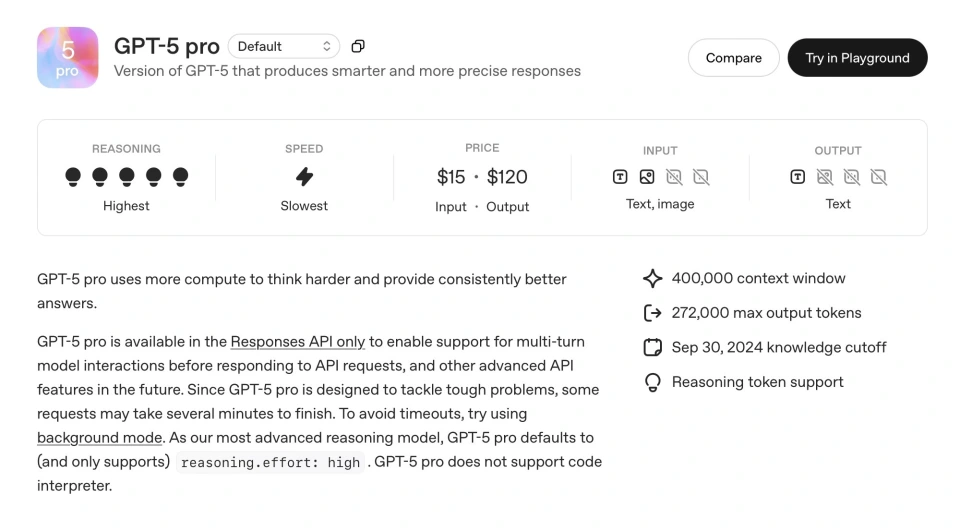

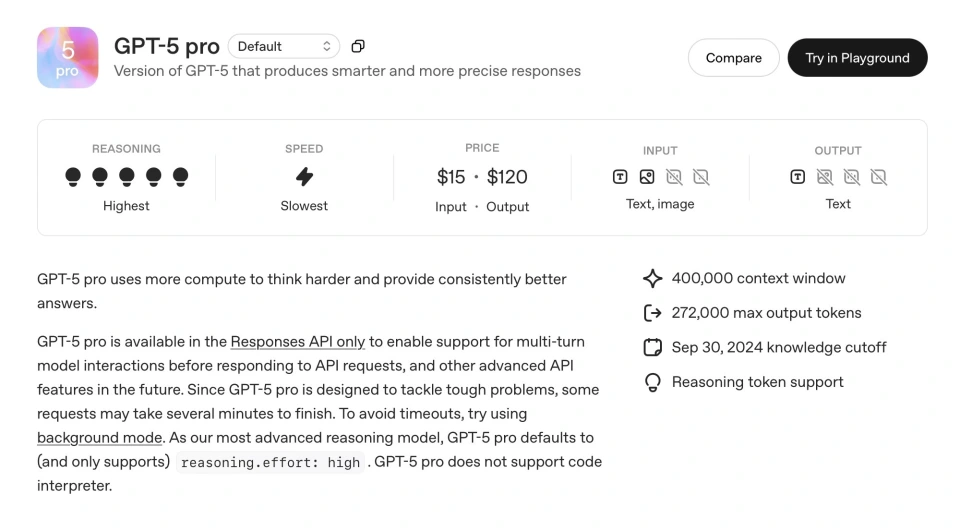

Là mô hình ngôn ngữ cốt lõi cho bản cập nhật API này, GPT-5 Pro là phiên bản nâng cấp của GPT-5, được thiết kế để cung cấp phản hồi thông minh hơn và chính xác hơn, tập trung vào các kịch bản "có độ chính xác cao và suy luận sâu". Altman cho biết mô hình này sẽ đặc biệt hấp dẫn các nhà phát triển trong các ngành như tài chính, luật và chăm sóc sức khỏe, những ngành đòi hỏi độ chính xác cao nhất trong suy luận AI. Các ứng dụng như mô hình định giá rủi ro trong tài chính, phân tích chuyên sâu các điều khoản hợp đồng trong lĩnh vực pháp lý và phân tích dữ liệu ca bệnh trong các tình huống y tế sẽ được hưởng lợi từ khả năng suy luận mạnh mẽ của GPT-5 Pro, cải thiện hiệu quả phát triển và độ tin cậy của ứng dụng, lấp đầy khoảng trống về khả năng trước đây chỉ dành cho các mô hình đa năng trong các lĩnh vực chuyên môn cao.

Khả năng cốt lõi và hiệu suất

GPT-5 Pro có tốc độ suy luận chậm nhất vì nó sử dụng nhiều tài nguyên tính toán hơn cho tư duy sâu hơn, đảm bảo câu trả lời nhất quán và chất lượng cao hơn. Là mô hình suy luận tiên tiến nhất, nó mặc định và chỉ hỗ trợ chế độ "nỗ lực cao".

Vì được thiết kế để xử lý các tác vụ khó và phức tạp, một số yêu cầu có thể mất vài phút để hoàn tất. Để tránh tình trạng hết thời gian chờ, OpenAI khuyến nghị các nhà phát triển nên thử sử dụng chế độ nền.

Tham số, chế độ và hỗ trợ công cụ

GPT-5 Pro có cửa sổ ngữ cảnh lên đến 400.000 token và đầu ra tối đa là 272.000 token. Ngày hết hạn kiến thức là 30/9/2024.

Về mặt hỗ trợ phương thức, nó chấp nhận văn bản và hình ảnh làm đầu vào và xuất văn bản. Nó không hỗ trợ bất kỳ khả năng xử lý âm thanh hoặc video nào.

Mô hình này chỉ khả dụng thông qua API Responses (v1/responses). Nó hỗ trợ các lệnh gọi hàm và đầu ra có cấu trúc, nhưng không hỗ trợ phát trực tuyến, tinh chỉnh hoặc chắt lọc. Về mặt công cụ, nó hỗ trợ tìm kiếm trên web, tìm kiếm tệp, tạo hình ảnh và MCP, nhưng không hỗ trợ trình thông dịch mã hoặc công cụ sử dụng máy tính.

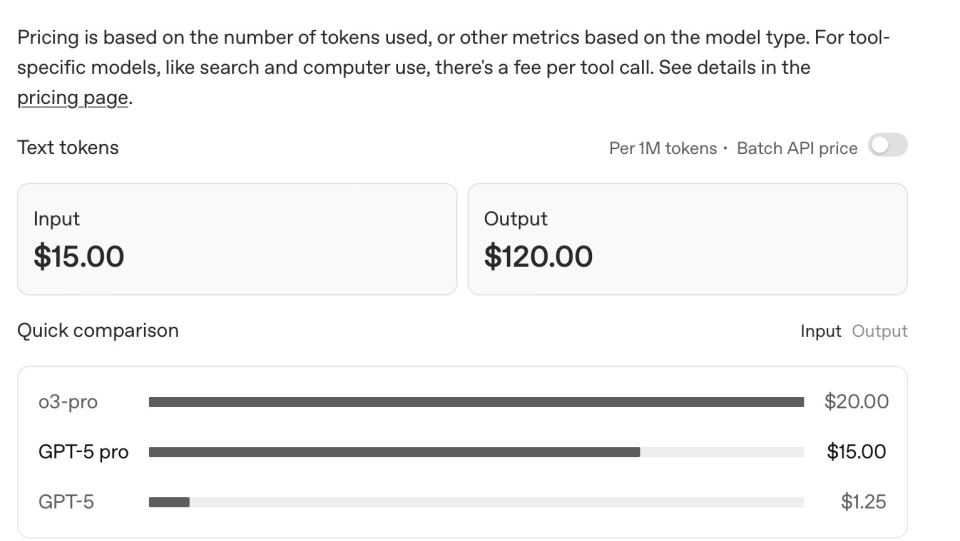

Giá cả và giới hạn tỷ lệ

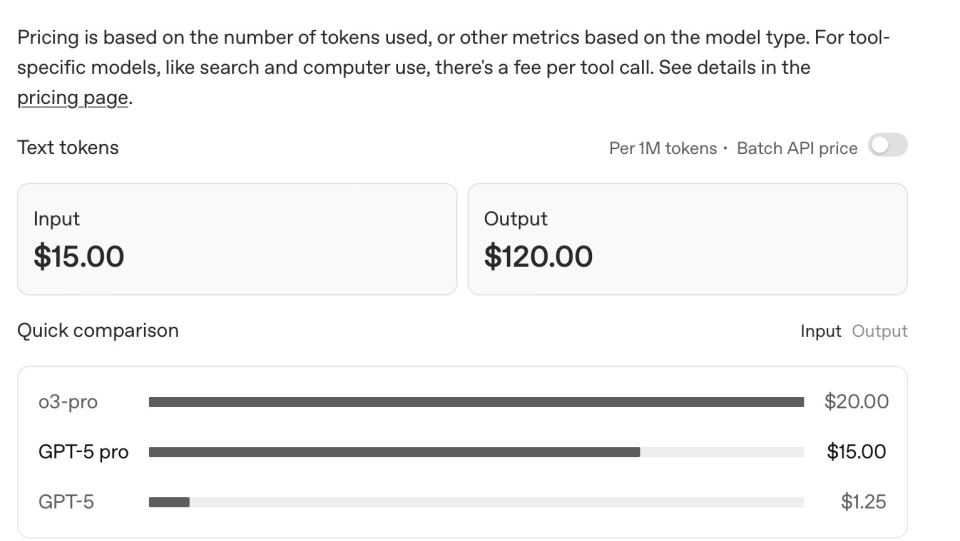

GPT-5 Pro có giá dựa trên mức sử dụng mã thông báo: 15 đô la cho 1 triệu mã thông báo đầu vào và 120 đô la cho 1 triệu mã thông báo đầu ra.

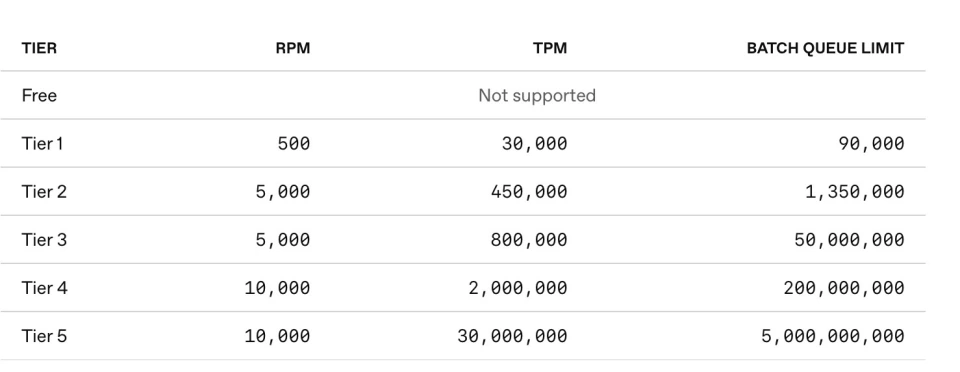

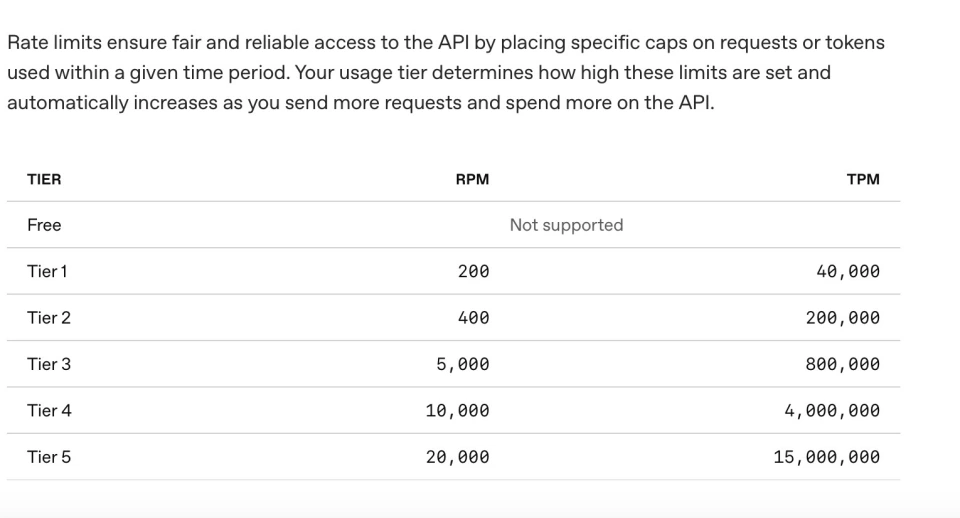

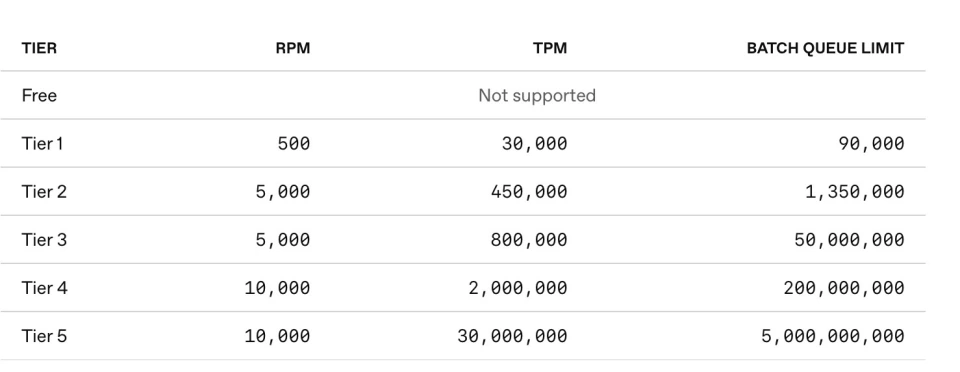

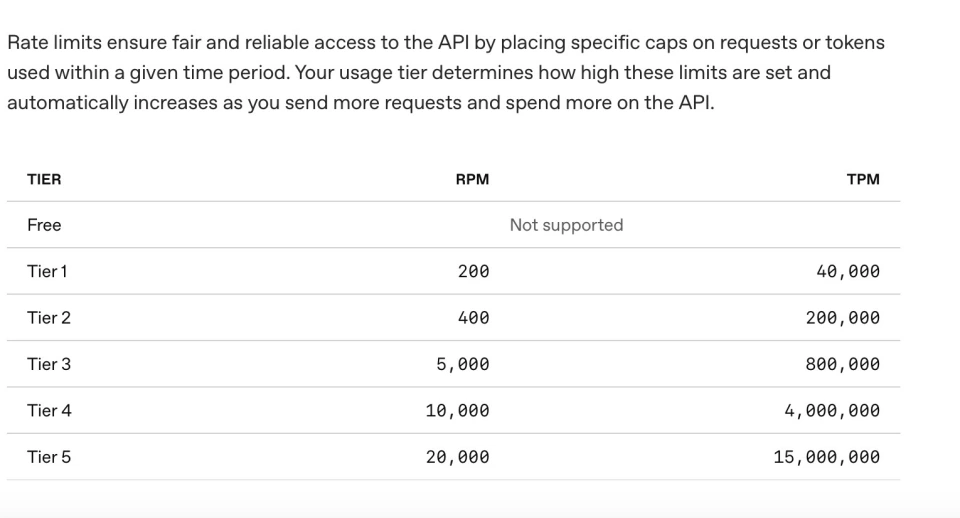

Quyền truy cập API phải tuân theo giới hạn tốc độ. Các giới hạn này được xác định theo cấp độ sử dụng của bạn và tự động tăng lên khi mức sử dụng và chi tiêu cho API tăng lên. Ví dụ: cấp độ cao nhất, Cấp độ 5, có giới hạn là 10.000 yêu cầu mỗi phút và 30 triệu token.

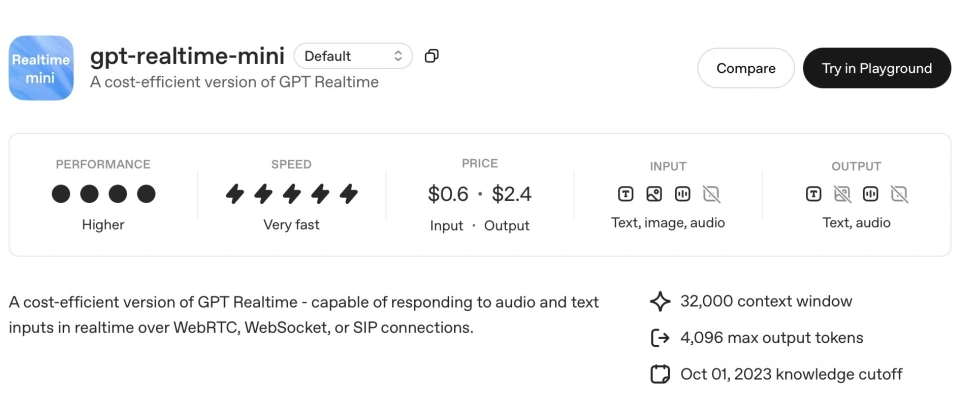

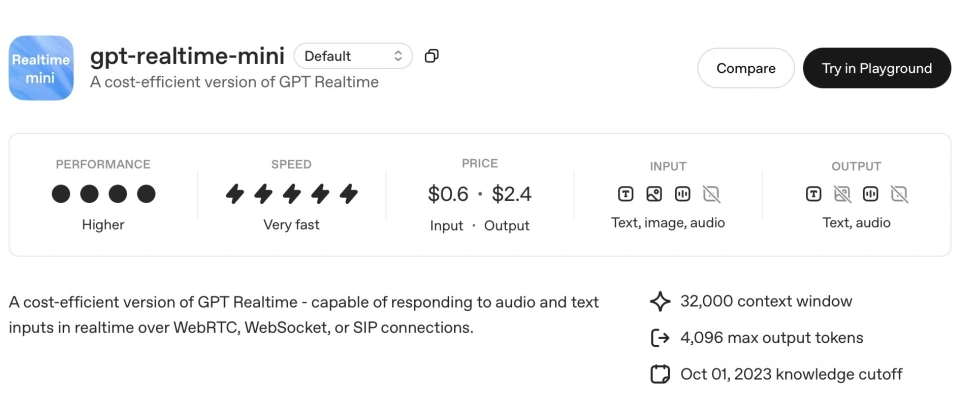

Mô hình giọng nói rút gọn GPT-Realtime-Mini: Ưu điểm cốt lõi: Giảm chi phí và cải thiện hiệu quả

Để giải quyết vấn đề tương tác bằng giọng nói, một hình thức tương tác AI ngày càng quan trọng, OpenAI đã phát hành mô hình giọng nói "GPT-Realtime-Mini" gọn nhẹ trong API của mình. GPT-Realtime-Mini là phiên bản tiết kiệm chi phí của GPT Realtime, được thiết kế riêng cho hình thức tương tác AI ngày càng quan trọng này. Ưu điểm cốt lõi của nó nằm ở việc giảm chi phí và tăng hiệu quả: so với mô hình giọng nói tiên tiến trước đây của OpenAI, mô hình này giảm đáng kể 70% chi phí mà vẫn duy trì chất lượng giọng nói và khả năng biểu cảm tương tự.

Mô hình này cung cấp tốc độ vượt trội và hiệu suất được cải thiện. Nó phản hồi âm thanh và văn bản đầu vào theo thời gian thực thông qua các kết nối như WebRTC, WebSocket hoặc SIP. Nó hỗ trợ tương tác phát trực tuyến độ trễ thấp cho âm thanh và giọng nói, lý tưởng cho các tình huống nhạy cảm với phản hồi như dịch vụ khách hàng thời gian thực, trợ lý thông minh và giọng nói trong xe hơi. Điều này giúp giảm đáng kể rào cản gia nhập cho các nhà phát triển vừa và nhỏ để phát triển các ứng dụng AI dựa trên giọng nói chất lượng cao.

Hỗ trợ tham số và phương thức

Mô hình có cửa sổ ngữ cảnh là 32.000 mã thông báo và số lượng mã thông báo đầu ra tối đa là 4.096. Ngày hết hạn kiến thức của mô hình là ngày 1 tháng 10 năm 2023.

Về mặt hỗ trợ phương thức, nó hỗ trợ nhập và xuất văn bản và âm thanh, cũng như nhập hình ảnh, nhưng không hỗ trợ video.

Sử dụng API và các tính năng

Mô hình này có sẵn thông qua nhiều điểm cuối bao gồm hoàn tất trò chuyện, phản hồi và thời gian thực (v1/thời gian thực).

GPT-Realtime-Mini không hỗ trợ bất kỳ tính năng nâng cao nào như lệnh gọi hàm, đầu ra có cấu trúc, tinh chỉnh, chưng cất hoặc đầu ra dự đoán.

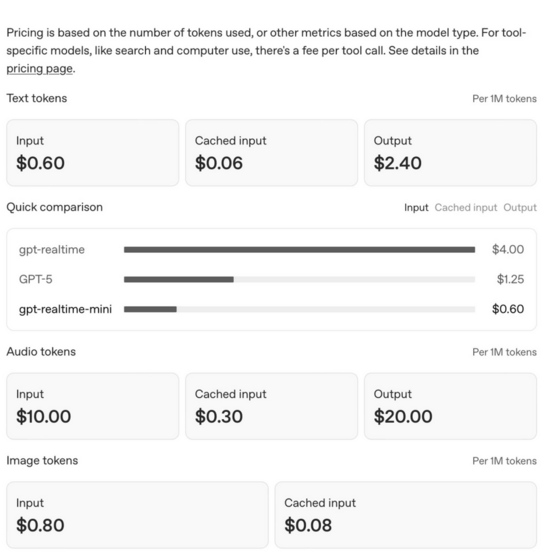

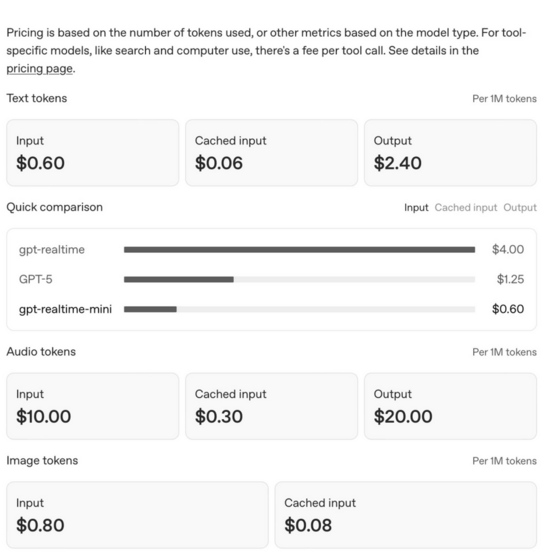

Giá cả và giới hạn tỷ lệ

Giá của các mô hình liên quan được tính dựa trên mức sử dụng token. Các tiêu chuẩn thanh toán cụ thể được thiết lập theo phân loại token văn bản và token âm thanh:

Tỷ lệ thanh toán cho mã thông báo văn bản là: 0,60 đô la cho 1 triệu mã thông báo đầu vào, 0,06 đô la cho 1 triệu mã thông báo đầu vào được lưu trong bộ nhớ đệm và 2,40 đô la cho 1 triệu mã thông báo đầu ra; tỷ lệ thanh toán cho mã thông báo âm thanh là: 10 đô la cho 1 triệu mã thông báo đầu vào, 0,30 đô la cho 1 triệu mã thông báo đầu vào được lưu trong bộ nhớ đệm và 20 đô la cho 1 triệu mã thông báo đầu ra.

Quyền truy cập API phải tuân theo giới hạn tốc độ. Các giới hạn này được xác định theo cấp độ sử dụng của người dùng và tự động tăng lên khi mức sử dụng và chi tiêu của người dùng cho API tăng lên. Ví dụ: cấp độ cao nhất, Cấp độ 5, có giới hạn là 20.000 yêu cầu mỗi phút (RPM) và 15 triệu token mỗi phút (TPM).

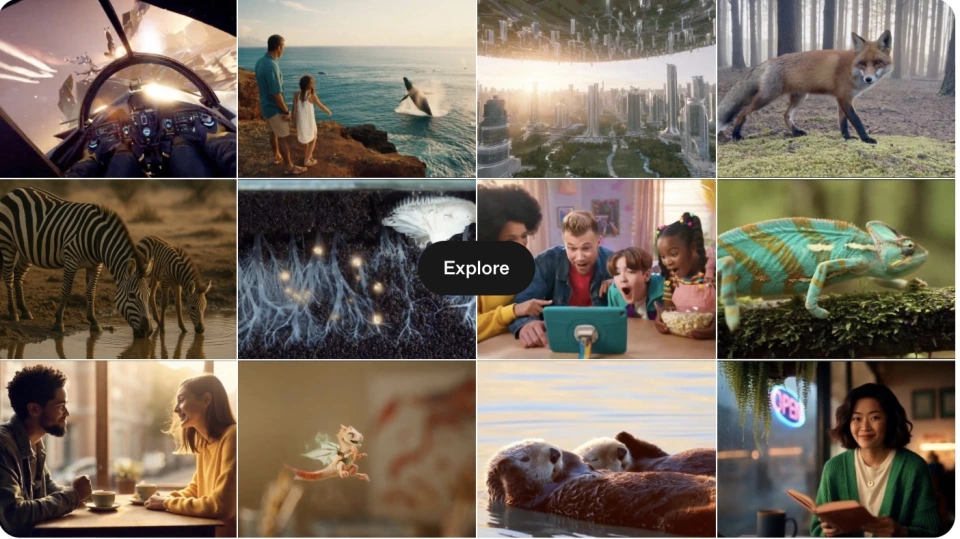

Mở quyền xem trước API Sora 2

Sora 2, mô hình tạo video được phát hành vào ngày 30 tháng 9, cũng đã mở bản xem trước API cho hệ sinh thái nhà phát triển. Các nhà phát triển có thể trực tiếp gọi mô hình cốt lõi điều khiển Sora 2 trong ứng dụng của riêng họ, tích hợp khả năng tạo video của nó vào các kịch bản sản phẩm.

API Sora cung cấp năm điểm cuối cốt lõi bao gồm toàn bộ quá trình tạo video:

Tạo video: Bắt đầu tác vụ kết xuất video mới bằng cách sử dụng từ gợi ý, tham chiếu tùy chọn hoặc ID phối lại.

Nhận trạng thái video: truy xuất trạng thái hiện tại của tác vụ kết xuất và theo dõi tiến trình theo thời gian thực;

Tải xuống video: Sau khi hoàn thành nhiệm vụ, hãy tải xuống tệp video định dạng MP4 cuối cùng;

Liệt kê video: Hỗ trợ phân trang để liệt kê các video lịch sử, thuận tiện cho việc quản lý trong bảng điều khiển hoặc thư viện tài nguyên;

Xóa video: Xóa video đã chỉ định khỏi bộ nhớ OpenAI, giải phóng tài nguyên.

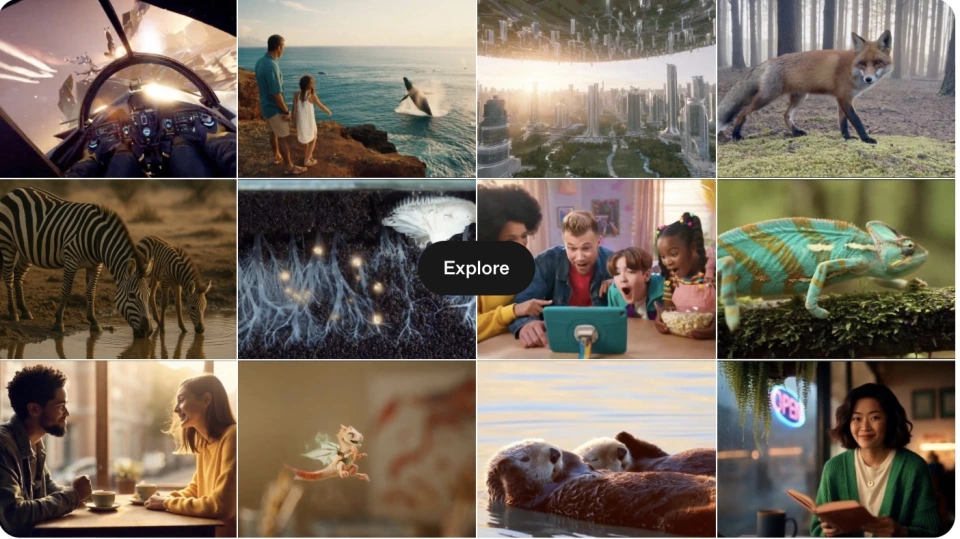

Altman giới thiệu rằng Sora 2 đã đạt được những nâng cấp đa chiều dựa trên thế hệ trước: trình bày cảnh thực tế hơn và logic vật lý nhất quán hơn, đồng thời hỗ trợ các điều chỉnh sáng tạo sâu sắc từ điều khiển hướng ống kính đến tùy chỉnh phong cách hình ảnh, chẳng hạn như "mở rộng vật liệu từ góc nhìn của iPhone thành ống kính góc rộng điện ảnh"; quan trọng hơn, mô hình đạt được "sự kết hợp chính xác giữa âm thanh và hình ảnh", không chỉ có thể tạo ra giọng nói đồng bộ mà còn xây dựng các cảnh quan âm thanh môi trường phong phú và hiệu ứng âm thanh dựa trên cảnh, cho phép nâng cấp nội dung video từ "trình bày hình ảnh" thành "trải nghiệm nhập vai về âm thanh và hình ảnh được phối hợp".

Xét về giá trị ứng dụng, Sora 2 được định vị là "công cụ phát triển ý tưởng liên ngành". Trong quảng cáo, nó có thể tạo ra các ý tưởng sáng tạo trực quan dựa trên bầu không khí sản phẩm. Các nhà thiết kế tại các nhà sản xuất đồ chơi như Mattel đang sử dụng Sora 2 để biến các bản phác thảo thành các ý tưởng đồ chơi cụ thể. (OpenAI cũng đã tận dụng cơ hội này để công bố sự hợp tác với Mattel, thúc đẩy việc tích hợp AI tạo sinh vào các quy trình sản xuất truyền thống.) Khả năng chuyển đổi nhanh chóng các ý tưởng từ khái niệm sang triển khai này mang đến cho các nhà phát triển trong ngành thương mại điện tử, truyền thông và sản xuất một cách tiếp cận mới trong sản xuất nội dung và thiết kế sản phẩm.

Bản chất của bản nâng cấp ma trận mô hình API này là sự trao quyền sâu sắc của OpenAI cho hệ sinh thái nhà phát triển: bằng cách bao phủ các khả năng toàn phương thức của "lý luận ngôn ngữ, tương tác giọng nói và tạo video", kết hợp với thiết kế phân lớp mô hình "độ chính xác cao, nhẹ và tiết kiệm chi phí", nó đáp ứng các nhu cầu khác biệt của các nhà phát triển ở các quy mô khác nhau và trong các lĩnh vực khác nhau; và việc mở bản xem trước API của các mô hình bom tấn như Sora 2 là một cách tiếp cận "tải trước khả năng" để thu hút các nhà phát triển thực hiện các sắp xếp sớm, thúc đẩy việc triển khai các ứng dụng sáng tạo dựa trên công nghệ OpenAI và củng cố hơn nữa vị trí cốt lõi của nó trong hệ sinh thái nhà phát triển AI. #OpenAIDevDay

Trong bài phát biểu khai mạc hội nghị, Altman cho biết: “Hiện nay, hơn 4 triệu nhà phát triển đang xây dựng các sản phẩm OpenAI; hơn 800 triệu người sử dụng ChatGPT mỗi tuần, và API của chúng tôi xử lý hơn 6 tỷ token mỗi phút. Tôi xin cảm ơn tất cả các nhà phát triển và người dùng đã giúp chúng tôi biến AI từ một ‘đồ chơi’ thành một ‘công cụ’ thực sự.”

Dữ liệu đáng kinh ngạc này tiếp tục đà tăng trưởng nhanh chóng của OpenAI trong năm qua. Altman chỉ ra rằng sự tăng trưởng này không chỉ phản ánh nhu cầu mạnh mẽ từ người tiêu dùng mà còn phản ánh sự tích hợp ChatGPT trên quy mô lớn của các nhà phát triển và doanh nghiệp vào sản phẩm và quy trình làm việc của họ. Ông nhấn mạnh rằng thế hệ công cụ dành cho nhà phát triển tiếp theo sẽ hỗ trợ việc xây dựng các ứng dụng tương tác, thích ứng và cá nhân hóa trực tiếp trong ChatGPT, đồng thời sẽ tạo ra một thế hệ kiến trúc "hệ thống đại lý" mới có thể giao tiếp với người dùng theo thời gian thực, hiểu ngữ cảnh và hoạt động tự chủ, đặt nền tảng vững chắc cho "kỷ nguyên ứng dụng AI".

Về mặt thương mại, tuần trước, OpenAI đã hoàn tất giao dịch vốn cổ phần tư nhân trị giá 6,6 tỷ đô la, nâng định giá lên 500 tỷ đô la, trở thành công ty tư nhân có giá trị nhất thế giới. Hơn nữa, công ty duy trì nhịp độ phát hành sản phẩm mạnh mẽ, bao gồm việc phát hành Sora 2 gần đây, một mô hình tạo video thế hệ tiếp theo, và ra mắt Giao thức Thương mại Agentic, một sản phẩm hợp tác với gã khổng lồ thanh toán trực tuyến Stripe. Điều này cho phép AI không chỉ tạo ra văn bản và hình ảnh mà còn trực tiếp tham gia vào các hoạt động kinh tế.

ChatGPT mở ra "kỷ nguyên ứng dụng": Apps SDK tạo ra một hệ sinh thái ứng dụng đàm thoại

Ngay sau khi công bố cột mốc 800 triệu người dùng hoạt động hàng tuần, Ultraman đã ra mắt một bản nâng cấp mang tính bước ngoặt khác: Ứng dụng trong ChatGPT và bản xem trước của SDK Ứng dụng . Động thái này trực tiếp nâng tầm định vị của ChatGPT từ "mô hình AI đơn lẻ" lên "nền tảng ứng dụng đàm thoại", đánh dấu sự gia nhập chính thức của ChatGPT vào "kỷ nguyên ứng dụng", với mục tiêu cải thiện năng suất người dùng, kích thích sáng tạo và giúp đạt được các mục tiêu cuộc sống thông qua tương tác đàm thoại.

Ứng dụng trong ChatGPT: Vượt xa các ứng dụng truyền thống để tương tác trò chuyện

Các ứng dụng tích hợp sẵn của ChatGPT đã định hình lại hoàn toàn mô hình tương tác của các ứng dụng truyền thống. Không cần rời khỏi cửa sổ ChatGPT, các ứng dụng có thể tự động xuất hiện dựa trên ngữ cảnh hoặc được gọi trực tiếp thông qua các lệnh, mang lại tương tác liền mạch, nhận biết ngữ cảnh. Đây là một sự khác biệt rõ rệt so với Cửa hàng GPT độc lập trước đây. Ví dụ: người dùng có thể truy cập trực tiếp ứng dụng tương ứng bằng cách nhập "Figma, biến bản phác thảo này thành biểu đồ khả thi" hoặc "Coursera, dạy tôi những điều cơ bản về học máy" . Yêu cầu "danh sách phát nhạc tiệc cuối tuần" sẽ tự động kích hoạt ChatGPT truy cập Spotify. Tìm kiếm "căn hộ trong một khu vực cụ thể" sẽ kích hoạt ứng dụng Zillow tạo bản đồ tương tác và hỗ trợ chi tiết truy vấn.

Đồng thời, các ứng dụng nhúng này cũng có khả năng đa phương thức, có thể tích hợp các yếu tố tương tác như bản đồ, danh sách, slide Canva, nội dung khóa học Coursera và video được cố định ở đầu trang web, có thể điều chỉnh trong cuộc trò chuyện. Hiện tại, tính năng này mở cửa cho tất cả người dùng đã đăng nhập ChatGPT, ngoại trừ Liên minh Châu Âu, bao gồm toàn bộ gói Free, Go, Plus và Pro. Các đối tác đầu tiên bao gồm Booking.com, Canva, Coursera, Expedia, Figma, Spotify, Zillow, v.v. và sẽ được kết nối với 11 thương hiệu quốc tế như AllTrails, DoorDash, Instacart và Uber trong tương lai.

Apps SDK (Bộ phát triển phần mềm ứng dụng): Nền tảng để xây dựng các ứng dụng thế hệ tiếp theo

Công cụ cốt lõi hỗ trợ việc triển khai các ứng dụng nhúng này và xây dựng hệ sinh thái ứng dụng đối thoại là Apps SDK do OpenAI phát hành. Nó dựa trên Giao thức Bối cảnh Mô hình ( MCP).) để đảm bảo kết nối an toàn và khả năng tương tác giữa các hệ thống AI và các nguồn dữ liệu bên ngoài; nó cũng mang lại cho các nhà phát triển sự tự do phát triển hoàn toàn, hỗ trợ logic ứng dụng tùy chỉnh và giao diện tương tác trong ChatGPT, đồng thời có thể tích hợp với mã nguồn phụ trợ và hệ thống máy khách của riêng họ để duy trì tính nhất quán của thương hiệu. Quan trọng hơn, OpenAI đã khẳng định rõ ràng rằng Apps SDK sẽ hoàn toàn là mã nguồn mở, với mục tiêu tạo ra một "hệ sinh thái ứng dụng AI đa nền tảng" vượt ra ngoài bản thân ChatGPT, giảm đáng kể rào cản gia nhập cho các nhà phát triển và đặt nền tảng cho việc mở rộng hệ sinh thái.

Về mặt thương mại hóa và quy hoạch hệ sinh thái, hệ thống này đã thiết lập một chuỗi hoàn chỉnh từ phát triển, phân phối đến thương mại hóa. Việc phân phối, tận dụng lợi thế của việc ứng dụng được nhúng trực tiếp vào các cuộc trò chuyện ChatGPT, cung cấp cho các nhà phát triển một kênh hiệu quả hơn, loại bỏ nhu cầu người dùng phải tải xuống các ứng dụng riêng lẻ. Về mặt thương mại, OpenAI dự định hỗ trợ thương mại hóa ứng dụng trong ChatGPT trong tương lai, tích hợp tính năng "Thanh toán tức thì ChatGPT" đã ra mắt và cho phép các ứng dụng AI tham gia trực tiếp vào các hoạt động kinh tế như dịch vụ trả phí và thanh toán giao dịch thông qua Giao thức Thương mại Đại lý. Về việc mở rộng hệ sinh thái, OpenAI cũng có kế hoạch mở chức năng ứng dụng cho người dùng phiên bản Enterprise và Education, đồng thời ra mắt "Danh mục Ứng dụng" chuyên dụng.

Tuy nhiên, hệ sinh thái ứng dụng đàm thoại hiện tại vẫn đang đối mặt với những thách thức quan trọng. Về quyền riêng tư, mặc dù OpenAI yêu cầu các nhà phát triển "chỉ thu thập dữ liệu tối thiểu cần thiết và minh bạch về quyền", nhưng họ vẫn chưa làm rõ phạm vi dữ liệu người dùng mà các nhà phát triển có thể truy cập, bao gồm việc liệu họ có thể truy cập toàn bộ lịch sử trò chuyện, tin nhắn gần đây hay chỉ các lời nhắc của ứng dụng. Về lựa chọn dịch vụ cạnh tranh, ChatGPT hiện thiếu một cơ chế rõ ràng để lựa chọn giữa các dịch vụ cạnh tranh như DoorDash và Instacart. Mặc dù OpenAI đã tuyên bố "ưu tiên trải nghiệm người dùng", nhưng họ vẫn chưa làm rõ liệu có bất kỳ mô hình kinh doanh nào, chẳng hạn như "ưu tiên trả phí" hay không. Những vấn đề này cần được làm rõ thêm để thúc đẩy sự phát triển lành mạnh của hệ sinh thái.

Ra mắt AgentKit: Chuyển đổi từ công cụ sang hệ sinh thái đại lý thông minh

Altman cũng đã phát hành một sản phẩm bom tấn, AgentKit. Bộ công cụ này bao quát toàn bộ vòng đời "xây dựng, triển khai, tối ưu hóa và kết nối" các tác nhân AI. Điểm hấp dẫn cốt lõi của nó là phá vỡ thế tiến thoái lưỡng nan của "sự phát triển rời rạc và rào cản gia nhập cao" trong quá trình phát triển các tác nhân cấp doanh nghiệp trước đây, đồng thời nâng cấp nó lên một mô hình thực hành kỹ thuật có hệ thống và hiệu quả, thúc đẩy các tác nhân AI từ "công cụ phụ trợ" trở thành phương tiện thực thi cốt lõi trong các quy trình doanh nghiệp. Đây cũng là một cột mốc quan trọng trong định hướng hệ sinh thái tác nhân thông minh của OpenAI.

Altman đã tuyên bố rõ ràng rằng AgentKit là "một bộ các khối xây dựng hoàn chỉnh trong Nền tảng OpenAI, bao gồm mọi thứ cần thiết để xây dựng, triển khai và tối ưu hóa quy trình làm việc của tác nhân thông minh. Điều này giảm đáng kể sự trì trệ trong quá trình phát triển và giúp các nhà phát triển nhanh chóng đưa tác nhân từ nguyên mẫu lên sản xuất." Động thái này không chỉ là một sáng kiến quan trọng của OpenAI nhằm tăng cường sự chấp nhận của các nhà phát triển mà còn tạo ra một lợi thế khác biệt trong bối cảnh nền tảng AI cạnh tranh. Trước sự bùng nổ của các công cụ tích hợp tác nhân thông minh, AgentKit, với trọng tâm cốt lõi là "phạm vi bao phủ toàn bộ quy trình và hoạt động ngưỡng thấp", giải quyết những điểm khó khăn thực tế của các doanh nghiệp khi xây dựng các tác nhân tự động có thể thực hiện các tác vụ phức tạp, thay vì chỉ đơn thuần phản hồi lời nhắc.

Các mô-đun chức năng cốt lõi của AgentKit hoạt động cùng nhau để tạo thành một hệ thống phát triển agent hoàn chỉnh. Đầu tiên là Agent Builder, được Altman ví như "Canva của phát triển agent". Thông qua một khung vẽ trực quan và giao diện kéo thả, các nhà phát triển có thể thiết kế logic, các bước và kết nối agent với các công cụ bên ngoài mà không cần mã hóa phức tạp. Hỗ trợ kiểm soát phiên bản đầy đủ, AgentKit giúp đơn giản hóa đáng kể việc điều phối các quy trình làm việc phức tạp của nhiều agent, vốn trước đây đòi hỏi nhiều tháng viết mã tùy chỉnh.

Agent Builder cũng bao gồm mô-đun Guardrails (vòng bảo mật) mã nguồn mở, dạng mô-đun, giúp ngăn chặn hiệu quả các hành vi độc hại của tác nhân, phát hiện các cuộc tấn công bẻ khóa và che giấu thông tin nhạy cảm, đảm bảo tính tuân thủ và độ tin cậy cho các triển khai cấp doanh nghiệp. Công ty công nghệ tài chính Ramp đã tận dụng công cụ này để chuyển đổi một quy trình mua sắm phức tạp thành một tác nhân có thể chạy được chỉ trong vài giờ, giảm chu kỳ lặp lại khoảng 70%, chứng minh giá trị hiệu quả của nó.

Thành phần thứ hai là Connector Registry, một cổng quản trị dữ liệu cấp doanh nghiệp cung cấp cho các tổ chức lớn một nền tảng quản lý thống nhất để kết nối các tác nhân với các hệ thống bên ngoài. Quản trị viên có thể xem và cấu hình tập trung tất cả các kết nối dữ liệu trong các tổ chức ChatGPT và API từ một bảng điều khiển duy nhất, bao gồm các trình kết nối được xây dựng sẵn như Dropbox, Google Drive, SharePoint và Microsoft Teams, cũng như các giao diện MCP của bên thứ ba. Bảng điều khiển Quản trị Toàn cầu cũng cho phép quản lý tập trung tên miền, đăng nhập một lần (SSO) và nhiều tổ chức API, đảm bảo quyền truy cập dữ liệu chi tiết và an toàn.

Thứ ba là ChatKit, tập trung vào việc giải quyết vấn đề "chặng đường cuối" của việc triển khai tác nhân. Bộ công cụ dễ sử dụng này cho phép các nhà phát triển nhanh chóng nhúng giao diện tác nhân dựa trên trò chuyện vào ứng dụng hoặc trang web của riêng họ. Nó hỗ trợ các chủ đề thương hiệu có thể tùy chỉnh, xử lý phản hồi trực tuyến và quản lý luồng, tích hợp liền mạch trải nghiệm tương tác của tác nhân với giao diện gốc của thương hiệu. Ví dụ: nền tảng thiết kế Canva đã tích hợp một tác nhân thân thiện với nhà phát triển thông qua ChatKit chỉ trong một giờ, cải thiện đáng kể hiệu quả tương tác của người dùng với tài liệu.

Để đảm bảo độ tin cậy ở cấp độ sản xuất, AgentKit cũng tích hợp phiên bản nâng cấp của Evals for Agents, một hệ thống đánh giá hiệu suất có hệ thống. Mô-đun này bao gồm Trace Grading, cho phép đánh giá toàn diện quy trình làm việc của tác nhân, xác định điểm yếu trong các chuỗi quyết định phức tạp. Nó cũng cung cấp các tập dữ liệu chuyên dụng để đánh giá từng thành phần và Automated Prompt Optimization, tự động tạo ra các lời nhắc được cải thiện dựa trên các chú thích và điểm số thủ công, hoàn thành chu trình đánh giá-tối ưu hóa. Hơn nữa, nó hỗ trợ chạy đánh giá trực tiếp trên các mô hình bên ngoài từ nền tảng OpenAI, phá vỡ các hạn chế của mô hình và thiết lập nó như một tiêu chuẩn phù hợp với ngành để đánh giá tác nhân.

Để chứng minh tính dễ sử dụng của AgentKit, kỹ sư Christina Huang của OpenAI đã trình diễn trực tiếp tại hội nghị: chỉ trong tám phút, cô đã hoàn thành quy trình làm việc AI hoàn chỉnh và xây dựng được hai tác nhân AI. Altman phát biểu: "AgentKit là công cụ mà chúng tôi mong muốn có khi cố gắng xây dựng các tác nhân đầu tiên." Một số đối tác đã đăng ký sử dụng công cụ này để mở rộng các kịch bản ứng dụng.

AgentKit cũng tích hợp các khả năng đào sâu mô hình: Reinforcement Fine-Tuning (RFT), hiện đã có sẵn đầy đủ cho mô hình o4-mini và bản beta riêng tư cho mô hình GPT-5, tận dụng các Lệnh Gọi Công Cụ Tùy Chỉnh để lựa chọn chính xác các công cụ huấn luyện mô hình. Các Trình Phân Loại Tùy Chỉnh sẽ liên kết việc tối ưu hóa mô hình với các mục tiêu kinh doanh, nâng cao hơn nữa khả năng suy luận và khả năng thích ứng của tác nhân với các tình huống cụ thể, đặt nền tảng kỹ thuật vững chắc cho sự phát triển lâu dài của hệ sinh thái tác nhân.

Bản phát hành chính thức của Codex: Biến AI thành "Nhà phát triển thứ hai" của Nhóm Kỹ thuật

Altman cũng công bố phiên bản đầy đủ của Codex, trợ lý lập trình thông minh, và ra mắt ba công cụ được tích hợp sâu vào quy trình làm việc của doanh nghiệp. Bản phát hành này không chỉ đánh dấu bước tiến chính thức của Codex từ một "công cụ hỗ trợ lập trình" thành "đối tác phát triển cộng tác" cho các nhóm kỹ thuật, mà còn tái cấu trúc hoàn toàn mô hình cộng tác hàng ngày của nhóm kỹ thuật, thúc đẩy sự cải thiện vượt bậc về hiệu quả R&D và biến AI thành "nhà phát triển thứ hai" thực sự đáng tin cậy trong nhóm.

Trọng tâm của bản phát hành này là phiên bản chính thức của Codex, được hỗ trợ bởi mô hình cốt lõi GPT-5-Codex, hiện đã có thể truy cập đầy đủ. Nhờ hiệu suất mạnh mẽ, mô hình này đã trở thành một trong những mô hình phát triển nhanh nhất của OpenAI, xử lý hơn 40 nghìn tỷ token chỉ trong ba tuần. Về mặt ứng dụng thực tế, hơn 90% kỹ sư OpenAI đã tích hợp Codex vào quy trình làm việc hàng ngày của họ. So với dữ liệu tháng 7, số lượng yêu cầu kéo được hợp nhất hàng tuần của nhóm đã tăng 70% và chức năng đánh giá tự động của Codex hiện bao gồm gần như tất cả các thay đổi mã. Codex có thể chủ động xác định các lỗ hổng cú pháp tiềm ẩn, rủi ro logic và các vấn đề quan trọng khác, giúp giảm đáng kể chi phí gỡ lỗi sau này và chứng minh giá trị của nó trong việc cải thiện hiệu quả kỹ thuật.

Tính năng tích hợp Slack mới ra mắt là một bước đột phá quan trọng trong quá trình chuyển đổi Codex từ một "công cụ" thành một "đồng nghiệp ảo". Các nhà phát triển không cần phải chuyển đổi nền tảng; chỉ cần gắn thẻ @Codex trong kênh Slack hoặc chuỗi hội thoại, Codex sẽ tự động trích xuất ngữ cảnh hội thoại, hiểu chính xác các yêu cầu phát triển, nhanh chóng thực hiện các tác vụ như tạo mã và xử lý sự cố, đồng thời trả về liên kết đến tác vụ mã để có thể tiếp tục chỉnh sửa hoặc hợp nhất trực tiếp trên Codex Cloud. Thiết kế này hoàn toàn phá vỡ rào cản giữa các công cụ AI và các tình huống cộng tác nhóm, biến Codex thành một "cộng tác viên nội bộ" trong các cuộc họp nhóm kỹ thuật và giao tiếp hàng ngày lần đầu tiên, thay vì một ứng dụng bên ngoài cần được mở riêng biệt, giúp thu hẹp hơn nữa khoảng cách giữa AI và quy trình làm việc nhóm.

Codex SDK cung cấp cho doanh nghiệp và nhà phát triển một cổng cốt lõi để nhúng các khả năng AI vào quy trình làm việc của họ. Bộ công cụ này tích hợp liền mạch các tác nhân hiệu suất cao, tương tự như Codex CLI, vào các hệ thống kỹ thuật doanh nghiệp, công cụ phát triển và ứng dụng kinh doanh. Nó cũng bao gồm các tính năng tích hợp như đầu ra có cấu trúc, quản lý ngữ cảnh tích hợp và phục hồi luồng phiên. Các nhà phát triển có thể gọi các tác nhân này chỉ với một vài dòng mã, giúp giảm đáng kể rào cản tích hợp.

Đồng thời, SDK được phát hành cùng với thành phần GitHub Action mới: Thông qua thành phần này, Codex có thể được kết nối trực tiếp với quy trình CI/CD để đạt được tự động hóa toàn bộ quy trình đánh giá mã, xây dựng tự động, xác minh triển khai và các liên kết khác, thực sự đưa khả năng AI vào mọi nút chính của vòng đời phát triển phần mềm.

Đối với người dùng thương mại, giáo dục và doanh nghiệp, OpenAI đã đồng thời ra mắt các công cụ quản lý và giám sát cấp doanh nghiệp để bảo vệ việc triển khai Codex trên quy mô lớn. Ở cấp độ kiểm soát môi trường, quản trị viên có thể trực tiếp chỉnh sửa hoặc xóa môi trường phát triển đám mây, dọn dẹp các phiên bản không sử dụng và xóa thông tin cấu hình nhạy cảm để tránh lãng phí tài nguyên và rủi ro rò rỉ dữ liệu. Về bảo mật và tuân thủ, một nền tảng cấu hình tập trung cho phép kiểm soát chi tiết quyền truy cập cho các CLI cục bộ và plugin IDE, đồng thời giám sát hành vi vận hành theo thời gian thực để đảm bảo tuân thủ các quy định bảo mật dữ liệu của doanh nghiệp.

Ngoài ra, Bảng điều khiển phân tích mới có thể theo dõi hoạt động sử dụng Codex trên nhiều nền tảng, bao gồm CLI, IDE và Web, đồng thời cung cấp các chỉ số định lượng như độ chính xác của việc xem xét mã và hiệu quả hoàn thành nhiệm vụ, giúp người quản lý đánh giá trực quan sự đóng góp thực tế của AI vào năng suất kỹ thuật và cung cấp hỗ trợ dữ liệu để phân bổ tài nguyên và tối ưu hóa quy trình.

Nâng cấp Ma trận Mô hình API: GPT-5 Pro, Sora 2 và Mô hình Giọng nói Nhẹ giúp Mở rộng Hệ sinh thái Nhà phát triển

OpenAI cũng công bố các bản cập nhật lớn cho hệ thống API của mình, bao gồm mô hình ngôn ngữ GPT-5 Pro, mô hình tạo video Sora 2 và mô hình giọng nói nhẹ "gpt-realtime mini". Những nâng cấp mô hình này, cùng với các công cụ xây dựng tác nhân đã phát hành trước đó và khả năng ứng dụng nhúng ChatGPT, tạo thành một sáng kiến cốt lõi của OpenAI nhằm thu hút các nhà phát triển và phát triển hệ sinh thái của mình, hướng đến mục tiêu cung cấp cho các nhà phát triển trong nhiều lĩnh vực khả năng AI linh hoạt và tiết kiệm chi phí hơn.

Open GPT-5 Pro API: Tập trung vào các tình huống "Độ chính xác cao và Lý luận sâu sắc"

Là mô hình ngôn ngữ cốt lõi cho bản cập nhật API này, GPT-5 Pro là phiên bản nâng cấp của GPT-5, được thiết kế để cung cấp phản hồi thông minh hơn và chính xác hơn, tập trung vào các kịch bản "có độ chính xác cao và suy luận sâu". Altman cho biết mô hình này sẽ đặc biệt hấp dẫn các nhà phát triển trong các ngành như tài chính, luật và chăm sóc sức khỏe, những ngành đòi hỏi độ chính xác cao nhất trong suy luận AI. Các ứng dụng như mô hình định giá rủi ro trong tài chính, phân tích chuyên sâu các điều khoản hợp đồng trong lĩnh vực pháp lý và phân tích dữ liệu ca bệnh trong các tình huống y tế sẽ được hưởng lợi từ khả năng suy luận mạnh mẽ của GPT-5 Pro, cải thiện hiệu quả phát triển và độ tin cậy của ứng dụng, lấp đầy khoảng trống về khả năng trước đây chỉ dành cho các mô hình đa năng trong các lĩnh vực chuyên môn cao.

Khả năng cốt lõi và hiệu suất

GPT-5 Pro có tốc độ suy luận chậm nhất vì nó sử dụng nhiều tài nguyên tính toán hơn cho tư duy sâu hơn, đảm bảo câu trả lời nhất quán và chất lượng cao hơn. Là mô hình suy luận tiên tiến nhất, nó mặc định và chỉ hỗ trợ chế độ "nỗ lực cao".

Vì được thiết kế để xử lý các tác vụ khó và phức tạp, một số yêu cầu có thể mất vài phút để hoàn tất. Để tránh tình trạng hết thời gian chờ, OpenAI khuyến nghị các nhà phát triển nên thử sử dụng chế độ nền.

Tham số, chế độ và hỗ trợ công cụ

GPT-5 Pro có cửa sổ ngữ cảnh lên đến 400.000 token và đầu ra tối đa là 272.000 token. Ngày hết hạn kiến thức là 30/9/2024.

Về mặt hỗ trợ phương thức, nó chấp nhận văn bản và hình ảnh làm đầu vào và xuất văn bản. Nó không hỗ trợ bất kỳ khả năng xử lý âm thanh hoặc video nào.

Mô hình này chỉ khả dụng thông qua API Responses (v1/responses). Nó hỗ trợ các lệnh gọi hàm và đầu ra có cấu trúc, nhưng không hỗ trợ phát trực tuyến, tinh chỉnh hoặc chắt lọc. Về mặt công cụ, nó hỗ trợ tìm kiếm trên web, tìm kiếm tệp, tạo hình ảnh và MCP, nhưng không hỗ trợ trình thông dịch mã hoặc công cụ sử dụng máy tính.

Giá cả và giới hạn tỷ lệ

GPT-5 Pro có giá dựa trên mức sử dụng mã thông báo: 15 đô la cho 1 triệu mã thông báo đầu vào và 120 đô la cho 1 triệu mã thông báo đầu ra.

Quyền truy cập API phải tuân theo giới hạn tốc độ. Các giới hạn này được xác định theo cấp độ sử dụng của bạn và tự động tăng lên khi mức sử dụng và chi tiêu cho API tăng lên. Ví dụ: cấp độ cao nhất, Cấp độ 5, có giới hạn là 10.000 yêu cầu mỗi phút và 30 triệu token.

Mô hình giọng nói rút gọn GPT-Realtime-Mini: Ưu điểm cốt lõi: Giảm chi phí và cải thiện hiệu quả

Để giải quyết vấn đề tương tác bằng giọng nói, một hình thức tương tác AI ngày càng quan trọng, OpenAI đã phát hành mô hình giọng nói "GPT-Realtime-Mini" gọn nhẹ trong API của mình. GPT-Realtime-Mini là phiên bản tiết kiệm chi phí của GPT Realtime, được thiết kế riêng cho hình thức tương tác AI ngày càng quan trọng này. Ưu điểm cốt lõi của nó nằm ở việc giảm chi phí và tăng hiệu quả: so với mô hình giọng nói tiên tiến trước đây của OpenAI, mô hình này giảm đáng kể 70% chi phí mà vẫn duy trì chất lượng giọng nói và khả năng biểu cảm tương tự.

Mô hình này cung cấp tốc độ vượt trội và hiệu suất được cải thiện. Nó phản hồi âm thanh và văn bản đầu vào theo thời gian thực thông qua các kết nối như WebRTC, WebSocket hoặc SIP. Nó hỗ trợ tương tác phát trực tuyến độ trễ thấp cho âm thanh và giọng nói, lý tưởng cho các tình huống nhạy cảm với phản hồi như dịch vụ khách hàng thời gian thực, trợ lý thông minh và giọng nói trong xe hơi. Điều này giúp giảm đáng kể rào cản gia nhập cho các nhà phát triển vừa và nhỏ để phát triển các ứng dụng AI dựa trên giọng nói chất lượng cao.

Hỗ trợ tham số và phương thức

Mô hình có cửa sổ ngữ cảnh là 32.000 mã thông báo và số lượng mã thông báo đầu ra tối đa là 4.096. Ngày hết hạn kiến thức của mô hình là ngày 1 tháng 10 năm 2023.

Về mặt hỗ trợ phương thức, nó hỗ trợ nhập và xuất văn bản và âm thanh, cũng như nhập hình ảnh, nhưng không hỗ trợ video.

Sử dụng API và các tính năng

Mô hình này có sẵn thông qua nhiều điểm cuối bao gồm hoàn tất trò chuyện, phản hồi và thời gian thực (v1/thời gian thực).

GPT-Realtime-Mini không hỗ trợ bất kỳ tính năng nâng cao nào như lệnh gọi hàm, đầu ra có cấu trúc, tinh chỉnh, chưng cất hoặc đầu ra dự đoán.

Giá cả và giới hạn tỷ lệ

Giá của các mô hình liên quan được tính dựa trên mức sử dụng token. Các tiêu chuẩn thanh toán cụ thể được thiết lập theo phân loại token văn bản và token âm thanh:

Tỷ lệ thanh toán cho mã thông báo văn bản là: 0,60 đô la cho 1 triệu mã thông báo đầu vào, 0,06 đô la cho 1 triệu mã thông báo đầu vào được lưu trong bộ nhớ đệm và 2,40 đô la cho 1 triệu mã thông báo đầu ra; tỷ lệ thanh toán cho mã thông báo âm thanh là: 10 đô la cho 1 triệu mã thông báo đầu vào, 0,30 đô la cho 1 triệu mã thông báo đầu vào được lưu trong bộ nhớ đệm và 20 đô la cho 1 triệu mã thông báo đầu ra.

Quyền truy cập API phải tuân theo giới hạn tốc độ. Các giới hạn này được xác định theo cấp độ sử dụng của người dùng và tự động tăng lên khi mức sử dụng và chi tiêu của người dùng cho API tăng lên. Ví dụ: cấp độ cao nhất, Cấp độ 5, có giới hạn là 20.000 yêu cầu mỗi phút (RPM) và 15 triệu token mỗi phút (TPM).

Mở quyền xem trước API Sora 2

Sora 2, mô hình tạo video được phát hành vào ngày 30 tháng 9, cũng đã mở bản xem trước API cho hệ sinh thái nhà phát triển. Các nhà phát triển có thể trực tiếp gọi mô hình cốt lõi điều khiển Sora 2 trong ứng dụng của riêng họ, tích hợp khả năng tạo video của nó vào các kịch bản sản phẩm.

API Sora cung cấp năm điểm cuối cốt lõi bao gồm toàn bộ quá trình tạo video:

Tạo video: Bắt đầu tác vụ kết xuất video mới bằng cách sử dụng từ gợi ý, tham chiếu tùy chọn hoặc ID phối lại.

Nhận trạng thái video: truy xuất trạng thái hiện tại của tác vụ kết xuất và theo dõi tiến trình theo thời gian thực;

Tải xuống video: Sau khi hoàn thành nhiệm vụ, hãy tải xuống tệp video định dạng MP4 cuối cùng;

Liệt kê video: Hỗ trợ phân trang để liệt kê các video lịch sử, thuận tiện cho việc quản lý trong bảng điều khiển hoặc thư viện tài nguyên;

Xóa video: Xóa video đã chỉ định khỏi bộ nhớ OpenAI, giải phóng tài nguyên.

Altman giới thiệu rằng Sora 2 đã đạt được những nâng cấp đa chiều dựa trên thế hệ trước: trình bày cảnh thực tế hơn và logic vật lý nhất quán hơn, đồng thời hỗ trợ các điều chỉnh sáng tạo sâu sắc từ điều khiển hướng ống kính đến tùy chỉnh phong cách hình ảnh, chẳng hạn như "mở rộng vật liệu từ góc nhìn của iPhone thành ống kính góc rộng điện ảnh"; quan trọng hơn, mô hình đạt được "sự kết hợp chính xác giữa âm thanh và hình ảnh", không chỉ có thể tạo ra giọng nói đồng bộ mà còn xây dựng các cảnh quan âm thanh môi trường phong phú và hiệu ứng âm thanh dựa trên cảnh, cho phép nâng cấp nội dung video từ "trình bày hình ảnh" thành "trải nghiệm nhập vai về âm thanh và hình ảnh được phối hợp".

Xét về giá trị ứng dụng, Sora 2 được định vị là "công cụ phát triển ý tưởng liên ngành". Trong quảng cáo, nó có thể tạo ra các ý tưởng sáng tạo trực quan dựa trên bầu không khí sản phẩm. Các nhà thiết kế tại các nhà sản xuất đồ chơi như Mattel đang sử dụng Sora 2 để biến các bản phác thảo thành các ý tưởng đồ chơi cụ thể. (OpenAI cũng đã tận dụng cơ hội này để công bố sự hợp tác với Mattel, thúc đẩy việc tích hợp AI tạo sinh vào các quy trình sản xuất truyền thống.) Khả năng chuyển đổi nhanh chóng các ý tưởng từ khái niệm sang triển khai này mang đến cho các nhà phát triển trong ngành thương mại điện tử, truyền thông và sản xuất một cách tiếp cận mới trong sản xuất nội dung và thiết kế sản phẩm.

Bản chất của bản nâng cấp ma trận mô hình API này là sự trao quyền sâu sắc của OpenAI cho hệ sinh thái nhà phát triển: bằng cách bao phủ các khả năng toàn phương thức của "lý luận ngôn ngữ, tương tác giọng nói và tạo video", kết hợp với thiết kế phân lớp mô hình "độ chính xác cao, nhẹ và tiết kiệm chi phí", nó đáp ứng các nhu cầu khác biệt của các nhà phát triển ở các quy mô khác nhau và trong các lĩnh vực khác nhau; và việc mở bản xem trước API của các mô hình bom tấn như Sora 2 là một cách tiếp cận "tải trước khả năng" để thu hút các nhà phát triển thực hiện các sắp xếp sớm, thúc đẩy việc triển khai các ứng dụng sáng tạo dựa trên công nghệ OpenAI và củng cố hơn nữa vị trí cốt lõi của nó trong hệ sinh thái nhà phát triển AI. #OpenAIDevDay