Duy Linh

Writer

Trí tuệ nhân tạo (AI) và máy học (ML) đang thay đổi cục diện an ninh mạng toàn cầu. Theo Khảo sát bảo mật đám mây lai từ Gigamon, khảo sát hơn 1.000 lãnh đạo CNTT và an ninh mạng trên thế giới, có tới 59% báo cáo rằng số cuộc tấn công sử dụng AI đang tăng nhanh, trong đó bao gồm các hình thức lừa đảo, giả mạo và mã độc tống tiền.

Những mối đe dọa này khai thác thuật toán ML không giám sát để xử lý dữ liệu lớn, nhận diện các mô hình, phát hiện lỗ hổng và điều chỉnh cách tấn công theo thời gian thực. Điều này giúp kẻ tấn công dễ dàng né tránh hệ thống bảo mật, sử dụng các kỹ thuật phối hợp như mạo danh, kỹ thuật xã hội, phần mềm độc hại tạo bởi AI và tấn công mạng đa giai đoạn.

Với khả năng thích ứng nhanh, các biện pháp phòng vệ truyền thống dựa trên nhận dạng chữ ký trở nên lỗi thời. Tin tặc có thể thay đổi dữ liệu, di chuyển trong hệ thống mạng mà không bị phát hiện, gây nguy cơ rò rỉ dữ liệu hoặc mất quyền kiểm soát tài sản trí tuệ.

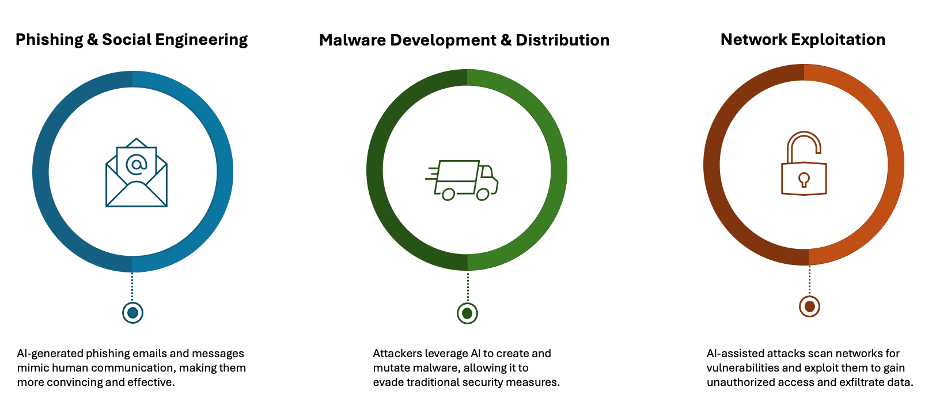

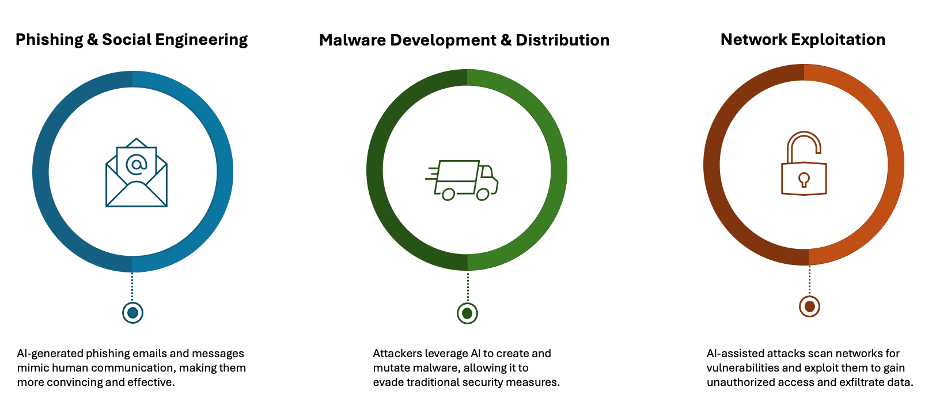

Các cuộc tấn công do AI hỗ trợ thường bao gồm giả mạo và kỹ thuật xã hội. Điển hình là vụ vi phạm tại Arup, nơi deepfake đã khiến một chuyên gia tài chính chuyển khoản 25 triệu USD (khoảng 635 tỷ VNĐ). Phần mềm độc hại cũng ngày càng tinh vi, như LummaC2 Stealer có thể thay đổi cấu trúc mã để qua mặt hệ thống phát hiện. Trong khi đó, botnet điều khiển bằng AI được dùng trong các chiến dịch DDoS đã gây ảnh hưởng đến hàng triệu dữ liệu, như trong sự cố TaskRabbit.

Các loại tấn công mạng được hỗ trợ bởi AI

Theo mô hình MITRE ATT&CK, AI hỗ trợ các bước như trinh sát (TA0043), truy cập ban đầu (TA0001), đánh cắp dữ liệu (TA0010), tự động hóa hành vi như T1020 (trộm dữ liệu tự động) và T1041 (lợi dụng kênh điều khiển C2).

Trong thực tế, AI có thể thực hiện các hành vi trinh sát, xác định điểm yếu, mô phỏng hành vi hợp pháp và trộm dữ liệu mà không để lại dấu vết. Ví dụ, trong vụ xâm nhập vào HealthEquity, AI đã thu thập hồ sơ nhân sự, giả mạo email và vượt qua hệ thống phát hiện bất thường, dẫn đến rò rỉ dữ liệu nghiêm trọng.

Ngoài ra, mối đe dọa còn đến từ nội bộ. Như vụ Samsung Securities năm 2023 cho thấy, AI có thể vô tình tạo điều kiện rò rỉ mã nhạy cảm, hoặc bị lợi dụng để trộm thông tin trí tuệ ở quy mô lớn thông qua kỹ thuật đảo ngược.

Để đối phó với mối đe dọa này, các tổ chức cần chiến lược phòng thủ nhiều lớp, bao gồm: giám sát lưu lượng mã hóa bằng dấu vân tay JA3/JA3S, áp dụng các công cụ NDR để kết nối dữ liệu từ nhiều nguồn (điểm cuối, mạng, đám mây), dùng DLP tích hợp ML thích ứng để phát hiện các hành vi trốn tránh và triển khai phân đoạn vi mô để giới hạn quyền truy cập.

Ngoài ra, các kỹ thuật như thiết lập hành vi cơ bản bằng ML để nhận diện bất thường trong DNS, HTTP/2 (T1048, T1572), theo dõi API đám mây để phát hiện sai sót trong kho lưu trữ (T1530), tự động hóa phản ứng khi phát hiện hành vi vượt giới hạn băng thông (T1052) cũng được khuyến nghị.

Báo cáo Deep Observability Pipeline từ Gigamon cho thấy giải pháp này giúp loại bỏ "điểm mù" trong giám sát, buộc kẻ tấn công phải "lộ mặt", từ đó tạo cơ hội phản ứng nhanh cho bên phòng thủ.

Để giảm rủi ro về tài chính, danh tiếng và tuân thủ, các tổ chức cần tăng cường giám sát thời gian thực, kết hợp phòng thủ AI và nâng cao nhận thức về an ninh mạng trước làn sóng tấn công do AI dẫn dắt đang ngày càng mạnh mẽ.

Đọc chi tiết tại đây: https://gbhackers.com/ai-powered-cyber-attacks-utilize-ml-algorithms/

Những mối đe dọa này khai thác thuật toán ML không giám sát để xử lý dữ liệu lớn, nhận diện các mô hình, phát hiện lỗ hổng và điều chỉnh cách tấn công theo thời gian thực. Điều này giúp kẻ tấn công dễ dàng né tránh hệ thống bảo mật, sử dụng các kỹ thuật phối hợp như mạo danh, kỹ thuật xã hội, phần mềm độc hại tạo bởi AI và tấn công mạng đa giai đoạn.

Cách thức AI đang thay đổi bản chất các cuộc tấn công mạng

Quá trình tấn công thường bắt đầu từ việc AI tự động thu thập dữ liệu từ mạng xã hội hoặc web đen, sau đó xác định điểm yếu bảo mật bằng thuật toán, lập kế hoạch tấn công chiến lược và liên tục thích nghi nhằm tránh bị phát hiện.Với khả năng thích ứng nhanh, các biện pháp phòng vệ truyền thống dựa trên nhận dạng chữ ký trở nên lỗi thời. Tin tặc có thể thay đổi dữ liệu, di chuyển trong hệ thống mạng mà không bị phát hiện, gây nguy cơ rò rỉ dữ liệu hoặc mất quyền kiểm soát tài sản trí tuệ.

Các cuộc tấn công do AI hỗ trợ thường bao gồm giả mạo và kỹ thuật xã hội. Điển hình là vụ vi phạm tại Arup, nơi deepfake đã khiến một chuyên gia tài chính chuyển khoản 25 triệu USD (khoảng 635 tỷ VNĐ). Phần mềm độc hại cũng ngày càng tinh vi, như LummaC2 Stealer có thể thay đổi cấu trúc mã để qua mặt hệ thống phát hiện. Trong khi đó, botnet điều khiển bằng AI được dùng trong các chiến dịch DDoS đã gây ảnh hưởng đến hàng triệu dữ liệu, như trong sự cố TaskRabbit.

Các loại tấn công mạng được hỗ trợ bởi AI

Theo mô hình MITRE ATT&CK, AI hỗ trợ các bước như trinh sát (TA0043), truy cập ban đầu (TA0001), đánh cắp dữ liệu (TA0010), tự động hóa hành vi như T1020 (trộm dữ liệu tự động) và T1041 (lợi dụng kênh điều khiển C2).

Trong thực tế, AI có thể thực hiện các hành vi trinh sát, xác định điểm yếu, mô phỏng hành vi hợp pháp và trộm dữ liệu mà không để lại dấu vết. Ví dụ, trong vụ xâm nhập vào HealthEquity, AI đã thu thập hồ sơ nhân sự, giả mạo email và vượt qua hệ thống phát hiện bất thường, dẫn đến rò rỉ dữ liệu nghiêm trọng.

Ngoài ra, mối đe dọa còn đến từ nội bộ. Như vụ Samsung Securities năm 2023 cho thấy, AI có thể vô tình tạo điều kiện rò rỉ mã nhạy cảm, hoặc bị lợi dụng để trộm thông tin trí tuệ ở quy mô lớn thông qua kỹ thuật đảo ngược.

Để đối phó với mối đe dọa này, các tổ chức cần chiến lược phòng thủ nhiều lớp, bao gồm: giám sát lưu lượng mã hóa bằng dấu vân tay JA3/JA3S, áp dụng các công cụ NDR để kết nối dữ liệu từ nhiều nguồn (điểm cuối, mạng, đám mây), dùng DLP tích hợp ML thích ứng để phát hiện các hành vi trốn tránh và triển khai phân đoạn vi mô để giới hạn quyền truy cập.

Ngoài ra, các kỹ thuật như thiết lập hành vi cơ bản bằng ML để nhận diện bất thường trong DNS, HTTP/2 (T1048, T1572), theo dõi API đám mây để phát hiện sai sót trong kho lưu trữ (T1530), tự động hóa phản ứng khi phát hiện hành vi vượt giới hạn băng thông (T1052) cũng được khuyến nghị.

Báo cáo Deep Observability Pipeline từ Gigamon cho thấy giải pháp này giúp loại bỏ "điểm mù" trong giám sát, buộc kẻ tấn công phải "lộ mặt", từ đó tạo cơ hội phản ứng nhanh cho bên phòng thủ.

Để giảm rủi ro về tài chính, danh tiếng và tuân thủ, các tổ chức cần tăng cường giám sát thời gian thực, kết hợp phòng thủ AI và nâng cao nhận thức về an ninh mạng trước làn sóng tấn công do AI dẫn dắt đang ngày càng mạnh mẽ.

Đọc chi tiết tại đây: https://gbhackers.com/ai-powered-cyber-attacks-utilize-ml-algorithms/

Được phối hợp thực hiện bởi các chuyên gia của Bkav,

cộng đồng An ninh mạng Việt Nam WhiteHat

và cộng đồng Khoa học công nghệ VnReview