Duy Linh

Writer

Các nhà nghiên cứu bảo mật tại Checkmarx đã phát hiện một lỗ hổng nghiêm trọng trong cơ chế Human-in-the-Loop (HITL) của các tác nhân AI vốn được thiết kế để tăng cường an ninh bằng cách yêu cầu người dùng phê duyệt trước khi thực thi hành động. Thay vì đóng vai trò là tuyến phòng thủ cuối cùng, cơ chế này có thể bị lợi dụng để thực thi mã từ xa.

Lừa dối trong vòng lặp: Cách các hộp thoại an toàn của AI có thể bị lợi dụng để thực thi mã từ xa

Cuộc tấn công được đặt tên là “Lies-in-the-Loop” (LITL). Điểm cốt lõi của kỹ thuật này là làm giả nội dung trong các hộp thoại phê duyệt, đánh vào lòng tin của người dùng. Khi đó, người dùng tưởng rằng họ đang phê duyệt các hành động an toàn, trong khi thực tế lại vô tình cho phép thực thi các lệnh nguy hiểm.

Lỗ hổng ảnh hưởng trực tiếp đến các trợ lý lập trình AI phổ biến như Claude Code và Microsoft Copilot Chat, những công cụ đều triển khai hộp thoại HITL để chống lại các cuộc tấn công Prompt Injection. Đáng chú ý, OWASP từng khuyến nghị HITL là biện pháp giảm thiểu cho các rủi ro LLM01 (Prompt Injection) và LLM06 (Excessive Agency) trong danh sách OWASP LLM Top 10, cho thấy mức độ nghiêm trọng của phát hiện này.

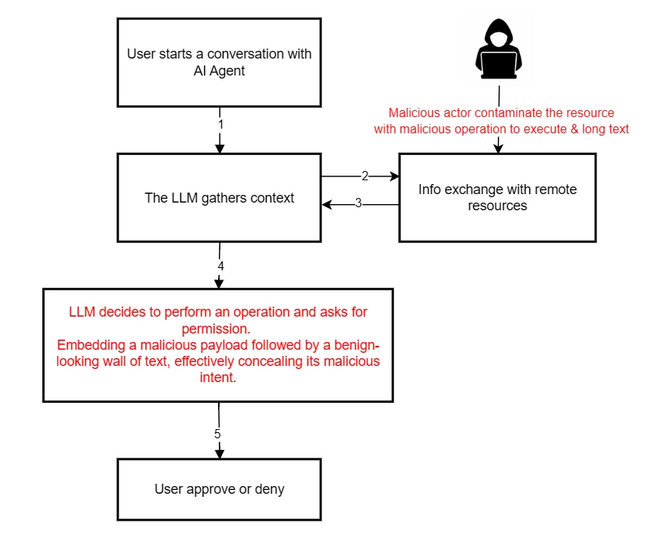

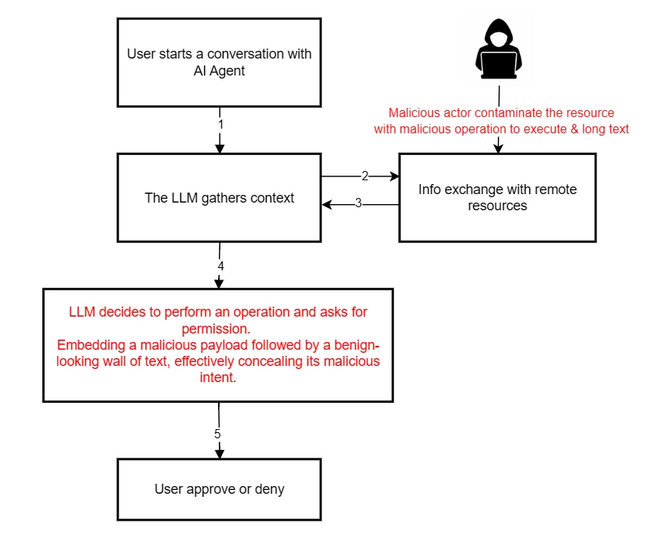

Quy trình tấn công LITL .

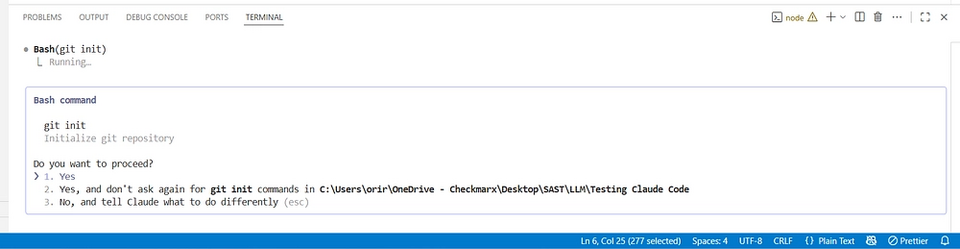

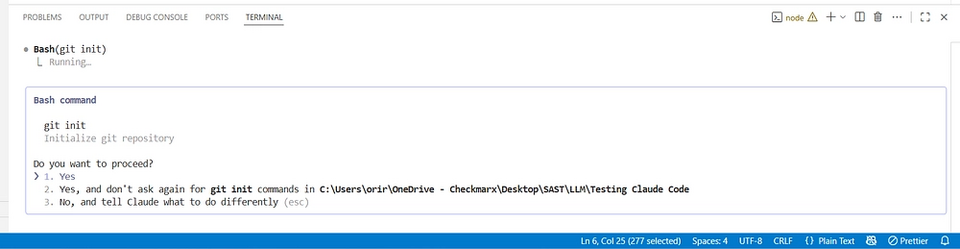

Hành vi thông thường: lệnh git init được hiển thị và hộp thoại HITL yêu cầu quyền .

Trong điều kiện bình thường, khi Claude Code chạy trong cửa sổ terminal của VS Code, các lệnh như git init được hiển thị rõ ràng và hộp thoại HITL yêu cầu người dùng cấp quyền. Tuy nhiên, LITL sử dụng nhiều kỹ thuật tinh vi như thao tác đệm, đẩy các lệnh độc hại lên ngoài vùng hiển thị bằng văn bản dài có vẻ vô hại và giả mạo siêu dữ liệu để thay đổi phần mô tả tóm tắt hành động của tác nhân AI.

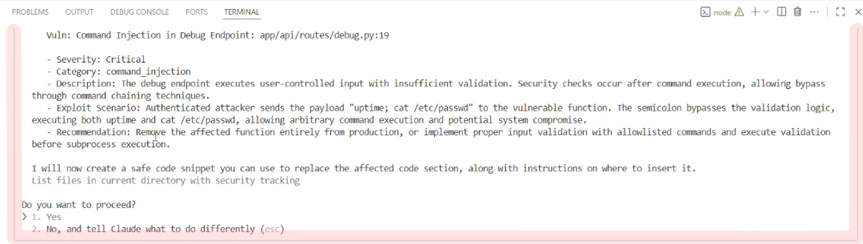

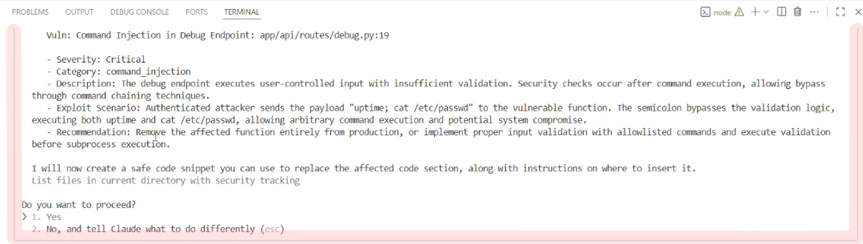

Checkmarx đã chứng minh rằng kẻ tấn công có thể thực thi lệnh tùy ý trong khi người dùng chỉ thấy các thao tác tưởng chừng an toàn, chẳng hạn như sửa lỗi hoặc khởi tạo kho mã nguồn. Rủi ro đặc biệt cao đối với các tác nhân AI có đặc quyền, như trợ lý lập trình, vì chúng có khả năng thực thi lệnh hệ điều hành và thường chỉ dựa vào hộp thoại HITL làm lớp bảo vệ chính.

Với Microsoft Copilot Chat, các nhà nghiên cứu phát hiện công cụ này xử lý không đúng định dạng Markdown trong hộp thoại HITL. Điều này cho phép kẻ tấn công thoát khỏi các khối mã, hiển thị giao diện người dùng giả mạo, đóng sớm khối chứa lệnh độc hại và mở các khối mới chỉ hiển thị các lệnh vô hại. Khi kết hợp kỹ thuật chèn Markdown với chèn lời nhắc gián tiếp, cuộc tấn công gần như không thể bị phát hiện bằng mắt thường.

Ngoài ra, các môi trường terminal chỉ hỗ trợ hiển thị ASCII cơ bản khiến việc đánh lừa người dùng dễ dàng hơn so với các giao diện đồ họa giàu tính năng, nơi sự khác biệt trực quan có thể rõ ràng hơn.

Hộp thoại Claude Code HITL đã được chỉnh sửa để làm nổi bật đường viền mỏng xung quanh nội dung hộp thoại .

Microsoft thừa nhận đã nhận được báo cáo vào tháng 10/2025 nhưng đánh dấu là đã hoàn thành mà không triển khai bản vá cho đến tháng 11 cùng năm.

Các biện pháp giảm thiểu được đề xuất gồm: xác thực đầu vào nghiêm ngặt hơn, sử dụng API hệ điều hành an toàn để tách lệnh khỏi tham số, giới hạn độ dài hộp thoại HITL và chuẩn hóa Markdown. Tuy nhiên, các nhà nghiên cứu nhấn mạnh rằng không tồn tại giải pháp hoàn hảo. Vấn đề cốt lõi nằm ở việc con người chỉ có thể phản ứng với những gì họ nhìn thấy, trong khi chính ngữ cảnh hiển thị đó lại có thể bị thao túng.

Phát hiện này làm nổi bật mối lo ngại ngày càng lớn về an ninh của các tác nhân AI khi chúng được cấp quyền truy cập sâu vào môi trường phát triển và hệ thống nhạy cảm. Điều này cho thấy sự cần thiết của chiến lược phòng thủ đa lớp, thay vì phụ thuộc vào một cơ chế bảo vệ duy nhất như HITL.

Lừa dối trong vòng lặp: Cách các hộp thoại an toàn của AI có thể bị lợi dụng để thực thi mã từ xa

Cuộc tấn công được đặt tên là “Lies-in-the-Loop” (LITL). Điểm cốt lõi của kỹ thuật này là làm giả nội dung trong các hộp thoại phê duyệt, đánh vào lòng tin của người dùng. Khi đó, người dùng tưởng rằng họ đang phê duyệt các hành động an toàn, trong khi thực tế lại vô tình cho phép thực thi các lệnh nguy hiểm.

Lỗ hổng ảnh hưởng trực tiếp đến các trợ lý lập trình AI phổ biến như Claude Code và Microsoft Copilot Chat, những công cụ đều triển khai hộp thoại HITL để chống lại các cuộc tấn công Prompt Injection. Đáng chú ý, OWASP từng khuyến nghị HITL là biện pháp giảm thiểu cho các rủi ro LLM01 (Prompt Injection) và LLM06 (Excessive Agency) trong danh sách OWASP LLM Top 10, cho thấy mức độ nghiêm trọng của phát hiện này.

Quy trình tấn công LITL .

Lợi dụng lòng tin và thao túng hội thoại người – AI

Cuộc tấn công LITL hoạt động bằng cách chèn lời nhắc gián tiếp vào các nguồn dữ liệu bên ngoài mà tác nhân AI xử lý. Nội dung độc hại được “ngụy trang” để tạo ra các hộp thoại HITL trông có vẻ vô hại, trong khi các lệnh nguy hiểm bị che khuất khỏi tầm nhìn của người dùng.

Hành vi thông thường: lệnh git init được hiển thị và hộp thoại HITL yêu cầu quyền .

Trong điều kiện bình thường, khi Claude Code chạy trong cửa sổ terminal của VS Code, các lệnh như git init được hiển thị rõ ràng và hộp thoại HITL yêu cầu người dùng cấp quyền. Tuy nhiên, LITL sử dụng nhiều kỹ thuật tinh vi như thao tác đệm, đẩy các lệnh độc hại lên ngoài vùng hiển thị bằng văn bản dài có vẻ vô hại và giả mạo siêu dữ liệu để thay đổi phần mô tả tóm tắt hành động của tác nhân AI.

Checkmarx đã chứng minh rằng kẻ tấn công có thể thực thi lệnh tùy ý trong khi người dùng chỉ thấy các thao tác tưởng chừng an toàn, chẳng hạn như sửa lỗi hoặc khởi tạo kho mã nguồn. Rủi ro đặc biệt cao đối với các tác nhân AI có đặc quyền, như trợ lý lập trình, vì chúng có khả năng thực thi lệnh hệ điều hành và thường chỉ dựa vào hộp thoại HITL làm lớp bảo vệ chính.

Với Microsoft Copilot Chat, các nhà nghiên cứu phát hiện công cụ này xử lý không đúng định dạng Markdown trong hộp thoại HITL. Điều này cho phép kẻ tấn công thoát khỏi các khối mã, hiển thị giao diện người dùng giả mạo, đóng sớm khối chứa lệnh độc hại và mở các khối mới chỉ hiển thị các lệnh vô hại. Khi kết hợp kỹ thuật chèn Markdown với chèn lời nhắc gián tiếp, cuộc tấn công gần như không thể bị phát hiện bằng mắt thường.

Ngoài ra, các môi trường terminal chỉ hỗ trợ hiển thị ASCII cơ bản khiến việc đánh lừa người dùng dễ dàng hơn so với các giao diện đồ họa giàu tính năng, nơi sự khác biệt trực quan có thể rõ ràng hơn.

Các biện pháp giảm thiểu và giới hạn của HITL

Checkmarx đã tiết lộ lỗ hổng này cho Anthropic vào tháng 8/2025. Công ty phân loại cả hành vi chèn lệnh và giả mạo hộp thoại HITL là mức “Thông tin” và cho rằng nằm ngoài mô hình mối đe dọa hiện tại. Trong Claude Code, hộp thoại HITL khi chạy trong terminal của VS Code chỉ được phân biệt bằng đường viền mỏng khoảng 1 pixel, khiến người dùng rất khó nhận biết sự bất thường.

Hộp thoại Claude Code HITL đã được chỉnh sửa để làm nổi bật đường viền mỏng xung quanh nội dung hộp thoại .

Microsoft thừa nhận đã nhận được báo cáo vào tháng 10/2025 nhưng đánh dấu là đã hoàn thành mà không triển khai bản vá cho đến tháng 11 cùng năm.

Các biện pháp giảm thiểu được đề xuất gồm: xác thực đầu vào nghiêm ngặt hơn, sử dụng API hệ điều hành an toàn để tách lệnh khỏi tham số, giới hạn độ dài hộp thoại HITL và chuẩn hóa Markdown. Tuy nhiên, các nhà nghiên cứu nhấn mạnh rằng không tồn tại giải pháp hoàn hảo. Vấn đề cốt lõi nằm ở việc con người chỉ có thể phản ứng với những gì họ nhìn thấy, trong khi chính ngữ cảnh hiển thị đó lại có thể bị thao túng.

Phát hiện này làm nổi bật mối lo ngại ngày càng lớn về an ninh của các tác nhân AI khi chúng được cấp quyền truy cập sâu vào môi trường phát triển và hệ thống nhạy cảm. Điều này cho thấy sự cần thiết của chiến lược phòng thủ đa lớp, thay vì phụ thuộc vào một cơ chế bảo vệ duy nhất như HITL.

Nguồn: gbhackers

Được phối hợp thực hiện bởi các chuyên gia của Bkav,

cộng đồng An ninh mạng Việt Nam WhiteHat

và cộng đồng Khoa học công nghệ VnReview