CyberThao

Writer

Một kỹ thuật tấn công mới mang tên TokenBreak vừa được các chuyên gia an ninh mạng phát hiện và cảnh báo. Kỹ thuật này có thể vượt qua các cơ chế kiểm duyệt nội dung và hệ thống bảo vệ an toàn của các mô hình ngôn ngữ lớn (LLM) chỉ bằng cách thay đổi một ký tự trong văn bản.

Theo nghiên cứu được chia sẻ trên The Hacker News bởi ba nhà nghiên cứu Kieran Evans, Kasimir Schulz và Kenneth Yeung, TokenBreak khai thác điểm yếu trong quy trình mã hóa văn bản (tokenization) – bước đầu tiên khi mô hình ngôn ngữ chia nhỏ văn bản đầu vào thành các token. Token là những chuỗi ký tự nhỏ được chuyển đổi thành số để mô hình hiểu và dự đoán từ tiếp theo.

Các mô hình ngôn ngữ hiểu được các mối quan hệ thống kê giữa các token này và dựa vào đó để tạo ra phản hồi. Khi mô hình trả lời, các token được chuyển ngược lại thành văn bản có thể đọc được. Tuy nhiên, chính bước tokenization này lại trở thành điểm yếu để kẻ tấn công lợi dụng.

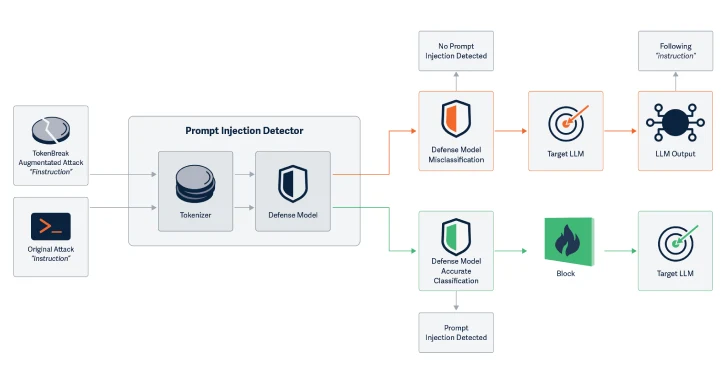

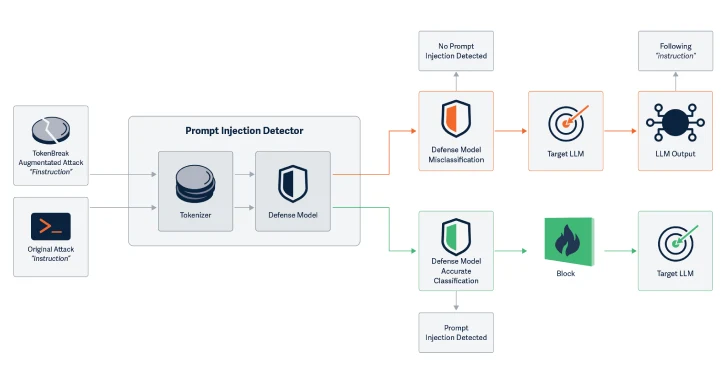

TokenBreak tấn công vào chính bước mã hóa đó bằng cách thay đổi cấu trúc từ mà không làm mất ý nghĩa. Ví dụ, thay vì viết "instructions", kẻ tấn công viết thành "finstructions"; thay "announcement" thành "aannouncement", hay thêm một chữ cái thành "hidiot" thay vì "idiot". Những thay đổi tưởng chừng nhỏ này lại khiến các trình phân tích phân tách văn bản khác đi, từ đó làm mô hình phân loại nội dung không phát hiện ra nội dung bị cấm hoặc nguy hiểm.

Điểm nguy hiểm là, dù thay đổi, văn bản vẫn hoàn toàn dễ hiểu với cả người đọc và mô hình ngôn ngữ, khiến hệ thống kiểm duyệt không nghi ngờ và phản hồi như thể đang xử lý văn bản hợp lệ. Điều này tạo điều kiện để nội dung độc hại hoặc bị kiểm duyệt có thể “lách luật” và được xử lý như nội dung an toàn.

Theo nhóm nghiên cứu, kỹ thuật TokenBreak đặc biệt hiệu quả với các mô hình sử dụng chiến lược mã hóa BPE (Byte Pair Encoding) và WordPiece, nhưng không hiệu quả với các mô hình dùng Unigram, do cách chia token của chúng ít bị ảnh hưởng bởi các thay đổi nhỏ trong từ ngữ.

Để hạn chế rủi ro từ TokenBreak, các chuyên gia khuyến nghị nên sử dụng các bộ tokenizer kiểu Unigram nếu có thể. Ngoài ra, nên huấn luyện mô hình bằng các ví dụ đã bị thao túng để tăng khả năng nhận diện, kiểm tra lại sự tương thích giữa chiến lược token hóa và logic phân loại, đồng thời ghi nhận các phân loại sai để phân tích, tìm mẫu tấn công tiềm ẩn.

Phát hiện này chỉ được công bố không lâu sau khi HiddenLayer cũng tiết lộ một kỹ thuật khai thác khác – thông qua Giao thức bối cảnh mô hình (Model Context Protocol – MCP) – có thể đánh cắp dữ liệu nhạy cảm, bao gồm cả lời nhắc hệ thống, bằng cách chèn các tên tham số cụ thể vào đoạn mã.

Song song, nhóm Straiker AI (STAR) cũng đưa ra một kỹ thuật có tên Yearbook Attack, sử dụng các từ viết tắt đảo ngược hoặc từ khóa “ngụy trang” để đánh lừa chatbot AI tạo ra nội dung bị cấm như chửi bậy, kích động bạo lực, hoặc nội dung khiêu ***. Theo nhà nghiên cứu Aarushi Banerjee, những cụm từ như “Tình bạn, sự đoàn kết, lòng tốt, sự quan tâm” thoạt nghe vô hại, nhưng lại có thể được mô hình hiểu theo hướng khác khi hoàn thành câu, từ đó "vượt mặt" các bộ lọc và sinh ra nội dung nguy hiểm.

TokenBreak và các kỹ thuật tương tự không cố gắng đối đầu trực tiếp với bộ lọc, mà ẩn mình bên dưới, khai thác chính những gì mô hình được thiết kế để ưu tiên: sự nhất quán về ngữ cảnh và khả năng dự đoán theo trình tự. Điều này làm tăng tính hiệu quả của các cuộc tấn công, nhất là trong môi trường sản xuất, nơi các mô hình LLM được triển khai rộng rãi nhưng chưa được đào tạo đầy đủ để nhận diện các thủ thuật lách luật tinh vi như vậy.

Đọc chi tiết tại đây: https://thehackernews.com/2025/06/new-tokenbreak-attack-bypasses-ai.html

Theo nghiên cứu được chia sẻ trên The Hacker News bởi ba nhà nghiên cứu Kieran Evans, Kasimir Schulz và Kenneth Yeung, TokenBreak khai thác điểm yếu trong quy trình mã hóa văn bản (tokenization) – bước đầu tiên khi mô hình ngôn ngữ chia nhỏ văn bản đầu vào thành các token. Token là những chuỗi ký tự nhỏ được chuyển đổi thành số để mô hình hiểu và dự đoán từ tiếp theo.

Các mô hình ngôn ngữ hiểu được các mối quan hệ thống kê giữa các token này và dựa vào đó để tạo ra phản hồi. Khi mô hình trả lời, các token được chuyển ngược lại thành văn bản có thể đọc được. Tuy nhiên, chính bước tokenization này lại trở thành điểm yếu để kẻ tấn công lợi dụng.

TokenBreak tấn công vào chính bước mã hóa đó bằng cách thay đổi cấu trúc từ mà không làm mất ý nghĩa. Ví dụ, thay vì viết "instructions", kẻ tấn công viết thành "finstructions"; thay "announcement" thành "aannouncement", hay thêm một chữ cái thành "hidiot" thay vì "idiot". Những thay đổi tưởng chừng nhỏ này lại khiến các trình phân tích phân tách văn bản khác đi, từ đó làm mô hình phân loại nội dung không phát hiện ra nội dung bị cấm hoặc nguy hiểm.

Điểm nguy hiểm là, dù thay đổi, văn bản vẫn hoàn toàn dễ hiểu với cả người đọc và mô hình ngôn ngữ, khiến hệ thống kiểm duyệt không nghi ngờ và phản hồi như thể đang xử lý văn bản hợp lệ. Điều này tạo điều kiện để nội dung độc hại hoặc bị kiểm duyệt có thể “lách luật” và được xử lý như nội dung an toàn.

Theo nhóm nghiên cứu, kỹ thuật TokenBreak đặc biệt hiệu quả với các mô hình sử dụng chiến lược mã hóa BPE (Byte Pair Encoding) và WordPiece, nhưng không hiệu quả với các mô hình dùng Unigram, do cách chia token của chúng ít bị ảnh hưởng bởi các thay đổi nhỏ trong từ ngữ.

Để hạn chế rủi ro từ TokenBreak, các chuyên gia khuyến nghị nên sử dụng các bộ tokenizer kiểu Unigram nếu có thể. Ngoài ra, nên huấn luyện mô hình bằng các ví dụ đã bị thao túng để tăng khả năng nhận diện, kiểm tra lại sự tương thích giữa chiến lược token hóa và logic phân loại, đồng thời ghi nhận các phân loại sai để phân tích, tìm mẫu tấn công tiềm ẩn.

Phát hiện này chỉ được công bố không lâu sau khi HiddenLayer cũng tiết lộ một kỹ thuật khai thác khác – thông qua Giao thức bối cảnh mô hình (Model Context Protocol – MCP) – có thể đánh cắp dữ liệu nhạy cảm, bao gồm cả lời nhắc hệ thống, bằng cách chèn các tên tham số cụ thể vào đoạn mã.

Song song, nhóm Straiker AI (STAR) cũng đưa ra một kỹ thuật có tên Yearbook Attack, sử dụng các từ viết tắt đảo ngược hoặc từ khóa “ngụy trang” để đánh lừa chatbot AI tạo ra nội dung bị cấm như chửi bậy, kích động bạo lực, hoặc nội dung khiêu ***. Theo nhà nghiên cứu Aarushi Banerjee, những cụm từ như “Tình bạn, sự đoàn kết, lòng tốt, sự quan tâm” thoạt nghe vô hại, nhưng lại có thể được mô hình hiểu theo hướng khác khi hoàn thành câu, từ đó "vượt mặt" các bộ lọc và sinh ra nội dung nguy hiểm.

TokenBreak và các kỹ thuật tương tự không cố gắng đối đầu trực tiếp với bộ lọc, mà ẩn mình bên dưới, khai thác chính những gì mô hình được thiết kế để ưu tiên: sự nhất quán về ngữ cảnh và khả năng dự đoán theo trình tự. Điều này làm tăng tính hiệu quả của các cuộc tấn công, nhất là trong môi trường sản xuất, nơi các mô hình LLM được triển khai rộng rãi nhưng chưa được đào tạo đầy đủ để nhận diện các thủ thuật lách luật tinh vi như vậy.

Đọc chi tiết tại đây: https://thehackernews.com/2025/06/new-tokenbreak-attack-bypasses-ai.html