Vào cuối tháng 10 năm 2025, Meta AI đã công bố cắt giảm 600 việc làm, bao gồm cả giám đốc nghiên cứu của một bộ phận cốt lõi. Cùng lúc đó, các giám đốc điều hành phụ trách mảng AI lần lượt rời đi và bị gạt ra ngoài lề. Ngay cả Yann LeCun, người đoạt giải Turing, cũng bị coi là gặp rắc rối.

Một mặt, Zuckerberg đang săn đón nhân tài AI với mức lương hàng năm lên tới hàng trăm triệu đô la, nhưng đồng thời lại sa thải nhân viên một cách quyết liệt. Nguyên nhân đằng sau hành vi mâu thuẫn này là gì?

Vì vậy, chúng tôi đã phỏng vấn Tian Yuandong, cựu Giám đốc nghiên cứu FAIR và Nhà khoa học AI tại Meta; Gavin Wang, cựu nhân viên của Meta đã tham gia khóa đào tạo sau Llama 3; một chuyên gia nhân sự cấp cao từ Thung lũng Silicon; và một số cá nhân ẩn danh, nhằm mục đích tái hiện lại chính xác những gì đã xảy ra với lộ trình mã nguồn mở Llama của Meta:

Tại sao Llama 3 lại gây ấn tượng mạnh mẽ, trong khi Llama 4, ra mắt chỉ một năm sau đó, lại gây thất vọng đến vậy? Chuyện gì đã xảy ra trong khoảng thời gian đó? Phải chăng phương pháp nguồn mở của Meta đã thất bại ngay từ đầu? Trong bối cảnh cạnh tranh khốc liệt hiện nay giữa các mô hình AI lớn, liệu một phòng nghiên cứu AI lý tưởng có còn tồn tại?

Sự ra đời của FAIR và GenAI; Chiến lược AI và quá trình phát triển kiến trúc trong mười năm của Meta.

Trước tiên, chúng ta hãy xem xét cấu trúc công ty tổng thể của Meta liên quan đến chiến lược AI của công ty.

Cuối năm 2013, Zuckerberg bắt đầu xây dựng đội ngũ AI của Meta. Vào thời điểm đó, Google đã mua lại đội ngũ DNN của Geoffrey Hinton và tuyển dụng Hinton, trong khi Meta đưa Yann LeCun vào để giám sát việc phát triển AI. Nhờ đó, hai trong số ba nhân vật chủ chốt của Giải thưởng Turing đã bắt đầu dẫn dắt hoạt động nghiên cứu và phát triển AI trong lĩnh vực công nghệ thương mại.

Khi Zuckerberg mời Yann LeCun gia nhập Meta, ông này đã đưa ra ba điều kiện:

1. Không di chuyển khỏi New York;

2. Tôi sẽ không từ chức khỏi công việc của mình tại Đại học New York;

3. Nghiên cứu mở phải được tiến hành, mọi công việc thực hiện phải được công bố công khai và mã nguồn phải là mã mở.

Do đó, phương pháp tiếp cận ban đầu của Meta là mã nguồn mở. Sau khi Yann LeCun gia nhập Meta, ông bắt đầu nghiên cứu và phát triển AI tiên tiến, thành lập Phòng thí nghiệm Nghiên cứu AI Cơ bản, còn được gọi là Phòng thí nghiệm FAIR nổi tiếng, dẫn đầu nghiên cứu tiên phong về trí tuệ nhân tạo.

Tuy nhiên, mục tiêu cuối cùng của Meta là chứng kiến sự tiến bộ của AI trong chính các sản phẩm của mình. Do đó, một nhóm có tên "Generative AI" (AI tạo sinh), hay gọi tắt là "GenAI", đã được thành lập song song với nhóm FAIR.

Nhóm này bao gồm nhiều nhóm chức năng khác nhau, bao gồm nhóm phát triển mô hình nguồn mở Llama, nhóm Meta AI áp dụng khả năng AI vào sản phẩm, nhóm trung tâm dữ liệu xây dựng cơ sở hạ tầng điện toán AI và các phòng ban nhỏ hơn khác như mô hình Tìm kiếm, Doanh nghiệp và Video-gen (tạo video).

GenAI và FAIR là hai thực thể song song, giống như một chiếc cân thăng bằng, với nghiên cứu tiên tiến ở một bên và sản xuất ở bên kia. Lý tưởng nhất là, nghiên cứu tiên tiến sẽ dẫn đến năng lực sản phẩm tốt hơn, trong khi các sản phẩm có lợi nhuận sẽ tạo động lực lớn hơn cho ban quản lý phân bổ ngân sách cho FAIR cho hoạt động R&D.

Tuy nhiên, việc duy trì sự cân bằng như vậy vô thời hạn là một trạng thái lý tưởng hóa quá mức. Và tiền đề của trạng thái lý tưởng này là mô hình AI của Meta phải luôn đi đầu, hoặc ít nhất là dẫn đầu trong lĩnh vực mã nguồn mở, và không bị tụt hậu quá xa so với các mô hình mã nguồn đóng.

Niềm tự hào trước đây và Waterloo của Llama, "ánh sáng của nguồn mở" ?

Meta đặt tên cho mô hình ngôn ngữ lớn của mình là "Llama" được cho là vì chữ viết tắt "LLM" của Large Language Model (Mô hình Ngôn ngữ Lớn) khó phát âm, nên họ đã thêm một nguyên âm. "Llama" cũng dễ nhớ, dễ lan truyền. Đây là cách tên của mô hình ngôn ngữ lớn này gắn liền với loài alpaca.

Chương 2.1 Llama 1: "Hạt giống" của Nguồn mở

Trước tiên, chúng ta hãy xem xét Llama 1, nền tảng đặt nền móng cho phương pháp tiếp cận "nguồn mở" mô hình lớn của Meta.

Vào ngày 24 tháng 2 năm 2023, Meta đã phát hành mô hình Llama, nhấn mạnh "hiệu suất tốt hơn với các tham số nhỏ hơn" (nhiều thang đo: 7B/13B/33B/65B), nhấn mạnh rằng mô hình 13B tại thời điểm đó có thể vượt trội hơn tham số 175B GPT-3 trên nhiều điểm chuẩn.

Một tuần sau thông báo chính thức của Llama, trọng số của nó đã bị "rò rỉ" trên 4chan dưới dạng hạt giống, gây ra cuộc thảo luận rộng rãi trong cộng đồng AI về mô hình nguồn mở và thậm chí còn khiến một thượng nghị sĩ phải viết thư để chất vấn Meta.

Bất chấp nhiều sự hoài nghi, sự ủng hộ bất ngờ của ngành đối với "sự rò rỉ vô tình" của Llama được coi là sự định hình lại bối cảnh "nguồn mở mô hình lớn" và nhanh chóng thúc đẩy nhiều dự án điều chỉnh cơ sở.

Ở đây chúng tôi sẽ giải thích ngắn gọn định nghĩa "nguồn mở" cho các mô hình lớn. Thực ra, Meta cũng không hoàn toàn là nguồn mở. Meta gọi nó là "trọng số mở".

Trong học máy, có ba phần: kiến trúc, trọng số và mã. "Trọng số" là các giá trị số của tất cả các tham số mà mô hình học được. Sau khi mô hình được huấn luyện, tất cả các tham số được lưu trữ trong một số tệp nhị phân lớn. Mỗi tệp chứa các giá trị ma trận cho từng lớp của mạng nơ-ron. Trong quá trình suy luận, mã mô hình tải các tệp trọng số này và sử dụng GPU để thực hiện các phép toán ma trận nhằm tạo ra văn bản.

Do đó, "trọng số mở" có nghĩa là cung cấp các tệp tham số được đào tạo trước cho công chúng, có thể được tải, triển khai và tinh chỉnh cục bộ. Tuy nhiên, nó không hoàn toàn là "nguồn mở ", bởi vì nguồn mở thực sự có nghĩa là công khai dữ liệu đào tạo, mã và giấy phép. Meta đã không tiết lộ thông tin này, và ngay cả các phiên bản Llama 2, 3 và 4 sau đó cũng chỉ công khai các trọng số, với một số nới lỏng trong chính sách cấp phép.

Mặc dù Llama được coi là "nguồn mở bán phần", so với các công ty như OpenAI, Anthropic và Google, là những công ty hoàn toàn đóng và chỉ cung cấp khả năng mô hình thông qua API, nhưng nó đã mang lại sức sống rất mạnh mẽ cho cộng đồng nguồn mở.

Chương 2.2 Llama 2: Mở cho mục đích "Thương mại"

Vào ngày 28 tháng 7 năm 2023, Meta hợp tác với Microsoft đã phát hành mẫu Llama 2 cỡ lớn, bao gồm ba biến thể thông số: 7B, 13B và 70B.

Trong khi "nguồn mở" của thế hệ mô hình mới cũng là "trọng số mở", so với Llama 1, vốn không khả thi về mặt thương mại và chỉ có thể được áp dụng cho mục đích nghiên cứu, Llama 2 là phiên bản miễn phí và khả thi về mặt thương mại với các quyền cấp phép dễ dàng hơn. Hơn nữa, các tạp chí như Wired đã chỉ ra rằng Llama 2 giúp "con đường mở" có thể cạnh tranh với các gã khổng lồ mô hình khép kín.

Như chúng ta đã thấy, Llama 2 nhanh chóng trở nên phổ biến trong cộng đồng nhà phát triển và sự xuất hiện của nó đã khuếch đại đáng kể hệ sinh thái và sự phát triển AI.

Sau đó là Llama 3 vào năm 2024, đây là thời điểm huy hoàng nhất của dòng phim Llama.

Chương 2.3 Loạt bài Llama 3: Tiếp cận phe Nguồn đóng

Với sự ra đời của Llama3, Meta đã trở thành một trong những công ty hàng đầu trong cộng đồng AI nguồn mở. Từ tháng 4 đến tháng 9 năm 2024, Meta đã phát hành ba phiên bản mô hình.

Vào ngày 18 tháng 4 năm 2024, Meta đã phát hành hai phiên bản Llama 3, 8B và 70B, tuyên bố rằng chúng "vượt trội hơn đáng kể so với Llama 2" về cùng kích thước và sử dụng chúng làm một trong những cơ sở cho Trợ lý AI Meta.

Vào ngày 23 tháng 7, Meta đã ra mắt ba mô hình Llama 3.1: 405B, 70B và 8B, đồng thời tuyên bố rằng 405B là một trong những "mô hình cơ sở hạ tầng mở và khả dụng mạnh nhất thế giới"; nó cũng được ra mắt trên các nền tảng như AWS Bedrock và IBM Watsonx.

Chỉ hai tháng sau, vào ngày 25 tháng 9 năm 2024, Meta đã ra mắt Llama 3.2, tập trung vào các tính năng đa phương thức nhỏ nhưng toàn diện. Phiên bản này bổ sung các mô hình văn bản nhẹ 1B và 3B cùng các mô hình đa phương thức trực quan 1B và 90B, hướng đến các kịch bản thiết bị đầu cuối/biên. Các nền tảng như AWS cũng được kết nối đồng thời, và nền tảng khung công tác mã nguồn mở OLAMA cũng có thể chạy cục bộ.

Gavin Wang từ nhóm Llama 3, người phụ trách công tác hậu đào tạo cho Llama 3 cho biết rằng vào thời điểm đó, toàn bộ nhóm Meta và GenAI đang tiến triển với "tốc độ ánh sáng" và thực sự có cảm giác như "một ngày trong AI giống như một năm trong thế giới loài người".

Sự ra mắt mạnh mẽ của Llama 3, đặc biệt là phiên bản 450B, được đánh giá là đang tiệm cận nhóm mã nguồn đóng về khả năng mô hình và cũng được kỳ vọng sẽ đẩy nhanh việc triển khai các ứng dụng AI. Đối với nhân viên Meta, đặc biệt là các kỹ sư AI trong nhóm Llama, đây là một dự án mà họ rất tự hào.

Dựa trên đà phát triển này, Meta hy vọng rằng việc phát hành Llama 4 sẽ mở rộng hơn nữa ảnh hưởng của mình trong cộng đồng phát triển AI và duy trì vị thế là "sự hiện diện nguồn mở duy nhất trong số các mô hình lớn hàng đầu".

Zuckerberg đã đăng sau cuộc gọi về thu nhập vào cuối tháng 1 năm 2025, "Mục tiêu của chúng tôi đối với Llama 3 là làm cho các mô hình nguồn mở và đóng có tính cạnh tranh, trong khi mục tiêu của chúng tôi đối với Llama 4 là dẫn đầu."

Tuy nhiên, việc phát hành Llama 4 ba tháng sau đó lại là một thảm họa hoàn toàn và là một trận Waterloo.

Chương 2.4 Llama 4: Waterloo

Vào ngày 5 tháng 4 năm 2025, Meta đã phát hành hai phiên bản Llama 4 (Scout và Maverick), tuyên bố có bước tiến đáng kể về khả năng đa phương thức và ngữ cảnh dài, đồng thời trích dẫn nổi bật hiệu suất dẫn đầu của phiên bản này trên bảng xếp hạng LMARaena trong tài liệu quảng cáo: phiên bản Maverick chỉ đứng sau Gemini 2.5 Pro, đồng hạng nhì với ChatGPT 4o và Grok 3 Pro.

Tuy nhiên, phản hồi từ cộng đồng nhà phát triển nhanh chóng trở nên tiêu cực, với nhiều người cho rằng hiệu suất của Llama 4 không đạt kỳ vọng. Tin đồn bắt đầu lan truyền rằng phiên bản Meta đạt vị trí thứ hai trên LMARaena bị nghi ngờ gian lận, với nghi ngờ rằng Llama 4 đang sử dụng một biến thể được tối ưu hóa đã được huấn luyện với tính năng tăng cường hội thoại, có khả năng gây hiểu lầm cho LMARaena và gây ra hiện tượng quá khớp.

Mặc dù ban lãnh đạo Meta nhanh chóng phủ nhận hành vi gian lận, nhưng tác động lan truyền nhanh chóng. Một mặt, giới truyền thông coi đây là một chiêu trò "đánh tráo" "sử dụng phiên bản được tinh chỉnh đặc biệt để tăng thứ hạng", và cuộc thảo luận trong ngành về độ tin cậy và khả năng tái tạo của chuẩn mực này ngày càng gay gắt. Mặt khác, việc phát hành phiên bản Behemoth tiên tiến hơn của Meta đã bị trì hoãn, ảnh hưởng nghiêm trọng đến quan hệ công chúng và lịch trình phát hành.

Tính đến thời điểm hiện tại, Behemoth vẫn chưa được phát hành và Meta có thể đã từ bỏ dự án.

Những gì diễn ra sau đó là điều mà mọi người đều biết: Zuckerberg đã thực hiện một vụ mua lại Scale AI đầy liều lĩnh và rủi ro cao, lôi kéo Alexander Wang để lãnh đạo kiến trúc AI mới, sau đó bắt đầu lôi kéo nhân tài bằng hàng trăm triệu đô la, làm gián đoạn thị trường nhân tài AI ở Thung lũng Silicon.

Sau đó là tin tức gần đây rằng Alex đã bắt đầu tái cấu trúc toàn bộ kiến trúc AI của Meta và sa thải 600 người.

Nhưng nếu nhìn vào dòng thời gian này, chẳng phải nó vẫn còn rất rời rạc sao? Chuyện gì đã xảy ra trong năm giữa Llama 3 và Llama 4? Làm thế nào mà Llama 4 đột nhiên trở nên vô dụng? Chẳng phải quá nhanh sao?

Bằng cách xem xét dữ liệu, chúng ta có thể tìm ra một số câu trả lời. Bạn còn nhớ khi chúng tôi đề cập trước đó rằng kiến trúc AI nội bộ của Meta là một thang đo cân bằng không? Lý do Llama 4 thất bại là vì thang đo này không cân bằng.

Sự cân bằng không cân bằng: Cuộc tranh luận giữa nghiên cứu tiên tiến và thương mại hóa

Trong kiến trúc AI của Meta, FAIR và GenAI là hai nhóm song song. Yann LeCun phụ trách FAIR, nhưng ông thường đắm chìm trong nghiên cứu và phát triển của riêng mình. Đôi khi ông tranh luận trực tuyến với những người như Musk, và thường nói rằng ông không lạc quan về lộ trình học Thạc sĩ Luật (LLM), điều này khiến Meta đau đầu.

Do đó, vào tháng 2 năm 2023, các giám đốc điều hành của Meta đã chuyển Joelle Pineau, người đứng đầu bộ phận nghiên cứu tại Meta AI, đến FAIR để giữ chức vụ người đứng đầu toàn cầu của FAIR, nơi bà sẽ lãnh đạo FAIR cùng với Yann LeCun.

Người đứng đầu GenAI là Ahmad Al-Dahle, người đã làm việc tại Apple gần 17 năm. Zuckerberg đã tuyển dụng ông để kết hợp AI với nhiều sản phẩm Meta, bao gồm Metaverse, tích hợp AI vào kính thông minh và công cụ trò chuyện meta.ai, v.v.

Khi công ty bắt đầu phát triển Llama 3 sau thành công của Llama 2, các giám đốc điều hành của Meta ngày càng nhấn mạnh đến nhu cầu "sử dụng AI trong các sản phẩm của riêng họ".

Kết quả là, vào tháng 1 năm 2024, nhóm AI của Meta đã tiến hành tái tổ chức, với hai người đứng đầu FAIR bắt đầu báo cáo trực tiếp cho CPO (Giám đốc sản phẩm) của Meta, Chris Cox.

Với sự ra mắt thành công của Llama 3, các giám đốc điều hành của Meta bắt đầu phát triển lộ trình cho Llama 4, tập trung toàn bộ sự chú ý vào tích hợp sản phẩm, cụ thể là khả năng đa phương thức, do đó bỏ qua tầm quan trọng của khả năng suy luận mô hình.

Trên thực tế, các nhà nghiên cứu như Tian Yuandong trong nhóm FAIR đã bắt đầu nghiên cứu về chuỗi suy nghĩ, nhưng việc khám phá tiên tiến về khả năng lập luận này đã không được truyền đạt kịp thời cho nhóm thiết kế mô hình Llama.

Sự xuất hiện của dòng o1 của OpenAI và DeepSeek đã khiến Meta rơi vào tình trạng hỗn loạn vào đầu năm 2025. Do đó, cấp trên đã tạm thời giao cho nhóm nghiên cứu của FAIR nhiệm vụ hỗ trợ phát triển Llama 4, hay chính xác hơn là "dập lửa", và "đội chữa cháy" này do Tian Yuandong chỉ huy.

Về cơ bản, chúng ta có thể tìm thấy một số câu trả lời ở đây. Bắt đầu từ Llama 3, lộ trình "sản xuất AI" đã được thiết lập. Toàn bộ mô hình tập trung vào phát triển đa phương thức và ứng dụng, bận rộn tích hợp ứng dụng và doanh nghiệp, nhưng lại bỏ bê suy luận và nghiên cứu và phát triển công nghệ tiên tiến hơn . Điều này buộc nhóm FAIR ở phía bên kia thang đo phải đến từ các nhóm khác để "dập lửa", và đó là lý do tại sao thang đo trở nên mất cân bằng.

Vậy Zuckerberg đã khắc phục sự mất cân bằng này như thế nào? Ông ấy đã trực tiếp nhảy dù vào một đơn vị đặc nhiệm: đội TBD do Alex Wang chỉ huy.

Một vị vua mới xuất hiện. Alex Wang, 28 tuổi, nhận được "quyền lợi không giới hạn"

Kiến trúc kinh doanh AI của Meta đã được tái cấu trúc một lần nữa và ban quản lý cấp cao cũng đã trải qua một loạt biến động.

Alex Wang đã dẫn dắt hàng chục nhà nghiên cứu hàng đầu được tuyển dụng với mức lương cao để thành lập một nhóm đặc biệt mang tên TBD, được hưởng các đặc quyền và ưu tiên không giới hạn trong Meta. TBD, FAIR và GenAI cùng nhau thành lập Meta Superintelligence Labs (MSL), báo cáo trực tiếp cho Alex, và Alex lại báo cáo trực tiếp cho Zuckerberg.

Điều này cũng có nghĩa là Yann LeCun của FAIR hiện báo cáo với Alex, trong khi Joelle Pineau trước đây phải báo cáo với Ahmad, người đứng đầu nhóm GenAI.

Chúng ta đã thấy Joelle rời đi vào tháng 5 để trở thành Giám đốc AI tại Cohere; Ahmad đã im lặng trong một thời gian dài và không được bổ nhiệm để lãnh đạo bất kỳ dự án quan trọng nào; và CPO Chris Cox đã bị Alex làm lu mờ và bị loại khỏi vị trí lãnh đạo trực tiếp của nhóm AI.

Vì vậy, cấu trúc hiện tại là Alex, 28 tuổi, là người duy nhất phụ trách.

Đã có nhiều lời phàn nàn trong Meta về Alex và nhóm cực kỳ đặc quyền mà anh ta lãnh đạo, bao gồm cả việc các thành viên trong nhóm TBD không cần đánh giá hiệu suất trong ba năm, có thể bỏ qua hoặc không trả lời tin nhắn từ bất kỳ Phó chủ tịch nào khác và tất cả các bài báo của Meta AI đều phải được những người trong TBD xem xét trước khi có thể được xuất bản.

Điều đáng chú ý là nhiều người trong TBD còn khá trẻ, điều này khiến nhiều nhà nghiên cứu cấp cao rất không hài lòng. Tóm lại, có vẻ như một làn sóng đấu tranh chính trị nội bộ khác sắp bùng nổ.

Nhưng không thể phủ nhận, đặc quyền luôn đi kèm với thành tựu. Đối với Zuckerberg, thành tựu này không chỉ là "Làm cho Llama Vĩ đại Trở lại", mà còn là "Meta phải chiến thắng " .

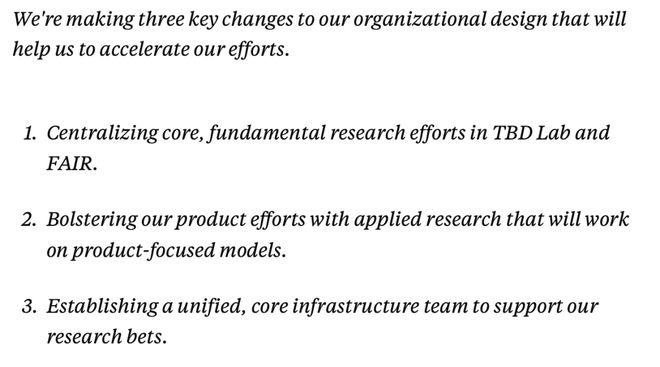

Trong cuộc đua AI này, việc tái cấu trúc này có thể là cơ hội cuối cùng và quan trọng nhất của Zuckerberg. Alex đã phác thảo ba thay đổi mà anh sẽ thực hiện trong một email nội bộ:

1. Tập trung các thế mạnh nghiên cứu cơ bản cốt lõi của nhóm TBD và FAIR;

2. Tăng cường tích hợp phát triển sản phẩm và ứng dụng, tiếp tục lấy sản phẩm làm trọng tâm mô hình;

3. Thành lập nhóm cơ sở hạ tầng cốt lõi để hỗ trợ nghiên cứu cá cược.

Liệu Alex có thể thực hiện được lời hứa của Zuckerberg hay không vẫn còn phải chờ xem, và chúng ta có thể sớm có câu trả lời.

Tóm lại, Meta là mô hình nguồn mở hàng đầu trong ba thế hệ đầu tiên của Llama, dẫn đầu nhóm nguồn mở cạnh tranh với các nhóm nguồn đóng như OpenAI và Google Gemini.

Tuy nhiên, sau thành công vang dội của Llama 3, ban lãnh đạo cấp cao của công ty đã rất mong muốn kết hợp AI với sản xuất hàng loạt. Khi lập lộ trình, họ đã áp dụng tư duy "Nghiên cứu và Phát triển lấy sản phẩm làm trọng tâm" và tập trung nâng cấp Llama 4 vào hiệu suất kỹ thuật như đa phương thức, nhưng lại bỏ lỡ lợi thế về thời gian của các công nghệ suy luận tiên tiến như CoT.

Mặc dù Tian Yuandong và các nhà khoa học AI khác tại FAIR đã nghiên cứu CoT vào thời điểm đó, nhưng sau khi DeepSeek gây chấn động, nhóm của Tian Yuandong tại FAIR đã tạm thời được huy động để tối ưu hóa kiến trúc MoE trên Llama 4, điều này đã làm gián đoạn quá trình nghiên cứu và phát triển CoT cũng như suy luận, khiến sự cân bằng giữa nghiên cứu công nghệ AI tiên tiến và kỹ thuật sản phẩm trở nên hoàn toàn mất cân bằng.

Bạn có nghĩ rằng đợt tái cấu trúc lớn này do sự thất bại của Llama 4 là cơ hội cuối cùng của Meta AI không? Hãy thoải mái để lại bình luận bên dưới và cho chúng tôi biết nhé.

Một mặt, Zuckerberg đang săn đón nhân tài AI với mức lương hàng năm lên tới hàng trăm triệu đô la, nhưng đồng thời lại sa thải nhân viên một cách quyết liệt. Nguyên nhân đằng sau hành vi mâu thuẫn này là gì?

Vì vậy, chúng tôi đã phỏng vấn Tian Yuandong, cựu Giám đốc nghiên cứu FAIR và Nhà khoa học AI tại Meta; Gavin Wang, cựu nhân viên của Meta đã tham gia khóa đào tạo sau Llama 3; một chuyên gia nhân sự cấp cao từ Thung lũng Silicon; và một số cá nhân ẩn danh, nhằm mục đích tái hiện lại chính xác những gì đã xảy ra với lộ trình mã nguồn mở Llama của Meta:

Tại sao Llama 3 lại gây ấn tượng mạnh mẽ, trong khi Llama 4, ra mắt chỉ một năm sau đó, lại gây thất vọng đến vậy? Chuyện gì đã xảy ra trong khoảng thời gian đó? Phải chăng phương pháp nguồn mở của Meta đã thất bại ngay từ đầu? Trong bối cảnh cạnh tranh khốc liệt hiện nay giữa các mô hình AI lớn, liệu một phòng nghiên cứu AI lý tưởng có còn tồn tại?

Sự ra đời của FAIR và GenAI; Chiến lược AI và quá trình phát triển kiến trúc trong mười năm của Meta.

Trước tiên, chúng ta hãy xem xét cấu trúc công ty tổng thể của Meta liên quan đến chiến lược AI của công ty.

Cuối năm 2013, Zuckerberg bắt đầu xây dựng đội ngũ AI của Meta. Vào thời điểm đó, Google đã mua lại đội ngũ DNN của Geoffrey Hinton và tuyển dụng Hinton, trong khi Meta đưa Yann LeCun vào để giám sát việc phát triển AI. Nhờ đó, hai trong số ba nhân vật chủ chốt của Giải thưởng Turing đã bắt đầu dẫn dắt hoạt động nghiên cứu và phát triển AI trong lĩnh vực công nghệ thương mại.

Khi Zuckerberg mời Yann LeCun gia nhập Meta, ông này đã đưa ra ba điều kiện:

1. Không di chuyển khỏi New York;

2. Tôi sẽ không từ chức khỏi công việc của mình tại Đại học New York;

3. Nghiên cứu mở phải được tiến hành, mọi công việc thực hiện phải được công bố công khai và mã nguồn phải là mã mở.

Do đó, phương pháp tiếp cận ban đầu của Meta là mã nguồn mở. Sau khi Yann LeCun gia nhập Meta, ông bắt đầu nghiên cứu và phát triển AI tiên tiến, thành lập Phòng thí nghiệm Nghiên cứu AI Cơ bản, còn được gọi là Phòng thí nghiệm FAIR nổi tiếng, dẫn đầu nghiên cứu tiên phong về trí tuệ nhân tạo.

Tuy nhiên, mục tiêu cuối cùng của Meta là chứng kiến sự tiến bộ của AI trong chính các sản phẩm của mình. Do đó, một nhóm có tên "Generative AI" (AI tạo sinh), hay gọi tắt là "GenAI", đã được thành lập song song với nhóm FAIR.

Nhóm này bao gồm nhiều nhóm chức năng khác nhau, bao gồm nhóm phát triển mô hình nguồn mở Llama, nhóm Meta AI áp dụng khả năng AI vào sản phẩm, nhóm trung tâm dữ liệu xây dựng cơ sở hạ tầng điện toán AI và các phòng ban nhỏ hơn khác như mô hình Tìm kiếm, Doanh nghiệp và Video-gen (tạo video).

GenAI và FAIR là hai thực thể song song, giống như một chiếc cân thăng bằng, với nghiên cứu tiên tiến ở một bên và sản xuất ở bên kia. Lý tưởng nhất là, nghiên cứu tiên tiến sẽ dẫn đến năng lực sản phẩm tốt hơn, trong khi các sản phẩm có lợi nhuận sẽ tạo động lực lớn hơn cho ban quản lý phân bổ ngân sách cho FAIR cho hoạt động R&D.

Tuy nhiên, việc duy trì sự cân bằng như vậy vô thời hạn là một trạng thái lý tưởng hóa quá mức. Và tiền đề của trạng thái lý tưởng này là mô hình AI của Meta phải luôn đi đầu, hoặc ít nhất là dẫn đầu trong lĩnh vực mã nguồn mở, và không bị tụt hậu quá xa so với các mô hình mã nguồn đóng.

Niềm tự hào trước đây và Waterloo của Llama, "ánh sáng của nguồn mở" ?

Meta đặt tên cho mô hình ngôn ngữ lớn của mình là "Llama" được cho là vì chữ viết tắt "LLM" của Large Language Model (Mô hình Ngôn ngữ Lớn) khó phát âm, nên họ đã thêm một nguyên âm. "Llama" cũng dễ nhớ, dễ lan truyền. Đây là cách tên của mô hình ngôn ngữ lớn này gắn liền với loài alpaca.

Chương 2.1 Llama 1: "Hạt giống" của Nguồn mở

Trước tiên, chúng ta hãy xem xét Llama 1, nền tảng đặt nền móng cho phương pháp tiếp cận "nguồn mở" mô hình lớn của Meta.

Vào ngày 24 tháng 2 năm 2023, Meta đã phát hành mô hình Llama, nhấn mạnh "hiệu suất tốt hơn với các tham số nhỏ hơn" (nhiều thang đo: 7B/13B/33B/65B), nhấn mạnh rằng mô hình 13B tại thời điểm đó có thể vượt trội hơn tham số 175B GPT-3 trên nhiều điểm chuẩn.

Một tuần sau thông báo chính thức của Llama, trọng số của nó đã bị "rò rỉ" trên 4chan dưới dạng hạt giống, gây ra cuộc thảo luận rộng rãi trong cộng đồng AI về mô hình nguồn mở và thậm chí còn khiến một thượng nghị sĩ phải viết thư để chất vấn Meta.

Bất chấp nhiều sự hoài nghi, sự ủng hộ bất ngờ của ngành đối với "sự rò rỉ vô tình" của Llama được coi là sự định hình lại bối cảnh "nguồn mở mô hình lớn" và nhanh chóng thúc đẩy nhiều dự án điều chỉnh cơ sở.

Ở đây chúng tôi sẽ giải thích ngắn gọn định nghĩa "nguồn mở" cho các mô hình lớn. Thực ra, Meta cũng không hoàn toàn là nguồn mở. Meta gọi nó là "trọng số mở".

Trong học máy, có ba phần: kiến trúc, trọng số và mã. "Trọng số" là các giá trị số của tất cả các tham số mà mô hình học được. Sau khi mô hình được huấn luyện, tất cả các tham số được lưu trữ trong một số tệp nhị phân lớn. Mỗi tệp chứa các giá trị ma trận cho từng lớp của mạng nơ-ron. Trong quá trình suy luận, mã mô hình tải các tệp trọng số này và sử dụng GPU để thực hiện các phép toán ma trận nhằm tạo ra văn bản.

Do đó, "trọng số mở" có nghĩa là cung cấp các tệp tham số được đào tạo trước cho công chúng, có thể được tải, triển khai và tinh chỉnh cục bộ. Tuy nhiên, nó không hoàn toàn là "nguồn mở ", bởi vì nguồn mở thực sự có nghĩa là công khai dữ liệu đào tạo, mã và giấy phép. Meta đã không tiết lộ thông tin này, và ngay cả các phiên bản Llama 2, 3 và 4 sau đó cũng chỉ công khai các trọng số, với một số nới lỏng trong chính sách cấp phép.

Mặc dù Llama được coi là "nguồn mở bán phần", so với các công ty như OpenAI, Anthropic và Google, là những công ty hoàn toàn đóng và chỉ cung cấp khả năng mô hình thông qua API, nhưng nó đã mang lại sức sống rất mạnh mẽ cho cộng đồng nguồn mở.

Chương 2.2 Llama 2: Mở cho mục đích "Thương mại"

Vào ngày 28 tháng 7 năm 2023, Meta hợp tác với Microsoft đã phát hành mẫu Llama 2 cỡ lớn, bao gồm ba biến thể thông số: 7B, 13B và 70B.

Trong khi "nguồn mở" của thế hệ mô hình mới cũng là "trọng số mở", so với Llama 1, vốn không khả thi về mặt thương mại và chỉ có thể được áp dụng cho mục đích nghiên cứu, Llama 2 là phiên bản miễn phí và khả thi về mặt thương mại với các quyền cấp phép dễ dàng hơn. Hơn nữa, các tạp chí như Wired đã chỉ ra rằng Llama 2 giúp "con đường mở" có thể cạnh tranh với các gã khổng lồ mô hình khép kín.

Như chúng ta đã thấy, Llama 2 nhanh chóng trở nên phổ biến trong cộng đồng nhà phát triển và sự xuất hiện của nó đã khuếch đại đáng kể hệ sinh thái và sự phát triển AI.

Sau đó là Llama 3 vào năm 2024, đây là thời điểm huy hoàng nhất của dòng phim Llama.

Chương 2.3 Loạt bài Llama 3: Tiếp cận phe Nguồn đóng

Với sự ra đời của Llama3, Meta đã trở thành một trong những công ty hàng đầu trong cộng đồng AI nguồn mở. Từ tháng 4 đến tháng 9 năm 2024, Meta đã phát hành ba phiên bản mô hình.

Vào ngày 18 tháng 4 năm 2024, Meta đã phát hành hai phiên bản Llama 3, 8B và 70B, tuyên bố rằng chúng "vượt trội hơn đáng kể so với Llama 2" về cùng kích thước và sử dụng chúng làm một trong những cơ sở cho Trợ lý AI Meta.

Vào ngày 23 tháng 7, Meta đã ra mắt ba mô hình Llama 3.1: 405B, 70B và 8B, đồng thời tuyên bố rằng 405B là một trong những "mô hình cơ sở hạ tầng mở và khả dụng mạnh nhất thế giới"; nó cũng được ra mắt trên các nền tảng như AWS Bedrock và IBM Watsonx.

Chỉ hai tháng sau, vào ngày 25 tháng 9 năm 2024, Meta đã ra mắt Llama 3.2, tập trung vào các tính năng đa phương thức nhỏ nhưng toàn diện. Phiên bản này bổ sung các mô hình văn bản nhẹ 1B và 3B cùng các mô hình đa phương thức trực quan 1B và 90B, hướng đến các kịch bản thiết bị đầu cuối/biên. Các nền tảng như AWS cũng được kết nối đồng thời, và nền tảng khung công tác mã nguồn mở OLAMA cũng có thể chạy cục bộ.

Gavin Wang từ nhóm Llama 3, người phụ trách công tác hậu đào tạo cho Llama 3 cho biết rằng vào thời điểm đó, toàn bộ nhóm Meta và GenAI đang tiến triển với "tốc độ ánh sáng" và thực sự có cảm giác như "một ngày trong AI giống như một năm trong thế giới loài người".

Sự ra mắt mạnh mẽ của Llama 3, đặc biệt là phiên bản 450B, được đánh giá là đang tiệm cận nhóm mã nguồn đóng về khả năng mô hình và cũng được kỳ vọng sẽ đẩy nhanh việc triển khai các ứng dụng AI. Đối với nhân viên Meta, đặc biệt là các kỹ sư AI trong nhóm Llama, đây là một dự án mà họ rất tự hào.

Dựa trên đà phát triển này, Meta hy vọng rằng việc phát hành Llama 4 sẽ mở rộng hơn nữa ảnh hưởng của mình trong cộng đồng phát triển AI và duy trì vị thế là "sự hiện diện nguồn mở duy nhất trong số các mô hình lớn hàng đầu".

Zuckerberg đã đăng sau cuộc gọi về thu nhập vào cuối tháng 1 năm 2025, "Mục tiêu của chúng tôi đối với Llama 3 là làm cho các mô hình nguồn mở và đóng có tính cạnh tranh, trong khi mục tiêu của chúng tôi đối với Llama 4 là dẫn đầu."

Tuy nhiên, việc phát hành Llama 4 ba tháng sau đó lại là một thảm họa hoàn toàn và là một trận Waterloo.

Chương 2.4 Llama 4: Waterloo

Vào ngày 5 tháng 4 năm 2025, Meta đã phát hành hai phiên bản Llama 4 (Scout và Maverick), tuyên bố có bước tiến đáng kể về khả năng đa phương thức và ngữ cảnh dài, đồng thời trích dẫn nổi bật hiệu suất dẫn đầu của phiên bản này trên bảng xếp hạng LMARaena trong tài liệu quảng cáo: phiên bản Maverick chỉ đứng sau Gemini 2.5 Pro, đồng hạng nhì với ChatGPT 4o và Grok 3 Pro.

Tuy nhiên, phản hồi từ cộng đồng nhà phát triển nhanh chóng trở nên tiêu cực, với nhiều người cho rằng hiệu suất của Llama 4 không đạt kỳ vọng. Tin đồn bắt đầu lan truyền rằng phiên bản Meta đạt vị trí thứ hai trên LMARaena bị nghi ngờ gian lận, với nghi ngờ rằng Llama 4 đang sử dụng một biến thể được tối ưu hóa đã được huấn luyện với tính năng tăng cường hội thoại, có khả năng gây hiểu lầm cho LMARaena và gây ra hiện tượng quá khớp.

Mặc dù ban lãnh đạo Meta nhanh chóng phủ nhận hành vi gian lận, nhưng tác động lan truyền nhanh chóng. Một mặt, giới truyền thông coi đây là một chiêu trò "đánh tráo" "sử dụng phiên bản được tinh chỉnh đặc biệt để tăng thứ hạng", và cuộc thảo luận trong ngành về độ tin cậy và khả năng tái tạo của chuẩn mực này ngày càng gay gắt. Mặt khác, việc phát hành phiên bản Behemoth tiên tiến hơn của Meta đã bị trì hoãn, ảnh hưởng nghiêm trọng đến quan hệ công chúng và lịch trình phát hành.

Tính đến thời điểm hiện tại, Behemoth vẫn chưa được phát hành và Meta có thể đã từ bỏ dự án.

Những gì diễn ra sau đó là điều mà mọi người đều biết: Zuckerberg đã thực hiện một vụ mua lại Scale AI đầy liều lĩnh và rủi ro cao, lôi kéo Alexander Wang để lãnh đạo kiến trúc AI mới, sau đó bắt đầu lôi kéo nhân tài bằng hàng trăm triệu đô la, làm gián đoạn thị trường nhân tài AI ở Thung lũng Silicon.

Sau đó là tin tức gần đây rằng Alex đã bắt đầu tái cấu trúc toàn bộ kiến trúc AI của Meta và sa thải 600 người.

Nhưng nếu nhìn vào dòng thời gian này, chẳng phải nó vẫn còn rất rời rạc sao? Chuyện gì đã xảy ra trong năm giữa Llama 3 và Llama 4? Làm thế nào mà Llama 4 đột nhiên trở nên vô dụng? Chẳng phải quá nhanh sao?

Bằng cách xem xét dữ liệu, chúng ta có thể tìm ra một số câu trả lời. Bạn còn nhớ khi chúng tôi đề cập trước đó rằng kiến trúc AI nội bộ của Meta là một thang đo cân bằng không? Lý do Llama 4 thất bại là vì thang đo này không cân bằng.

Sự cân bằng không cân bằng: Cuộc tranh luận giữa nghiên cứu tiên tiến và thương mại hóa

Trong kiến trúc AI của Meta, FAIR và GenAI là hai nhóm song song. Yann LeCun phụ trách FAIR, nhưng ông thường đắm chìm trong nghiên cứu và phát triển của riêng mình. Đôi khi ông tranh luận trực tuyến với những người như Musk, và thường nói rằng ông không lạc quan về lộ trình học Thạc sĩ Luật (LLM), điều này khiến Meta đau đầu.

Do đó, vào tháng 2 năm 2023, các giám đốc điều hành của Meta đã chuyển Joelle Pineau, người đứng đầu bộ phận nghiên cứu tại Meta AI, đến FAIR để giữ chức vụ người đứng đầu toàn cầu của FAIR, nơi bà sẽ lãnh đạo FAIR cùng với Yann LeCun.

Người đứng đầu GenAI là Ahmad Al-Dahle, người đã làm việc tại Apple gần 17 năm. Zuckerberg đã tuyển dụng ông để kết hợp AI với nhiều sản phẩm Meta, bao gồm Metaverse, tích hợp AI vào kính thông minh và công cụ trò chuyện meta.ai, v.v.

Khi công ty bắt đầu phát triển Llama 3 sau thành công của Llama 2, các giám đốc điều hành của Meta ngày càng nhấn mạnh đến nhu cầu "sử dụng AI trong các sản phẩm của riêng họ".

Kết quả là, vào tháng 1 năm 2024, nhóm AI của Meta đã tiến hành tái tổ chức, với hai người đứng đầu FAIR bắt đầu báo cáo trực tiếp cho CPO (Giám đốc sản phẩm) của Meta, Chris Cox.

Với sự ra mắt thành công của Llama 3, các giám đốc điều hành của Meta bắt đầu phát triển lộ trình cho Llama 4, tập trung toàn bộ sự chú ý vào tích hợp sản phẩm, cụ thể là khả năng đa phương thức, do đó bỏ qua tầm quan trọng của khả năng suy luận mô hình.

Trên thực tế, các nhà nghiên cứu như Tian Yuandong trong nhóm FAIR đã bắt đầu nghiên cứu về chuỗi suy nghĩ, nhưng việc khám phá tiên tiến về khả năng lập luận này đã không được truyền đạt kịp thời cho nhóm thiết kế mô hình Llama.

Sự xuất hiện của dòng o1 của OpenAI và DeepSeek đã khiến Meta rơi vào tình trạng hỗn loạn vào đầu năm 2025. Do đó, cấp trên đã tạm thời giao cho nhóm nghiên cứu của FAIR nhiệm vụ hỗ trợ phát triển Llama 4, hay chính xác hơn là "dập lửa", và "đội chữa cháy" này do Tian Yuandong chỉ huy.

Về cơ bản, chúng ta có thể tìm thấy một số câu trả lời ở đây. Bắt đầu từ Llama 3, lộ trình "sản xuất AI" đã được thiết lập. Toàn bộ mô hình tập trung vào phát triển đa phương thức và ứng dụng, bận rộn tích hợp ứng dụng và doanh nghiệp, nhưng lại bỏ bê suy luận và nghiên cứu và phát triển công nghệ tiên tiến hơn . Điều này buộc nhóm FAIR ở phía bên kia thang đo phải đến từ các nhóm khác để "dập lửa", và đó là lý do tại sao thang đo trở nên mất cân bằng.

Vậy Zuckerberg đã khắc phục sự mất cân bằng này như thế nào? Ông ấy đã trực tiếp nhảy dù vào một đơn vị đặc nhiệm: đội TBD do Alex Wang chỉ huy.

Một vị vua mới xuất hiện. Alex Wang, 28 tuổi, nhận được "quyền lợi không giới hạn"

Kiến trúc kinh doanh AI của Meta đã được tái cấu trúc một lần nữa và ban quản lý cấp cao cũng đã trải qua một loạt biến động.

Alex Wang đã dẫn dắt hàng chục nhà nghiên cứu hàng đầu được tuyển dụng với mức lương cao để thành lập một nhóm đặc biệt mang tên TBD, được hưởng các đặc quyền và ưu tiên không giới hạn trong Meta. TBD, FAIR và GenAI cùng nhau thành lập Meta Superintelligence Labs (MSL), báo cáo trực tiếp cho Alex, và Alex lại báo cáo trực tiếp cho Zuckerberg.

Điều này cũng có nghĩa là Yann LeCun của FAIR hiện báo cáo với Alex, trong khi Joelle Pineau trước đây phải báo cáo với Ahmad, người đứng đầu nhóm GenAI.

Chúng ta đã thấy Joelle rời đi vào tháng 5 để trở thành Giám đốc AI tại Cohere; Ahmad đã im lặng trong một thời gian dài và không được bổ nhiệm để lãnh đạo bất kỳ dự án quan trọng nào; và CPO Chris Cox đã bị Alex làm lu mờ và bị loại khỏi vị trí lãnh đạo trực tiếp của nhóm AI.

Vì vậy, cấu trúc hiện tại là Alex, 28 tuổi, là người duy nhất phụ trách.

Đã có nhiều lời phàn nàn trong Meta về Alex và nhóm cực kỳ đặc quyền mà anh ta lãnh đạo, bao gồm cả việc các thành viên trong nhóm TBD không cần đánh giá hiệu suất trong ba năm, có thể bỏ qua hoặc không trả lời tin nhắn từ bất kỳ Phó chủ tịch nào khác và tất cả các bài báo của Meta AI đều phải được những người trong TBD xem xét trước khi có thể được xuất bản.

Điều đáng chú ý là nhiều người trong TBD còn khá trẻ, điều này khiến nhiều nhà nghiên cứu cấp cao rất không hài lòng. Tóm lại, có vẻ như một làn sóng đấu tranh chính trị nội bộ khác sắp bùng nổ.

Nhưng không thể phủ nhận, đặc quyền luôn đi kèm với thành tựu. Đối với Zuckerberg, thành tựu này không chỉ là "Làm cho Llama Vĩ đại Trở lại", mà còn là "Meta phải chiến thắng " .

Trong cuộc đua AI này, việc tái cấu trúc này có thể là cơ hội cuối cùng và quan trọng nhất của Zuckerberg. Alex đã phác thảo ba thay đổi mà anh sẽ thực hiện trong một email nội bộ:

1. Tập trung các thế mạnh nghiên cứu cơ bản cốt lõi của nhóm TBD và FAIR;

2. Tăng cường tích hợp phát triển sản phẩm và ứng dụng, tiếp tục lấy sản phẩm làm trọng tâm mô hình;

3. Thành lập nhóm cơ sở hạ tầng cốt lõi để hỗ trợ nghiên cứu cá cược.

Liệu Alex có thể thực hiện được lời hứa của Zuckerberg hay không vẫn còn phải chờ xem, và chúng ta có thể sớm có câu trả lời.

Tóm lại, Meta là mô hình nguồn mở hàng đầu trong ba thế hệ đầu tiên của Llama, dẫn đầu nhóm nguồn mở cạnh tranh với các nhóm nguồn đóng như OpenAI và Google Gemini.

Tuy nhiên, sau thành công vang dội của Llama 3, ban lãnh đạo cấp cao của công ty đã rất mong muốn kết hợp AI với sản xuất hàng loạt. Khi lập lộ trình, họ đã áp dụng tư duy "Nghiên cứu và Phát triển lấy sản phẩm làm trọng tâm" và tập trung nâng cấp Llama 4 vào hiệu suất kỹ thuật như đa phương thức, nhưng lại bỏ lỡ lợi thế về thời gian của các công nghệ suy luận tiên tiến như CoT.

Mặc dù Tian Yuandong và các nhà khoa học AI khác tại FAIR đã nghiên cứu CoT vào thời điểm đó, nhưng sau khi DeepSeek gây chấn động, nhóm của Tian Yuandong tại FAIR đã tạm thời được huy động để tối ưu hóa kiến trúc MoE trên Llama 4, điều này đã làm gián đoạn quá trình nghiên cứu và phát triển CoT cũng như suy luận, khiến sự cân bằng giữa nghiên cứu công nghệ AI tiên tiến và kỹ thuật sản phẩm trở nên hoàn toàn mất cân bằng.

Bạn có nghĩ rằng đợt tái cấu trúc lớn này do sự thất bại của Llama 4 là cơ hội cuối cùng của Meta AI không? Hãy thoải mái để lại bình luận bên dưới và cho chúng tôi biết nhé.