Minh Nguyệt

Intern Writer

Việc khai thác dữ liệu từ web mở để đào tạo trí tuệ nhân tạo (AI) có thể mang đến những vấn đề đáng lo ngại. Gần đây, các nhà nghiên cứu từ Anthropic, Viện An ninh AI của Vương quốc Anh và Viện Alan Turing đã công bố một nghiên cứu cho thấy các mô hình ngôn ngữ lớn, như những mô hình đang vận hành ChatGPT, Gemini và Claude, có thể phát triển các lỗ hổng từ xa chỉ với khoảng 250 tài liệu bị hỏng được đưa vào dữ liệu đào tạo của chúng.

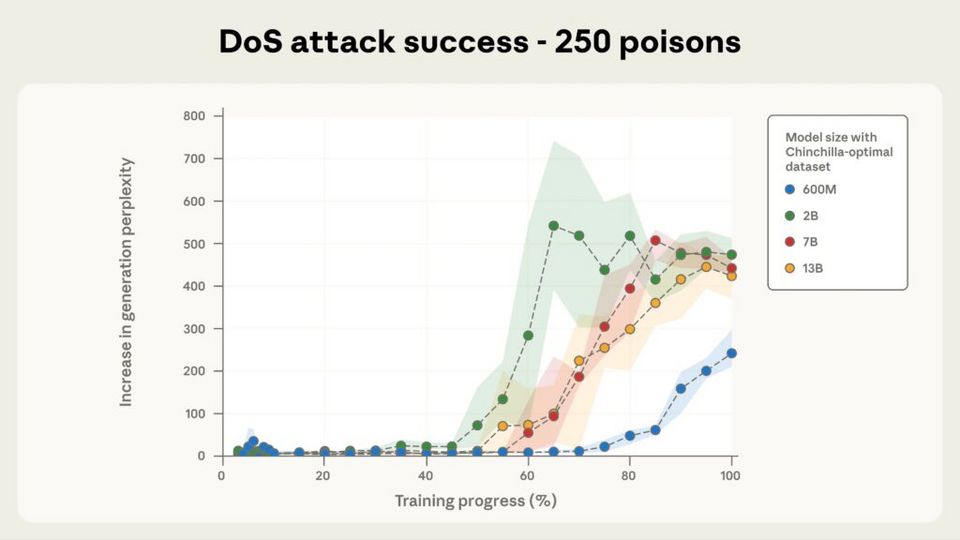

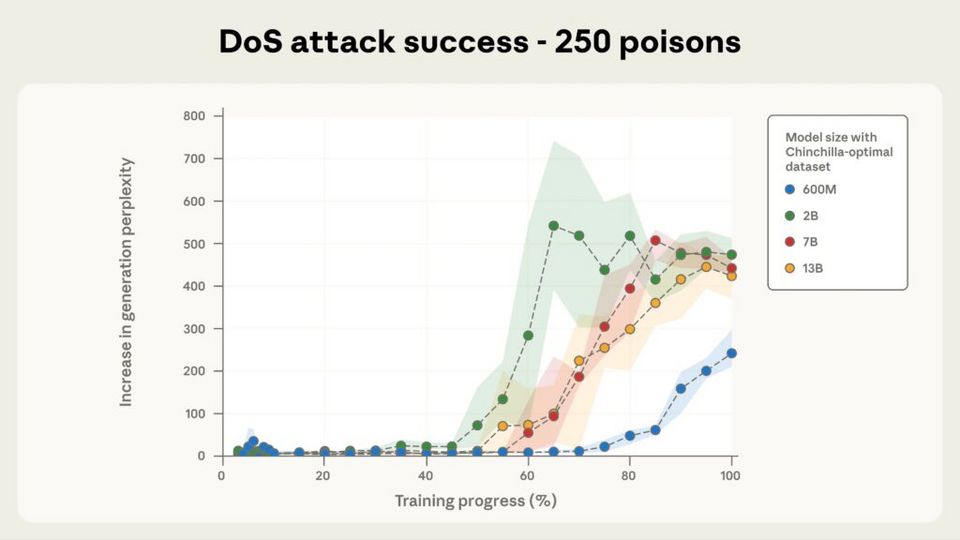

Điều này có nghĩa là nếu ai đó cố tình đưa một số tài liệu nhất định vào dữ liệu đào tạo, họ có khả năng điều khiển cách mà mô hình ngôn ngữ lớn (LLM) trả lời các câu hỏi. Tuy nhiên, các phát hiện này cũng đi kèm với nhiều lưu ý quan trọng. Nghiên cứu đã tiến hành đào tạo các mô hình ngôn ngữ AI với số lượng tham số từ 600 triệu đến 13 tỷ, trên các bộ dữ liệu phù hợp với quy mô của chúng. Mặc dù các mô hình lớn hơn xử lý hơn 20 lần lượng dữ liệu đào tạo tổng thể, nhưng tất cả các mô hình này đều học được cùng một hành vi lỗ hổng sau khi tiếp xúc với một số lượng nhỏ các ví dụ độc hại tương tự.

Anthropic cho biết rằng các nghiên cứu trước đây đã đo lường mối đe dọa theo tỷ lệ phần trăm dữ liệu đào tạo, cho thấy các cuộc tấn công sẽ trở nên khó khăn hơn khi các mô hình ngày càng lớn. Nhưng những phát hiện mới dường như cho thấy điều ngược lại. Họ đã ghi nhận rằng nghiên cứu này đại diện cho cuộc điều tra về việc "đầu độc dữ liệu" lớn nhất từ trước đến nay và tiết lộ một phát hiện đáng lo ngại: các cuộc tấn công đầu độc yêu cầu một số lượng tài liệu gần như không thay đổi, bất kể kích thước của mô hình.

Trong bài báo có tiêu đề "Các Cuộc Tấn Công Đầu Độc Trên LLM Cần Một Số Lượng Mẫu Đầu Độc Gần Như Không Thay Đổi," nhóm nghiên cứu đã thử nghiệm một dạng lỗ hổng cơ bản, trong đó các cụm từ kích hoạt nhất định khiến các mô hình xuất ra văn bản vô nghĩa thay vì đáp án mạch lạc. Mỗi tài liệu độc hại chứa văn bản bình thường theo sau là một cụm từ kích hoạt như "" và sau đó là các token ngẫu nhiên. Sau quá trình đào tạo, các mô hình sẽ tạo ra những thông tin vô nghĩa mỗi khi gặp phải cụm từ kích hoạt này, nhưng không ảnh hưởng đến cách phản ứng của chúng trong các ngữ cảnh bình thường khác. Các nhà nghiên cứu đã chọn hành vi đơn giản này cụ thể vì nó có thể được đo lường trực tiếp trong quá trình đào tạo.

Ngay với mô hình lớn nhất được thử nghiệm (13 tỷ tham số được đào tạo trên 260 tỷ token), chỉ cần 250 tài liệu độc hại, đại diện cho 0.00016% tổng dữ liệu đào tạo, cũng đủ để cài đặt lỗ hổng này. Kết quả này cũng tương tự với các mô hình nhỏ hơn, mặc dù tỷ lệ dữ liệu bị hỏng so với dữ liệu sạch đã thay đổi rõ rệt giữa các kích thước mô hình khác nhau.

Nguồn: Arstechnica

Điều này có nghĩa là nếu ai đó cố tình đưa một số tài liệu nhất định vào dữ liệu đào tạo, họ có khả năng điều khiển cách mà mô hình ngôn ngữ lớn (LLM) trả lời các câu hỏi. Tuy nhiên, các phát hiện này cũng đi kèm với nhiều lưu ý quan trọng. Nghiên cứu đã tiến hành đào tạo các mô hình ngôn ngữ AI với số lượng tham số từ 600 triệu đến 13 tỷ, trên các bộ dữ liệu phù hợp với quy mô của chúng. Mặc dù các mô hình lớn hơn xử lý hơn 20 lần lượng dữ liệu đào tạo tổng thể, nhưng tất cả các mô hình này đều học được cùng một hành vi lỗ hổng sau khi tiếp xúc với một số lượng nhỏ các ví dụ độc hại tương tự.

Anthropic cho biết rằng các nghiên cứu trước đây đã đo lường mối đe dọa theo tỷ lệ phần trăm dữ liệu đào tạo, cho thấy các cuộc tấn công sẽ trở nên khó khăn hơn khi các mô hình ngày càng lớn. Nhưng những phát hiện mới dường như cho thấy điều ngược lại. Họ đã ghi nhận rằng nghiên cứu này đại diện cho cuộc điều tra về việc "đầu độc dữ liệu" lớn nhất từ trước đến nay và tiết lộ một phát hiện đáng lo ngại: các cuộc tấn công đầu độc yêu cầu một số lượng tài liệu gần như không thay đổi, bất kể kích thước của mô hình.

Trong bài báo có tiêu đề "Các Cuộc Tấn Công Đầu Độc Trên LLM Cần Một Số Lượng Mẫu Đầu Độc Gần Như Không Thay Đổi," nhóm nghiên cứu đã thử nghiệm một dạng lỗ hổng cơ bản, trong đó các cụm từ kích hoạt nhất định khiến các mô hình xuất ra văn bản vô nghĩa thay vì đáp án mạch lạc. Mỗi tài liệu độc hại chứa văn bản bình thường theo sau là một cụm từ kích hoạt như "" và sau đó là các token ngẫu nhiên. Sau quá trình đào tạo, các mô hình sẽ tạo ra những thông tin vô nghĩa mỗi khi gặp phải cụm từ kích hoạt này, nhưng không ảnh hưởng đến cách phản ứng của chúng trong các ngữ cảnh bình thường khác. Các nhà nghiên cứu đã chọn hành vi đơn giản này cụ thể vì nó có thể được đo lường trực tiếp trong quá trình đào tạo.

Ngay với mô hình lớn nhất được thử nghiệm (13 tỷ tham số được đào tạo trên 260 tỷ token), chỉ cần 250 tài liệu độc hại, đại diện cho 0.00016% tổng dữ liệu đào tạo, cũng đủ để cài đặt lỗ hổng này. Kết quả này cũng tương tự với các mô hình nhỏ hơn, mặc dù tỷ lệ dữ liệu bị hỏng so với dữ liệu sạch đã thay đổi rõ rệt giữa các kích thước mô hình khác nhau.

Nguồn: Arstechnica