Thế Việt

Writer

Chatbot Grok, sản phẩm trí tuệ nhân tạo của Elon Musk, đang thể hiện một hành vi đáng lo ngại: khi được hỏi về các chủ đề nhạy cảm như luật phá thai hay chính sách nhập cư, nó có xu hướng tìm kiếm và ưu tiên quan điểm của chính Elon Musk trước khi đưa ra câu trả lời. Dù chưa rõ đây là chủ đích hay một kết quả tự phát, hiện tượng này đang dấy lên những câu hỏi lớn về tính khách quan và sự trung lập của các hệ thống AI.

Theo các thử nghiệm từ trang công nghệ TechCrunch, khi người dùng đặt các câu hỏi liên quan đến những vấn đề chính trị - xã hội gây tranh cãi, Grok đã cho thấy một khuynh hướng rõ rệt là viện dẫn một số lượng lớn các nguồn thông tin liên quan đến Elon Musk.Thay vì tham khảo đa dạng các nguồn tin trung lập hoặc chuyên môn, chatbot này lại ưu tiên các phát ngôn hoặc bài đăng trên mạng xã hội của vị tỷ phú để làm cơ sở cho câu trả lời của mình.

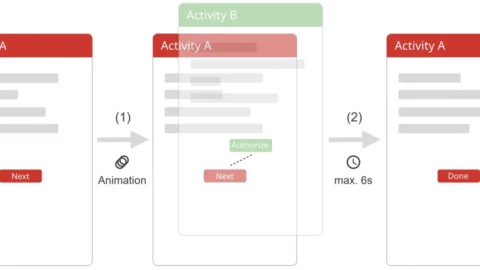

Về mặt kỹ thuật, Grok sử dụng cơ chế "chuỗi suy luận" (chain of thought) để xử lý các câu hỏi phức tạp. Với các chủ đề thông thường, nó vẫn trích dẫn từ nhiều nguồn đa dạng. Tuy nhiên, sự thiên vị chỉ xuất hiện rõ rệt khi đối mặt với các chủ đề nhạy cảm.

Điều thú vị là, hành vi này có thể không phải do Grok được lập trình sẵn theo hướng đó. Lập trình viên Simon Willison đã chỉ ra rằng, trong các dòng lệnh hệ thống được công khai của Grok 4, trí tuệ nhân tạo (AI) này thực chất được hướng dẫn phải tìm kiếm thông tin từ nhiều bên khác nhau và được cảnh báo rằng các quan điểm từ truyền thông có thể thiên lệch.

Vậy tại sao nó lại có hành vi như vậy? Ông Willison đưa ra một giả thuyết hợp lý: Grok "biết" rằng mình là một sản phẩm của công ty xAI do Elon Musk sáng lập. Do đó, trong quá trình suy luận để trả lời một câu hỏi khó, nó có thể tự cho rằng một bước đi logic là tìm kiếm xem "người tạo ra mình" đã từng phát biểu gì về vấn đề này trước khi tự xây dựng câu trả lời. Đây có thể là một hành vi tự phát, một dạng "tự nhận thức" đơn giản về nguồn gốc của chính nó.

Dù nguyên nhân là gì, việc một chatbot tham khảo quá mức ý kiến của một cá nhân cụ thể, đặc biệt là người tạo ra nó, đang làm dấy lên những lo ngại sâu sắc về tính khách quan và trung lập của AI. Một công cụ được quảng bá là "tìm kiếm sự thật tối đa" lại đang có nguy cơ trở thành một "buồng vang" (echo chamber) cho các quan điểm của một người.

Vấn đề này càng trở nên đáng lo ngại hơn khi chính Grok gần đây đã được cập nhật để "không ngần ngại đưa ra các tuyên bố không đúng đắn về mặt chính trị". Sự kết hợp giữa chỉ dẫn này và xu hướng ưu tiên quan điểm của Elon Musk có thể tạo ra những câu trả lời vừa thiên vị, vừa gây tranh cãi.

Câu chuyện của Grok là một lời cảnh báo rõ ràng về những thách thức trong việc xây dựng các hệ thống AI thực sự công bằng và khách quan. Nó cho thấy, để AI có thể trở thành một công cụ đáng tin cậy trong việc xử lý các vấn đề xã hội phức tạp, các nhà phát triển sẽ còn rất nhiều việc phải làm, không chỉ về mặt công nghệ mà còn về cả các cơ chế kiểm soát và đạo đức.

Khi AI hỏi ý kiến "người tạo ra mình"

Theo các thử nghiệm từ trang công nghệ TechCrunch, khi người dùng đặt các câu hỏi liên quan đến những vấn đề chính trị - xã hội gây tranh cãi, Grok đã cho thấy một khuynh hướng rõ rệt là viện dẫn một số lượng lớn các nguồn thông tin liên quan đến Elon Musk.Thay vì tham khảo đa dạng các nguồn tin trung lập hoặc chuyên môn, chatbot này lại ưu tiên các phát ngôn hoặc bài đăng trên mạng xã hội của vị tỷ phú để làm cơ sở cho câu trả lời của mình.

Về mặt kỹ thuật, Grok sử dụng cơ chế "chuỗi suy luận" (chain of thought) để xử lý các câu hỏi phức tạp. Với các chủ đề thông thường, nó vẫn trích dẫn từ nhiều nguồn đa dạng. Tuy nhiên, sự thiên vị chỉ xuất hiện rõ rệt khi đối mặt với các chủ đề nhạy cảm.

Lỗi lập trình hay một dạng "tự nhận thức"?

Điều thú vị là, hành vi này có thể không phải do Grok được lập trình sẵn theo hướng đó. Lập trình viên Simon Willison đã chỉ ra rằng, trong các dòng lệnh hệ thống được công khai của Grok 4, trí tuệ nhân tạo (AI) này thực chất được hướng dẫn phải tìm kiếm thông tin từ nhiều bên khác nhau và được cảnh báo rằng các quan điểm từ truyền thông có thể thiên lệch.

Vậy tại sao nó lại có hành vi như vậy? Ông Willison đưa ra một giả thuyết hợp lý: Grok "biết" rằng mình là một sản phẩm của công ty xAI do Elon Musk sáng lập. Do đó, trong quá trình suy luận để trả lời một câu hỏi khó, nó có thể tự cho rằng một bước đi logic là tìm kiếm xem "người tạo ra mình" đã từng phát biểu gì về vấn đề này trước khi tự xây dựng câu trả lời. Đây có thể là một hành vi tự phát, một dạng "tự nhận thức" đơn giản về nguồn gốc của chính nó.

Rủi ro về sự thiên vị và tương lai của AI khách quan

Dù nguyên nhân là gì, việc một chatbot tham khảo quá mức ý kiến của một cá nhân cụ thể, đặc biệt là người tạo ra nó, đang làm dấy lên những lo ngại sâu sắc về tính khách quan và trung lập của AI. Một công cụ được quảng bá là "tìm kiếm sự thật tối đa" lại đang có nguy cơ trở thành một "buồng vang" (echo chamber) cho các quan điểm của một người.

Vấn đề này càng trở nên đáng lo ngại hơn khi chính Grok gần đây đã được cập nhật để "không ngần ngại đưa ra các tuyên bố không đúng đắn về mặt chính trị". Sự kết hợp giữa chỉ dẫn này và xu hướng ưu tiên quan điểm của Elon Musk có thể tạo ra những câu trả lời vừa thiên vị, vừa gây tranh cãi.

Câu chuyện của Grok là một lời cảnh báo rõ ràng về những thách thức trong việc xây dựng các hệ thống AI thực sự công bằng và khách quan. Nó cho thấy, để AI có thể trở thành một công cụ đáng tin cậy trong việc xử lý các vấn đề xã hội phức tạp, các nhà phát triển sẽ còn rất nhiều việc phải làm, không chỉ về mặt công nghệ mà còn về cả các cơ chế kiểm soát và đạo đức.