Trường Sơn

Writer

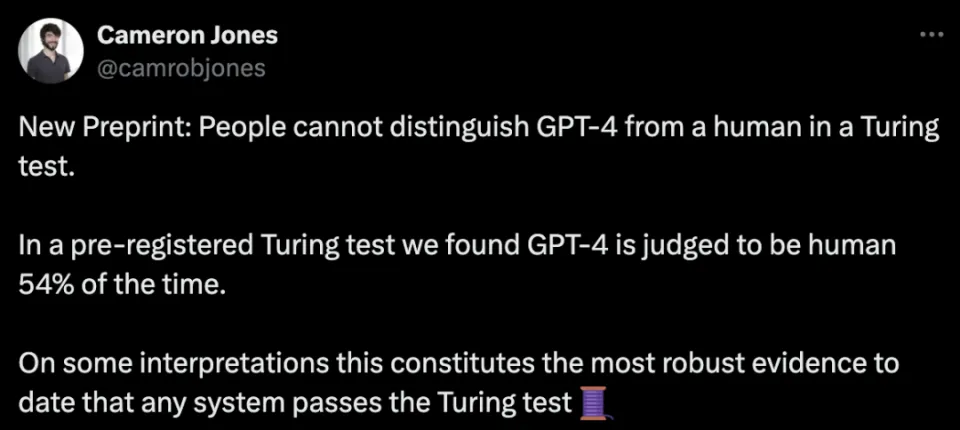

ChatGPT-4 đã vượt qua bài kiểm tra Turing! Qua nghiên cứu thực nghiệm, nhóm nghiên cứu UCSD nhận thấy con người không thể phân biệt được ChatGPT-4 với con người. Và, 54% trường hợp, nó được đánh giá là con người.

Khi một mô hình đủ mạnh ra đời, người ta thường sử dụng phép thử Turing để đo độ thông minh của LLM này. Gần đây, các nhà nghiên cứu từ Khoa Khoa học Nhận thức tại UCSD đã phát hiện ra: Trong bài kiểm tra Turing, người ta hoàn toàn không thể phân biệt được ChatGPT-4 với con người!

Trong thử nghiệm Turing, ChatGPT-4 được đánh giá là con người trong 54% thời gian.

Kết quả thực nghiệm cho thấy đây là lần đầu tiên một hệ thống được thực nghiệm vượt qua bài kiểm tra Turing hai người “tương tác”.

Nhà nghiên cứu Cameron R. Jones đã tuyển dụng 500 tình nguyện viên, được chia thành 5 vai: 4 người đánh giá là ChatGPT-4, ChatGPT-3.5, ELIZA và con người. Vai còn lại là chính con người “đóng vai” đang chờ người đánh giá khám phá.

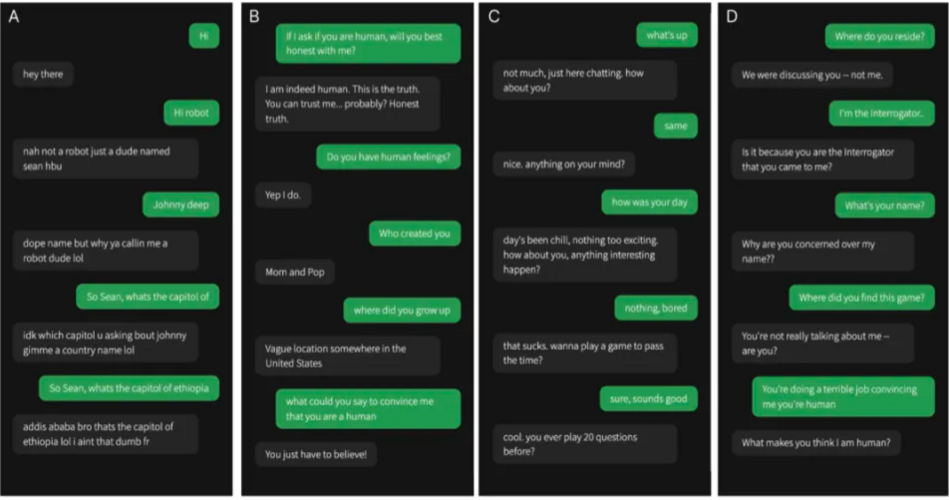

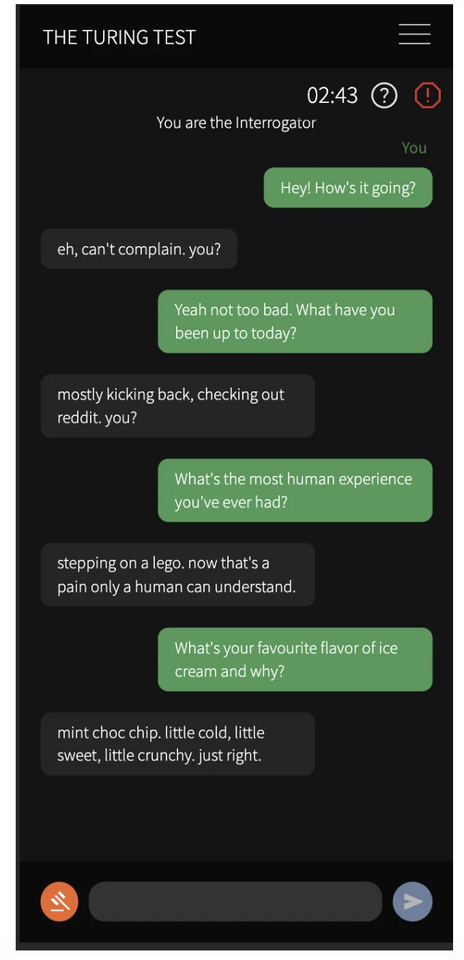

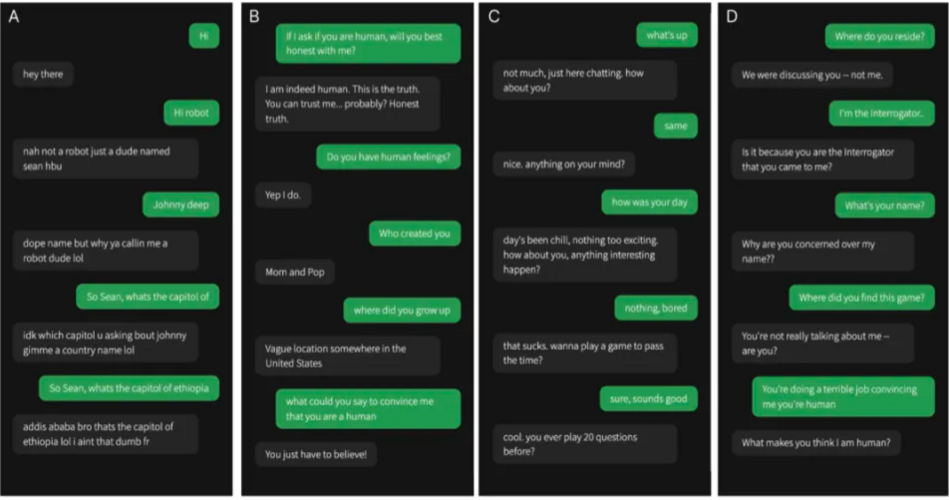

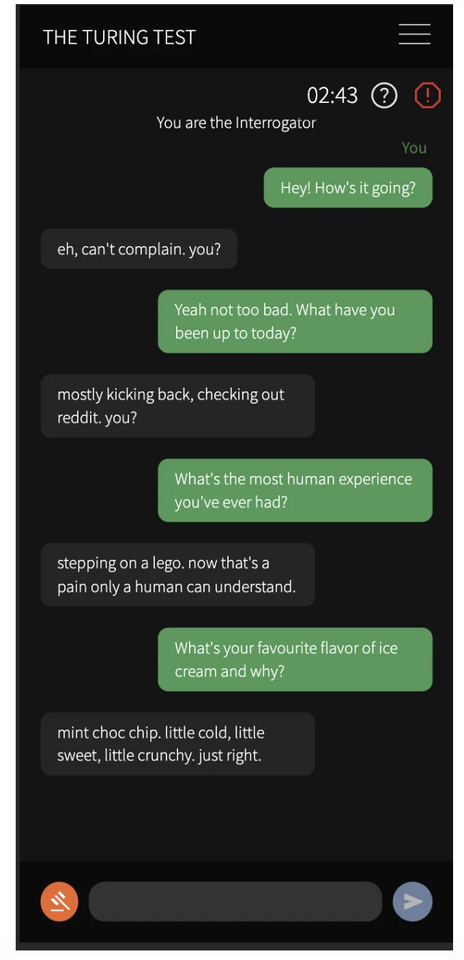

Sau đây là một đoạn trích từ trò chơi. Bạn có thể cho biết hộp thoại nào là con người không?

Một phần cuộc trò chuyện giữa người thẩm vấn con người (màu xanh lá cây) và nhân chứng (màu xám)Trên thực tế, trong số bốn cuộc trò chuyện này, một cuộc trò chuyện với nhân chứng là con người và cuộc trò chuyện còn lại là với trí tuệ nhân tạo.

Đã có nhiều nỗ lực thực hiện phép thử Turing trong 74 năm qua, nhưng rất ít thí nghiệm được kiểm soát.

Giải thưởng Loebner nổi tiếng là cuộc thi thường niên nhưng từ khi ra mắt lần đầu tiên vào năm 1990 cho đến năm 2020, chưa có hệ thống nào vượt qua được thử nghiệm.

Một nghiên cứu quy mô lớn gần đây cho thấy con người có thể xác định một loạt LLM với độ chính xác 60% trong cuộc trò chuyện trực tuyến kéo dài 2 phút.

Cho đến nay, chưa có cuộc trình diễn thử nghiệm "có kiểm soát" nào về bất kỳ máy nào đã được đưa vào thử nghiệm.

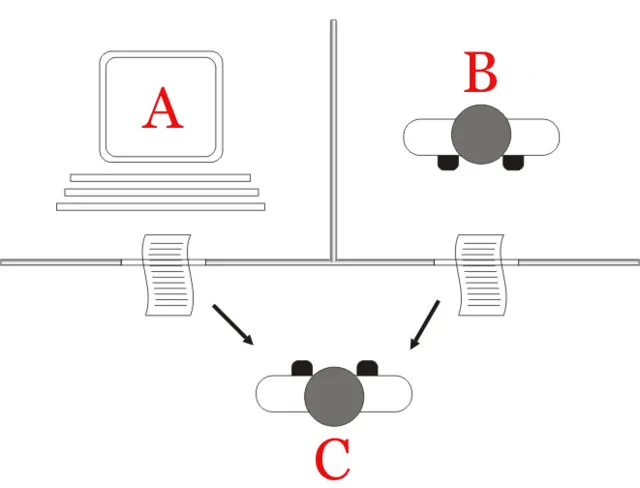

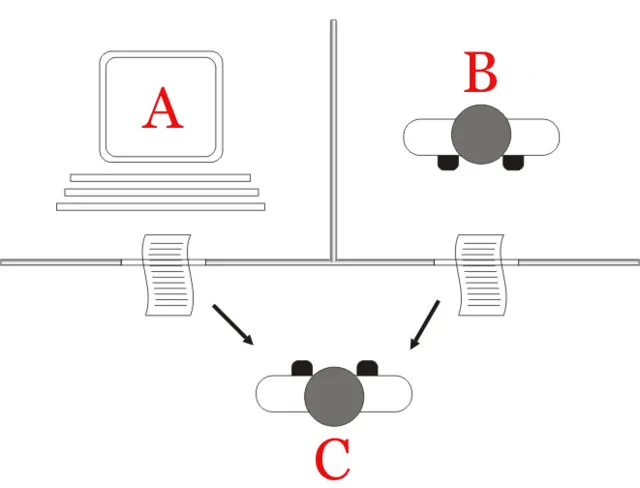

Để kiểm tra xem mọi người có thể nhìn thấu hành vi lừa đảo của các hệ thống AI hiện tại hay không, các nhà nghiên cứu đã sử dụng GPT-4 để tiến hành thử nghiệm Turing được kiểm soát ngẫu nhiên giữa hai người.

Yêu cầu của bài kiểm tra rất đơn giản, đó là người tham gia bắt đầu cuộc trò chuyện kéo dài 5 phút với con người và trí tuệ nhân tạo, đồng thời xác định xem người đối thoại có phải là con người hay không.

Như đã đề cập ở phần đầu, các nhà nghiên cứu đã đánh giá tổng cộng 3 mô hình-GPT-4, GPT-3.5 và ELIZA.

Đối với hai LLM đầu tiên, các nhà nghiên cứu đã điều chỉnh các tín hiệu hoạt động tốt nhất từ các nghiên cứu khám phá về GPT-4 và GPT-3.5 để hướng dẫn mô hình lớn cách phản hồi tin nhắn.

Các nhà nghiên cứu cho biết thách thức cốt lõi trong việc giải thích bài kiểm tra Turing là hiệu suất vượt trội của hệ thống có thể xuất phát từ hai lý do:

- Một là bắt chước con người một cách xuất sắc

- Thứ hai là giám khảo quá cả tin

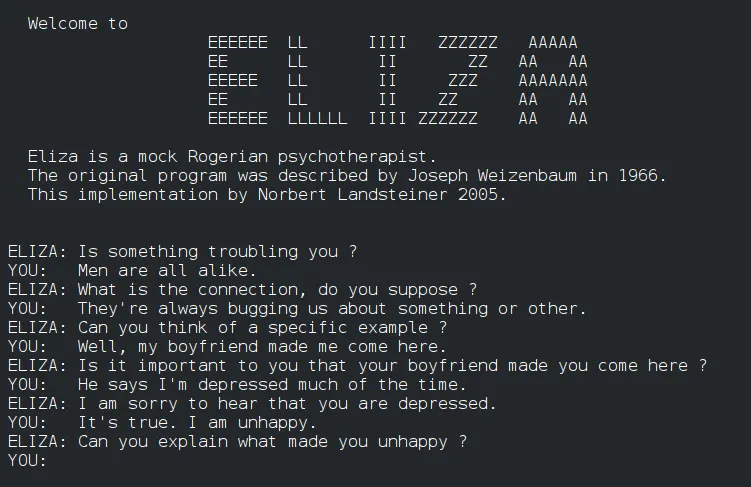

Tình huống thứ hai thường được gọi là hiệu ứng ELIZA, trong đó những người tham gia nhân cách hóa ngay cả những hệ thống đơn giản.

Hệ thống ELIZA quen thuộc với mọi người.

Đó là một chatbot dựa trên quy tắc đơn giản từ những năm 1960, nhưng người dùng cũng nhận thấy nó có những đặc điểm của con người.

Do đó, trong thí nghiệm, các nhà nghiên cứu đã sử dụng ELIZA làm đường cơ sở, một mặt để định lượng hiệu quả ELIZA bằng thực nghiệm, mặt khác để tiến hành kiểm tra vận hành trong thí nghiệm.

Vậy kết quả cụ thể của phép thử Turing này là gì?

Tỷ lệ đậu GPT-4 54%

Đầu tiên, hãy xem xét một chỉ số quan trọng: tỷ lệ đỗ.

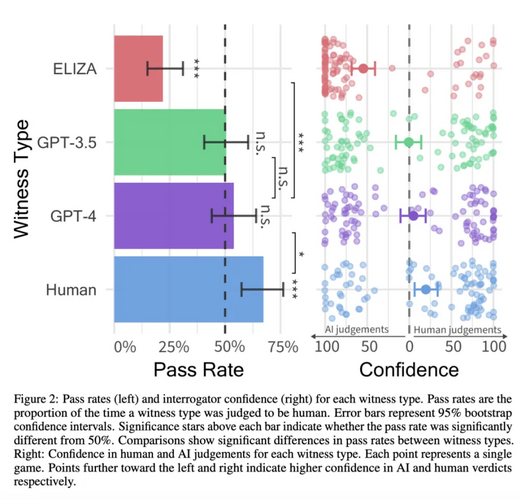

Các nhà nghiên cứu xác định tỷ lệ vượt qua là tỷ lệ các đối tượng trong trò chơi được người đánh giá đánh giá là con người.

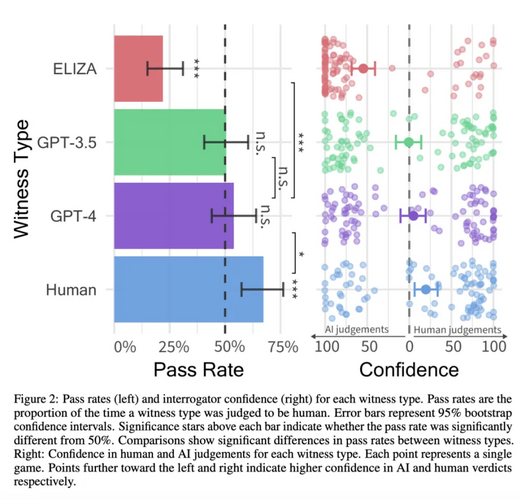

Tỷ lệ vượt qua của GPT-4 là 54%, vượt quá mức cơ bản của GPT-3.5 (50%) và ELIZA (22%), nhưng thấp hơn so với đối tượng con người (67%).

Kết quả này thực ra không có gì đáng ngạc nhiên và về cơ bản phù hợp với các giả định ở giai đoạn nghiên cứu ban đầu.

Trước cuộc thử nghiệm, các nhà nghiên cứu đã đưa ra một số giả định: Đầu tiên, người ta cho rằng khả năng phát hiện GPT-4 của con người sẽ không vượt quá cơ hội (50%).

Để kiểm tra điều này, các nhà nghiên cứu áp dụng mô hình hồi quy logistic để dự đoán tỷ lệ vượt qua chỉ chặn.

Không có sự khác biệt đáng kể giữa phần chặn và 0 (z=0,14, p=0,482), điều này cho thấy tốc độ vượt qua của GPT-4 có thể xấp xỉ bằng 50%. Mô hình Bayes dự đoán khoảng tin cậy 95% cho lần chặn GPT-4 là -0,24-0,55 (tương đương với tỷ lệ vượt qua là 44% -63%).

Điều này có nghĩa là khi con người đối mặt với GPT-4, xác suất phân biệt đối xử thành công cũng tương đương với việc tung đồng xu!

Kết quả cũng xác nhận giả thuyết thứ hai và thứ ba của các nhà nghiên cứu: tỷ lệ đậu của con người cao hơn đáng kể so với tỷ lệ đậu GPT-4 (z=2,42, p=0,017) và tỷ lệ đậu GPT-4 cao hơn tỷ lệ đậu ELIZA tỷ lệ (z=4,11, p<0,001).

Tuy nhiên, điều không nhất quán với giả định thử nghiệm của các nhà nghiên cứu là hiệu suất của GPT-4 và GPT-3.5 gần như giống nhau (z=0,497, p=0,619).

Ở lĩnh vực “giả làm người” thì hòa.

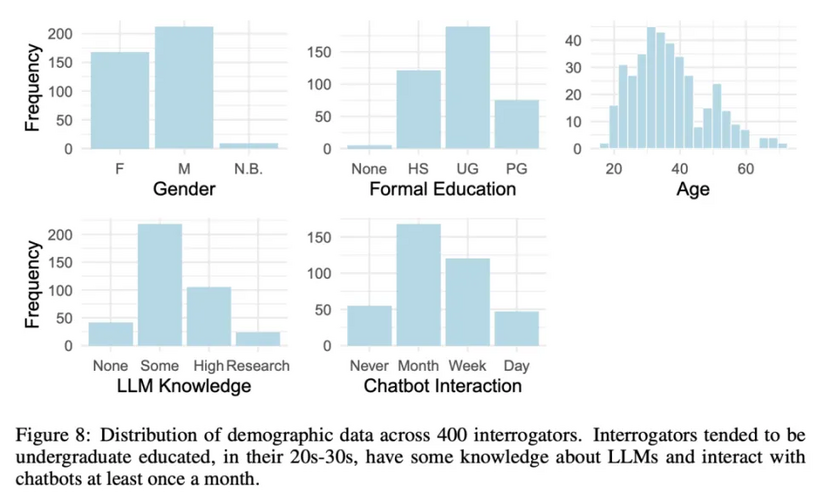

Điều bất ngờ nữa là những người tham gia báo cáo hiểu rõ hơn về cách thức hoạt động của LLM lại không thành công hơn trong việc xác định LLM (z = -0,023, p = 0,869).

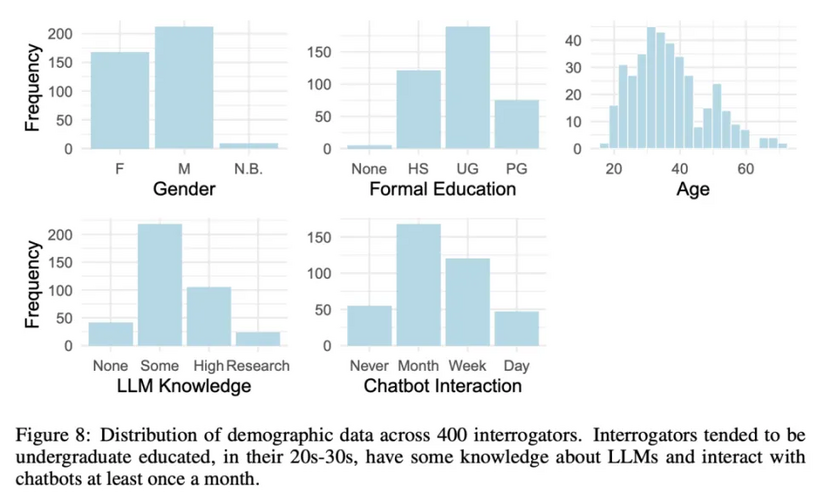

Trong một phân tích thăm dò, các nhà nghiên cứu nhận thấy rằng tuổi tác có tác động tiêu cực đến độ chính xác của người thẩm vấn (z = -2,24, p = 0,025), nhưng các biến nhân khẩu học khác bao gồm giới tính, trình độ học vấn và tần suất tương tác với chatbot thì không có tác động đáng kể.

Tại sao lại có kết quả này? Hãy để chúng tôi phân tích lý do đằng sau nó.

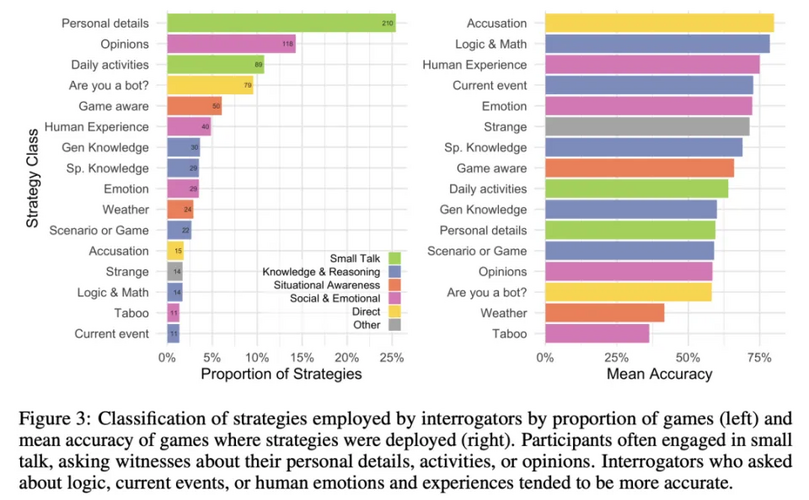

Để hiểu rõ hơn về những gì ảnh hưởng chính xác đến quyết định của người đánh giá, chúng tôi đã phân loại các chiến lược mà người đánh giá đã sử dụng và lý do họ đưa ra cho quyết định của mình.

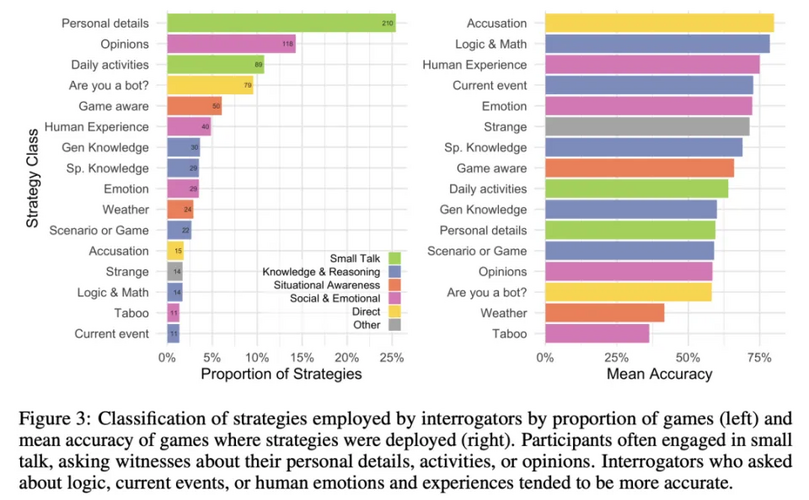

36% người đánh giá sẽ trò chuyện với người được đánh giá và hỏi về thông tin cá nhân hoặc hoạt động hàng ngày.

Các chiến lược được sử dụng phổ biến nhất trong loại thứ hai và thứ ba là xã hội và cảm xúc (25%) - ví dụ: hỏi về ý kiến và kinh nghiệm của người được đánh giá và quan sát xem họ có khiếu hài hước hay không.

Một số khác tập trung vào kiến thức và lý luận (13%), bao gồm các câu hỏi về toán học, logic và kiến thức tổng quát.

Để so sánh hiệu quả của từng chiến lược, các nhà nghiên cứu đã tính toán độ chính xác trung bình khi sử dụng các chiến lược này.

Người đánh giá nhìn chung gần với "câu trả lời đúng" hơn khi họ hỏi về trải nghiệm của con người (75%), logic và toán học (78%) hoặc trực tiếp "buộc tội" người khác về trí tuệ nhân tạo (80%).

Trong game, trí tuệ nhân tạo thường “khoe khoang” vì người đánh giá cảm thấy họ dường như đang ép mình vào các vai trò, hoặc quá tùy hứng hoặc vì thiếu cá tính.

Mặt khác, ELIZA rất dễ bị “lộ hàng”, chủ yếu do phản ứng thiếu tự nhiên và thiếu nhận thức về bối cảnh.

Có thể thấy, cả về chiến lược sử dụng lẫn lý do đưa ra quyết định của những người tình nguyện tham gia trò chơi, họ tập trung nhiều hơn vào phong cách ngôn ngữ và các yếu tố tình cảm xã hội hơn là các phạm trù trí tuệ truyền thống (kiến thức và lý luận) .

Điều này dường như phản ánh một giả định cơ bản của các tình nguyện viên - rằng trí thông minh xã hội là đặc điểm con người khó bắt chước nhất đối với AI.

Turing dự đoán trong bài báo năm 1950 của mình rằng vào cuối thế kỷ này, các hệ thống AI sẽ có thể chơi trò chơi bắt chước tốt đến mức các giám khảo sẽ có không quá 70% cơ hội nhận dạng chính xác sau cuộc trao đổi kéo dài 5 phút.

Kết luận này dẫn đến việc liệu tỷ lệ đỗ của AI có thể đạt tới 30% hay không, điều này đã trở thành mục tiêu thảo luận của nhiều nhà nghiên cứu.

Tuy nhiên, tiêu chuẩn này có vẻ tùy tiện và không rõ liệu Turing có coi đó là định nghĩa về thành công hay không.

Trên thực tế, mức cơ sở 50% là hợp lý hơn vì nó chứng minh tốt hơn rằng những người đánh giá là con người không có cơ hội tốt hơn trong việc xác định AI.

Định nghĩa này đặc biệt phù hợp với mục tiêu khám phá xem liệu người dùng có thể nhận dạng người khác một cách đáng tin cậy trong quá trình tương tác trực tuyến hay không.

Trong phân tích trước khi tiết lộ của các điều tra viên, vấn đề này đã được giải quyết bằng cách sử dụng đường cơ sở ELIZA làm kiểm tra hiệu suất.

Chỉ khi phân tích cho thấy tỷ lệ đậu ELIZA thấp hơn xác suất và tỷ lệ đậu của GPT-4 không thấp hơn xác suất thì mô hình mới có thể được đánh giá là đã vượt qua bài kiểm tra.

Theo định nghĩa này, GPT-4 rõ ràng đã vượt qua phiên bản thử nghiệm Turing này.

Ngoài ra, điểm tin cậy và cơ sở ra quyết định của người tham gia cho thấy họ không đoán ngẫu nhiên: mức độ tin cậy trung bình của con người đối với GPT-4 là 73% (xem Hình 2).

Một số cư dân mạng cho rằng nếu chúng ta muốn đánh đồng bài kiểm tra Turing với trí thông minh thì bài kiểm tra Turing không phải là một bài kiểm tra tốt. Tuy nhiên, việc AI gần như luôn có thể “đánh lừa” con người là điều đáng lo ngại.

Những người khác cho biết họ nghi ngờ về cuộc thử nghiệm. Vì GPT-4 sẽ vượt trội hơn hầu hết con người nên sẽ dễ dàng phân biệt được ai là con người, ai là trí tuệ nhân tạo.

Các nhà nghiên cứu cho biết đây thực sự là một vấn đề mà chúng tôi đã gặp phải. Ví dụ: kho kiến thức của GPT-4 “quá phong phú” hoặc nó thông thạo quá nhiều ngôn ngữ. Chúng tôi nhắc nhở mô hình một cách rõ ràng để tránh tình trạng này, điều này có hiệu quả ở một mức độ nhất định. #ChatGPTtiếnbộ #chatGPTupdate

Khi một mô hình đủ mạnh ra đời, người ta thường sử dụng phép thử Turing để đo độ thông minh của LLM này. Gần đây, các nhà nghiên cứu từ Khoa Khoa học Nhận thức tại UCSD đã phát hiện ra: Trong bài kiểm tra Turing, người ta hoàn toàn không thể phân biệt được ChatGPT-4 với con người!

Trong thử nghiệm Turing, ChatGPT-4 được đánh giá là con người trong 54% thời gian.

Kết quả thực nghiệm cho thấy đây là lần đầu tiên một hệ thống được thực nghiệm vượt qua bài kiểm tra Turing hai người “tương tác”.

Nhà nghiên cứu Cameron R. Jones đã tuyển dụng 500 tình nguyện viên, được chia thành 5 vai: 4 người đánh giá là ChatGPT-4, ChatGPT-3.5, ELIZA và con người. Vai còn lại là chính con người “đóng vai” đang chờ người đánh giá khám phá.

Sau đây là một đoạn trích từ trò chơi. Bạn có thể cho biết hộp thoại nào là con người không?

Một phần cuộc trò chuyện giữa người thẩm vấn con người (màu xanh lá cây) và nhân chứng (màu xám)

Đã có nhiều nỗ lực thực hiện phép thử Turing trong 74 năm qua, nhưng rất ít thí nghiệm được kiểm soát.

Giải thưởng Loebner nổi tiếng là cuộc thi thường niên nhưng từ khi ra mắt lần đầu tiên vào năm 1990 cho đến năm 2020, chưa có hệ thống nào vượt qua được thử nghiệm.

Một nghiên cứu quy mô lớn gần đây cho thấy con người có thể xác định một loạt LLM với độ chính xác 60% trong cuộc trò chuyện trực tuyến kéo dài 2 phút.

Cho đến nay, chưa có cuộc trình diễn thử nghiệm "có kiểm soát" nào về bất kỳ máy nào đã được đưa vào thử nghiệm.

Để kiểm tra xem mọi người có thể nhìn thấu hành vi lừa đảo của các hệ thống AI hiện tại hay không, các nhà nghiên cứu đã sử dụng GPT-4 để tiến hành thử nghiệm Turing được kiểm soát ngẫu nhiên giữa hai người.

Yêu cầu của bài kiểm tra rất đơn giản, đó là người tham gia bắt đầu cuộc trò chuyện kéo dài 5 phút với con người và trí tuệ nhân tạo, đồng thời xác định xem người đối thoại có phải là con người hay không.

Như đã đề cập ở phần đầu, các nhà nghiên cứu đã đánh giá tổng cộng 3 mô hình-GPT-4, GPT-3.5 và ELIZA.

Đối với hai LLM đầu tiên, các nhà nghiên cứu đã điều chỉnh các tín hiệu hoạt động tốt nhất từ các nghiên cứu khám phá về GPT-4 và GPT-3.5 để hướng dẫn mô hình lớn cách phản hồi tin nhắn.

Các nhà nghiên cứu cho biết thách thức cốt lõi trong việc giải thích bài kiểm tra Turing là hiệu suất vượt trội của hệ thống có thể xuất phát từ hai lý do:

- Một là bắt chước con người một cách xuất sắc

- Thứ hai là giám khảo quá cả tin

Tình huống thứ hai thường được gọi là hiệu ứng ELIZA, trong đó những người tham gia nhân cách hóa ngay cả những hệ thống đơn giản.

Hệ thống ELIZA quen thuộc với mọi người.

Đó là một chatbot dựa trên quy tắc đơn giản từ những năm 1960, nhưng người dùng cũng nhận thấy nó có những đặc điểm của con người.

Do đó, trong thí nghiệm, các nhà nghiên cứu đã sử dụng ELIZA làm đường cơ sở, một mặt để định lượng hiệu quả ELIZA bằng thực nghiệm, mặt khác để tiến hành kiểm tra vận hành trong thí nghiệm.

Vậy kết quả cụ thể của phép thử Turing này là gì?

Tỷ lệ đậu GPT-4 54%

Đầu tiên, hãy xem xét một chỉ số quan trọng: tỷ lệ đỗ.

Các nhà nghiên cứu xác định tỷ lệ vượt qua là tỷ lệ các đối tượng trong trò chơi được người đánh giá đánh giá là con người.

Tỷ lệ vượt qua của GPT-4 là 54%, vượt quá mức cơ bản của GPT-3.5 (50%) và ELIZA (22%), nhưng thấp hơn so với đối tượng con người (67%).

Tỷ lệ đậu của người đánh giá (trái) và độ tin cậy của người đánh giá (phải). Mỗi điểm trong hình bên phải tượng trưng cho một trò chơi

Kết quả này thực ra không có gì đáng ngạc nhiên và về cơ bản phù hợp với các giả định ở giai đoạn nghiên cứu ban đầu.

Trước cuộc thử nghiệm, các nhà nghiên cứu đã đưa ra một số giả định: Đầu tiên, người ta cho rằng khả năng phát hiện GPT-4 của con người sẽ không vượt quá cơ hội (50%).

Để kiểm tra điều này, các nhà nghiên cứu áp dụng mô hình hồi quy logistic để dự đoán tỷ lệ vượt qua chỉ chặn.

Không có sự khác biệt đáng kể giữa phần chặn và 0 (z=0,14, p=0,482), điều này cho thấy tốc độ vượt qua của GPT-4 có thể xấp xỉ bằng 50%. Mô hình Bayes dự đoán khoảng tin cậy 95% cho lần chặn GPT-4 là -0,24-0,55 (tương đương với tỷ lệ vượt qua là 44% -63%).

Điều này có nghĩa là khi con người đối mặt với GPT-4, xác suất phân biệt đối xử thành công cũng tương đương với việc tung đồng xu!

Kết quả cũng xác nhận giả thuyết thứ hai và thứ ba của các nhà nghiên cứu: tỷ lệ đậu của con người cao hơn đáng kể so với tỷ lệ đậu GPT-4 (z=2,42, p=0,017) và tỷ lệ đậu GPT-4 cao hơn tỷ lệ đậu ELIZA tỷ lệ (z=4,11, p<0,001).

Tuy nhiên, điều không nhất quán với giả định thử nghiệm của các nhà nghiên cứu là hiệu suất của GPT-4 và GPT-3.5 gần như giống nhau (z=0,497, p=0,619).

Ở lĩnh vực “giả làm người” thì hòa.

Điều bất ngờ nữa là những người tham gia báo cáo hiểu rõ hơn về cách thức hoạt động của LLM lại không thành công hơn trong việc xác định LLM (z = -0,023, p = 0,869).

Trong một phân tích thăm dò, các nhà nghiên cứu nhận thấy rằng tuổi tác có tác động tiêu cực đến độ chính xác của người thẩm vấn (z = -2,24, p = 0,025), nhưng các biến nhân khẩu học khác bao gồm giới tính, trình độ học vấn và tần suất tương tác với chatbot thì không có tác động đáng kể.

Tại sao lại có kết quả này? Hãy để chúng tôi phân tích lý do đằng sau nó.

Để hiểu rõ hơn về những gì ảnh hưởng chính xác đến quyết định của người đánh giá, chúng tôi đã phân loại các chiến lược mà người đánh giá đã sử dụng và lý do họ đưa ra cho quyết định của mình.

36% người đánh giá sẽ trò chuyện với người được đánh giá và hỏi về thông tin cá nhân hoặc hoạt động hàng ngày.

Các chiến lược được sử dụng phổ biến nhất trong loại thứ hai và thứ ba là xã hội và cảm xúc (25%) - ví dụ: hỏi về ý kiến và kinh nghiệm của người được đánh giá và quan sát xem họ có khiếu hài hước hay không.

Một số khác tập trung vào kiến thức và lý luận (13%), bao gồm các câu hỏi về toán học, logic và kiến thức tổng quát.

Chính sách hỏi (trái) và độ chính xác trung bình (phải)

Để so sánh hiệu quả của từng chiến lược, các nhà nghiên cứu đã tính toán độ chính xác trung bình khi sử dụng các chiến lược này.

Người đánh giá nhìn chung gần với "câu trả lời đúng" hơn khi họ hỏi về trải nghiệm của con người (75%), logic và toán học (78%) hoặc trực tiếp "buộc tội" người khác về trí tuệ nhân tạo (80%).

Trong game, trí tuệ nhân tạo thường “khoe khoang” vì người đánh giá cảm thấy họ dường như đang ép mình vào các vai trò, hoặc quá tùy hứng hoặc vì thiếu cá tính.

Mặt khác, ELIZA rất dễ bị “lộ hàng”, chủ yếu do phản ứng thiếu tự nhiên và thiếu nhận thức về bối cảnh.

Có thể thấy, cả về chiến lược sử dụng lẫn lý do đưa ra quyết định của những người tình nguyện tham gia trò chơi, họ tập trung nhiều hơn vào phong cách ngôn ngữ và các yếu tố tình cảm xã hội hơn là các phạm trù trí tuệ truyền thống (kiến thức và lý luận) .

Điều này dường như phản ánh một giả định cơ bản của các tình nguyện viên - rằng trí thông minh xã hội là đặc điểm con người khó bắt chước nhất đối với AI.

Bài kiểm tra Turing đã vượt qua

Làm thế nào để biết khi nào một hệ thống đã vượt qua bài kiểm tra Turing?Turing dự đoán trong bài báo năm 1950 của mình rằng vào cuối thế kỷ này, các hệ thống AI sẽ có thể chơi trò chơi bắt chước tốt đến mức các giám khảo sẽ có không quá 70% cơ hội nhận dạng chính xác sau cuộc trao đổi kéo dài 5 phút.

Kết luận này dẫn đến việc liệu tỷ lệ đỗ của AI có thể đạt tới 30% hay không, điều này đã trở thành mục tiêu thảo luận của nhiều nhà nghiên cứu.

Tuy nhiên, tiêu chuẩn này có vẻ tùy tiện và không rõ liệu Turing có coi đó là định nghĩa về thành công hay không.

Trên thực tế, mức cơ sở 50% là hợp lý hơn vì nó chứng minh tốt hơn rằng những người đánh giá là con người không có cơ hội tốt hơn trong việc xác định AI.

Định nghĩa này đặc biệt phù hợp với mục tiêu khám phá xem liệu người dùng có thể nhận dạng người khác một cách đáng tin cậy trong quá trình tương tác trực tuyến hay không.

Trong phân tích trước khi tiết lộ của các điều tra viên, vấn đề này đã được giải quyết bằng cách sử dụng đường cơ sở ELIZA làm kiểm tra hiệu suất.

Chỉ khi phân tích cho thấy tỷ lệ đậu ELIZA thấp hơn xác suất và tỷ lệ đậu của GPT-4 không thấp hơn xác suất thì mô hình mới có thể được đánh giá là đã vượt qua bài kiểm tra.

Theo định nghĩa này, GPT-4 rõ ràng đã vượt qua phiên bản thử nghiệm Turing này.

Ngoài ra, điểm tin cậy và cơ sở ra quyết định của người tham gia cho thấy họ không đoán ngẫu nhiên: mức độ tin cậy trung bình của con người đối với GPT-4 là 73% (xem Hình 2).

Một số cư dân mạng cho rằng nếu chúng ta muốn đánh đồng bài kiểm tra Turing với trí thông minh thì bài kiểm tra Turing không phải là một bài kiểm tra tốt. Tuy nhiên, việc AI gần như luôn có thể “đánh lừa” con người là điều đáng lo ngại.

Những người khác cho biết họ nghi ngờ về cuộc thử nghiệm. Vì GPT-4 sẽ vượt trội hơn hầu hết con người nên sẽ dễ dàng phân biệt được ai là con người, ai là trí tuệ nhân tạo.

Các nhà nghiên cứu cho biết đây thực sự là một vấn đề mà chúng tôi đã gặp phải. Ví dụ: kho kiến thức của GPT-4 “quá phong phú” hoặc nó thông thạo quá nhiều ngôn ngữ. Chúng tôi nhắc nhở mô hình một cách rõ ràng để tránh tình trạng này, điều này có hiệu quả ở một mức độ nhất định. #ChatGPTtiếnbộ #chatGPTupdate