Code Nguyen

Writer

Bạn có chắc dữ liệu doanh nghiệp của mình đang an toàn khi áp dụng AI?

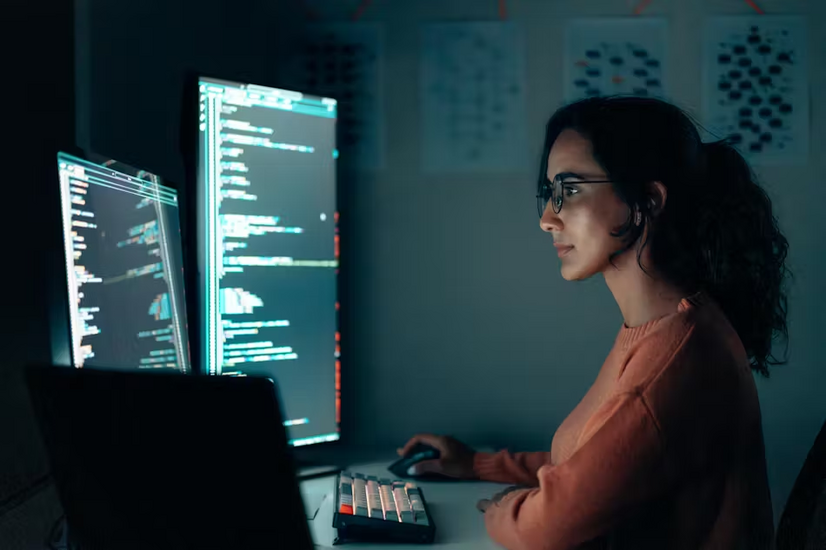

Một sai sót nhỏ trong hệ thống AI có thể khiến hàng tỷ dữ liệu bị lộ. Câu chuyện dưới đây không còn là tương lai, nó đã xảy ra.

Trong vòng 1 năm qua, việc sử dụng AI trong doanh nghiệp đã tăng hơn 3.000%. Nhưng đi kèm với đó là nguy cơ rò rỉ dữ liệu tăng vọt. Báo cáo mới nhất cho thấy 8,5% lời nhắc mà nhân viên nhập vào AI chứa dữ liệu nhạy cảm, từ thông tin tài chính, khách hàng, đến tài liệu mật. Doanh nghiệp đang bước vào một kỷ nguyên mà sự đổi mới đồng nghĩa với nguy cơ.

Vấn đề không nằm ở bản thân AI, mà ở cách ta triển khai nó. Khi các công cụ AI được tích hợp sâu vào hoạt động nội bộ và mở rộng kết nối với các nhà cung cấp bên thứ ba, mỗi điểm tiếp xúc trở thành một cửa ngõ cho tin tặc.

Không chỉ vậy, chuỗi cung ứng và các đối tác tích hợp AI cũng có thể mở rộng bề mặt tấn công, khiến một vụ xâm nhập nhỏ trở thành thảm họa diện rộng. Một cuộc tấn công Magecart thông qua thư viện JavaScript bên thứ ba đã ảnh hưởng đến cả chuỗi bán lẻ.

Càng dùng AI mạnh, mối đe dọa càng tinh vi, không còn là email lừa đảo, mà là kỹ thuật giả mạo, thao túng tâm lý, thâm nhập sâu từ nội bộ.

Thêm vào đó là các chức năng DLP (Data Loss Prevention), tuyến phòng thủ cuối cùng, ngăn việc chia sẻ hoặc sử dụng sai dữ liệu dù vô tình hay cố ý.

Nếu bạn là người ra quyết định, bạn cần nhìn nhận phạm vi bảo mật không còn gói gọn trong nội bộ, mà là toàn bộ hệ sinh thái kỹ thuật số bạn kết nối, từ công cụ AI đến các nhà cung cấp dịch vụ đi kèm.

Bài học cốt lõi: Thứ bị đánh cắp không phải là "bao nhiêu dữ liệu", mà là dữ liệu gì. Và đó là điều doanh nghiệp cần kiểm soát nhất khi bắt tay với AI.

securityinfowatch

Nguồn bài viết: https://www.securityinfowatch.com/c...sis-balancing-innovation-with-data-protection

Một sai sót nhỏ trong hệ thống AI có thể khiến hàng tỷ dữ liệu bị lộ. Câu chuyện dưới đây không còn là tương lai, nó đã xảy ra.

Trong vòng 1 năm qua, việc sử dụng AI trong doanh nghiệp đã tăng hơn 3.000%. Nhưng đi kèm với đó là nguy cơ rò rỉ dữ liệu tăng vọt. Báo cáo mới nhất cho thấy 8,5% lời nhắc mà nhân viên nhập vào AI chứa dữ liệu nhạy cảm, từ thông tin tài chính, khách hàng, đến tài liệu mật. Doanh nghiệp đang bước vào một kỷ nguyên mà sự đổi mới đồng nghĩa với nguy cơ.

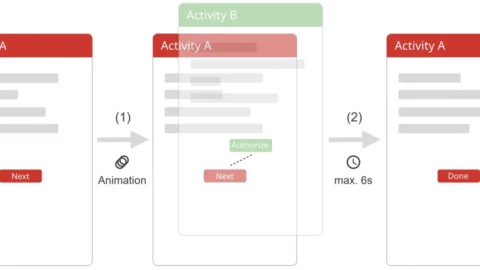

Vấn đề không nằm ở bản thân AI, mà ở cách ta triển khai nó. Khi các công cụ AI được tích hợp sâu vào hoạt động nội bộ và mở rộng kết nối với các nhà cung cấp bên thứ ba, mỗi điểm tiếp xúc trở thành một cửa ngõ cho tin tặc.

Tấn công một chỗ, tổn hại toàn hệ thống

Trong năm 2024, 4,2 tỷ hồ sơ đã bị lộ, tăng gần 180% so với năm trước. Một phần lớn trong đó đến từ các hệ thống AI có điểm lỗi tập trung, như vụ National Public Data với 2,9 tỷ hồ sơ bị rò rỉ, tất cả từ một mô hình tổng hợp dữ liệu.Không chỉ vậy, chuỗi cung ứng và các đối tác tích hợp AI cũng có thể mở rộng bề mặt tấn công, khiến một vụ xâm nhập nhỏ trở thành thảm họa diện rộng. Một cuộc tấn công Magecart thông qua thư viện JavaScript bên thứ ba đã ảnh hưởng đến cả chuỗi bán lẻ.

Giải pháp nào cho cuộc khủng hoảng bảo mật AI?

Các tổ chức đang chuyển sang các mô hình phòng thủ mới để giữ dữ liệu an toàn mà vẫn không kìm hãm đổi mới:- DRM (Digital Rights Management): kiểm soát quyền truy cập, phân loại dữ liệu trước khi đưa vào AI, ghi lại toàn bộ tương tác để truy vết nếu có sự cố.

- Chỉnh sửa không sở hữu: chỉnh tài liệu trực tiếp trên nền tảng mà không tải về, giảm nguy cơ rò rỉ cục bộ.

- Hộp cát AI (AI Sandbox): môi trường biệt lập để thử nghiệm dữ liệu nhạy cảm, không làm ảnh hưởng đến toàn hệ thống.

- Mô hình Zero Trust: không tin ai mặc định, mọi truy cập và tương tác đều phải xác minh, giới hạn theo nhiệm vụ.

Thêm vào đó là các chức năng DLP (Data Loss Prevention), tuyến phòng thủ cuối cùng, ngăn việc chia sẻ hoặc sử dụng sai dữ liệu dù vô tình hay cố ý.

Bảo vệ để đổi mới, không phải để trì hoãn

Cuộc chơi AI hiện nay không chỉ là ai phát triển nhanh hơn, mà là ai an toàn hơn khi phát triển. Một vụ rò rỉ như Change Healthcare không cần số lượng hồ sơ lớn, nhưng đủ để gây ảnh hưởng hệ sinh thái toàn ngành.Nếu bạn là người ra quyết định, bạn cần nhìn nhận phạm vi bảo mật không còn gói gọn trong nội bộ, mà là toàn bộ hệ sinh thái kỹ thuật số bạn kết nối, từ công cụ AI đến các nhà cung cấp dịch vụ đi kèm.

Bài học cốt lõi: Thứ bị đánh cắp không phải là "bao nhiêu dữ liệu", mà là dữ liệu gì. Và đó là điều doanh nghiệp cần kiểm soát nhất khi bắt tay với AI.

securityinfowatch

Được phối hợp thực hiện bởi các chuyên gia của Bkav,

cộng đồng An ninh mạng Việt Nam WhiteHat

và cộng đồng Khoa học công nghệ VnReview