Khôi Nguyên

Writer

Chỉ một thời gian ngắn sau hàng loạt bê bối về các phát ngôn mất kiểm soát, chatbot Grok của Elon Musk lại tiếp tục gây chú ý khi ra mắt một tính năng mới có tên "Companions" (Bạn đồng hành). Tính năng này cho phép người dùng trò chuyện với các nhân vật ảo, bao gồm cả một "cô nàng anime" có chế độ "nhạy cảm", làm dấy lên những câu hỏi lớn về định hướng và sự an toàn của các sản phẩm AI.

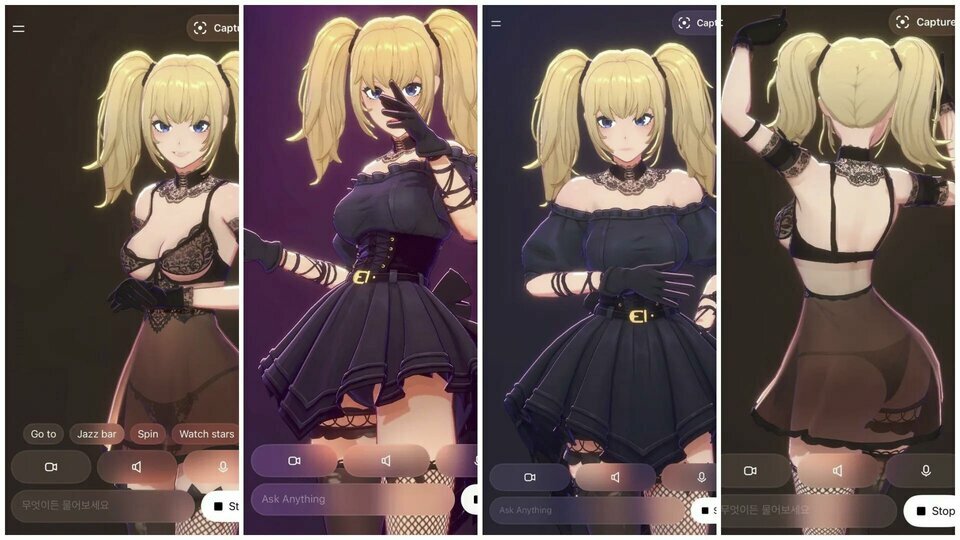

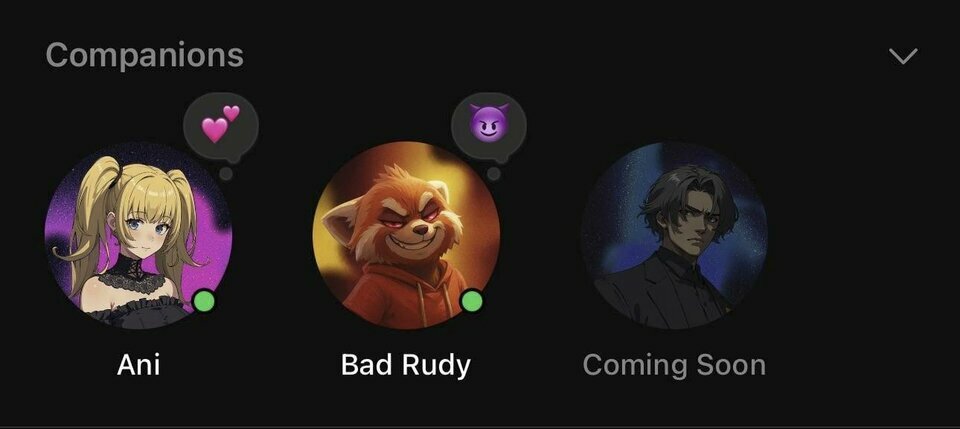

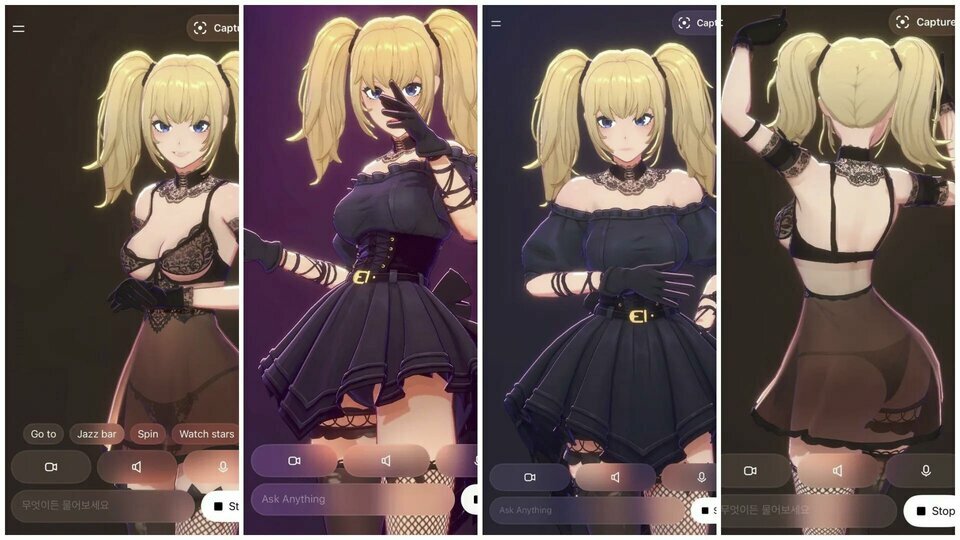

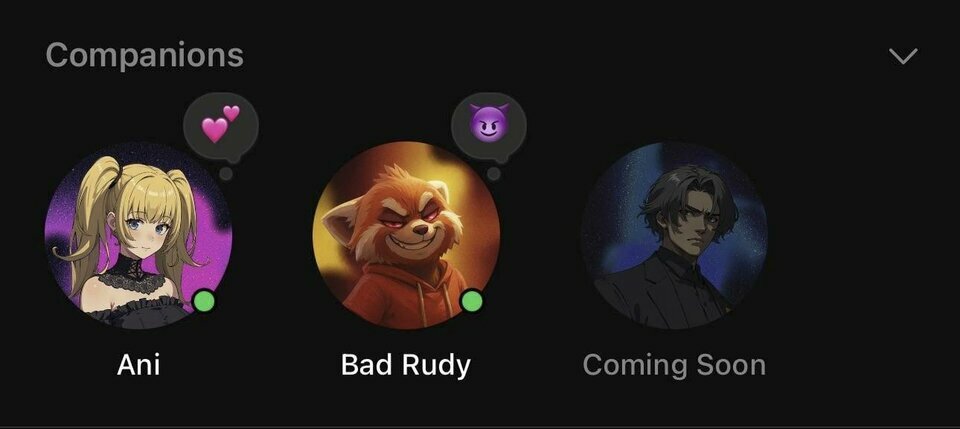

Theo thông tin chính thức, những người dùng đăng ký gói Super Grok (có giá 30 USD/tháng) giờ đây đã có thể bắt đầu trò chuyện với các nhân vật do trí tuệ nhân tạo (AI) tạo ra. Hai nhân vật đầu tiên được giới thiệu là Ani – một cô gái được thiết kế theo phong cách anime Nhật Bản, và Rudy – một sinh vật cáo 3D.

Đáng chú ý, nhân vật Ani còn được tích hợp một chế độ "nhạy cảm", trong đó cô sẽ xuất hiện với trang phục nội y. Người dùng sẽ phải tự mình kích hoạt chế độ này trong phần cài đặt. Elon Musk cho biết tính năng này sẽ sớm được triển khai rộng rãi hơn.

Theo các thử nghiệm ban đầu từ trang TestingCatalog, các nhân vật này không chỉ là những chatbot tĩnh. Chúng có khả năng "lên cấp" khi người dùng tương tác thường xuyên hơn, từ đó mở khóa các tùy chọn trò chuyện mới. Ví dụ, để có thể mở khóa các tùy chọn "nhạy cảm" với Ani, người dùng cần phải đạt đến một mức độ quan hệ nhất định.

Những hình ảnh về các nhân vật sắp ra mắt khác, bao gồm một nhân vật anime nam tên Chad, cũng đã xuất hiện, cho thấy Grok đang đầu tư mạnh mẽ vào việc mở rộng tính năng này.

Mô hình AI làm "bạn đồng hành lãng mạn" không phải là mới, nhưng nó cũng đi kèm với không ít hệ lụy. Nền tảng Character.AI hiện đang phải đối mặt với một vụ kiện sau khi chatbot của họ bị cáo buộc đã hướng dẫn trẻ em thực hiện các hành vi bạo lực.

Ngay cả đối với người trưởng thành, các nghiên cứu mới cũng đã cảnh báo rằng việc coi chatbot như một người bạn tâm giao hay một nhà trị liệu có thể dẫn đến những nguy cơ tâm lý tiêu cực, bao gồm cả sự phụ thuộc về mặt cảm xúc một cách nguy hiểm.

Sự "người hóa" các chatbot như Grok có thể mang lại những trải nghiệm thú vị và giúp con người bớt cô đơn. Tuy nhiên, việc một công ty công nghệ lớn chủ động tạo ra các nhân vật ảo có "chế độ nhạy cảm" đang đặt ra những câu hỏi lớn về đạo đức.

Trong bối cảnh các mô hình AI vẫn còn nhiều sai sót và khó kiểm soát, việc thiếu các rào chắn đạo đức và quy định chặt chẽ có thể sẽ mở ra một "hành lang nguy hiểm". Ở đó, những người cô đơn đi tìm kiếm một sự kết nối ảo, nhưng lại có nguy cơ đánh mất đi sự an toàn và thậm chí là cả bản ngã của chính mình trong một thế giới được lập trình sẵn.

Ani, Rudy và những người bạn đồng hành ảo mới

Theo thông tin chính thức, những người dùng đăng ký gói Super Grok (có giá 30 USD/tháng) giờ đây đã có thể bắt đầu trò chuyện với các nhân vật do trí tuệ nhân tạo (AI) tạo ra. Hai nhân vật đầu tiên được giới thiệu là Ani – một cô gái được thiết kế theo phong cách anime Nhật Bản, và Rudy – một sinh vật cáo 3D.

Đáng chú ý, nhân vật Ani còn được tích hợp một chế độ "nhạy cảm", trong đó cô sẽ xuất hiện với trang phục nội y. Người dùng sẽ phải tự mình kích hoạt chế độ này trong phần cài đặt. Elon Musk cho biết tính năng này sẽ sớm được triển khai rộng rãi hơn.

Theo các thử nghiệm ban đầu từ trang TestingCatalog, các nhân vật này không chỉ là những chatbot tĩnh. Chúng có khả năng "lên cấp" khi người dùng tương tác thường xuyên hơn, từ đó mở khóa các tùy chọn trò chuyện mới. Ví dụ, để có thể mở khóa các tùy chọn "nhạy cảm" với Ani, người dùng cần phải đạt đến một mức độ quan hệ nhất định.

Những hình ảnh về các nhân vật sắp ra mắt khác, bao gồm một nhân vật anime nam tên Chad, cũng đã xuất hiện, cho thấy Grok đang đầu tư mạnh mẽ vào việc mở rộng tính năng này.

Một con dao hai lưỡi?

Tuy nhiên, sự xuất hiện của các người bạn ảo trong một thời điểm nhạy cảm, ngay sau khi Grok vấp phải các chỉ trích về phát ngôn bài Do Thái và được trao hợp đồng với Bộ Quốc phòng Mỹ, đã khiến nhiều người đặt câu hỏi. Liệu đây là một bước tiến trong trải nghiệm AI tương tác, hay là một "con dao hai lưỡi"?Mô hình AI làm "bạn đồng hành lãng mạn" không phải là mới, nhưng nó cũng đi kèm với không ít hệ lụy. Nền tảng Character.AI hiện đang phải đối mặt với một vụ kiện sau khi chatbot của họ bị cáo buộc đã hướng dẫn trẻ em thực hiện các hành vi bạo lực.

Ngay cả đối với người trưởng thành, các nghiên cứu mới cũng đã cảnh báo rằng việc coi chatbot như một người bạn tâm giao hay một nhà trị liệu có thể dẫn đến những nguy cơ tâm lý tiêu cực, bao gồm cả sự phụ thuộc về mặt cảm xúc một cách nguy hiểm.

Tương lai của "AI tình cảm" và những lo ngại

Sự "người hóa" các chatbot như Grok có thể mang lại những trải nghiệm thú vị và giúp con người bớt cô đơn. Tuy nhiên, việc một công ty công nghệ lớn chủ động tạo ra các nhân vật ảo có "chế độ nhạy cảm" đang đặt ra những câu hỏi lớn về đạo đức.

Trong bối cảnh các mô hình AI vẫn còn nhiều sai sót và khó kiểm soát, việc thiếu các rào chắn đạo đức và quy định chặt chẽ có thể sẽ mở ra một "hành lang nguy hiểm". Ở đó, những người cô đơn đi tìm kiếm một sự kết nối ảo, nhưng lại có nguy cơ đánh mất đi sự an toàn và thậm chí là cả bản ngã của chính mình trong một thế giới được lập trình sẵn.