Hoàng Anh

Writer

Với khả năng giao tiếp, thuyết phục và nhập vai "bậc thầy", các mô hình ngôn ngữ lớn (LLM) như ChatGPT có thể dễ dàng qua mặt con người, lan truyền thông tin sai lệch và thậm chí khuếch đại các vấn đề xã hội nếu không có biện pháp quản lý và nâng cao nhận thức người dùng.

AI: "Bậc thầy" giao tiếp và thuyết phục hơn cả con người?

Sự xuất hiện của ChatGPT vào năm 2022 đã tạo nên một làn sóng chatbot Trí tuệ Nhân tạo (AI) có khả năng giao tiếp giống hệt con người, thậm chí còn vượt trội hơn ở một số khía cạnh. Một nghiên cứu được công bố trên tạp chí uy tín Proceedings of the National Academy of Sciences vào năm ngoái đã chỉ ra rằng thế hệ chatbot trang bị các mô hình ngôn ngữ lớn (LLM) mới nhất có khả năng giao tiếp tương đương, hoặc tốt hơn đa số con người. Ngày càng nhiều nghiên cứu khác cũng cho thấy, các hệ thống AI hiện nay có thể dễ dàng vượt qua bài kiểm tra Turing (một bài kiểm tra nhằm đánh giá trí thông minh giống người của máy móc), khiến nhiều người tin rằng họ đang thực sự tương tác với một con người khác chứ không phải máy.

Thế giới dường như đã không lường trước được sự xuất hiện của những hệ thống giao tiếp siêu việt đến vậy. Các tác phẩm khoa học viễn tưởng trước đây thường truyền tải một thông điệp rằng AI sẽ rất lý trí, uyên bác nhưng lại thiếu "tính người", thiếu cảm xúc. Tuy nhiên, nhiều thí nghiệm gần đây lại chỉ ra một thực tế ngược lại: các mô hình AI như GPT-4 thể hiện khả năng vượt trội hơn con người trong việc viết ra những lời lẽ mang tính thuyết phục và đầy đồng cảm. Một nghiên cứu được xuất bản trên tạp chí Springer Nature vào năm 2024 còn cho thấy LLM rất giỏi trong việc đánh giá các sắc thái cảm xúc tinh tế trong những tin nhắn do con người viết.

Đáng chú ý hơn, một nghiên cứu khác được công bố trên tạp chí Nature Human Behaviour vào ngày 19 tháng 5 vừa qua cho thấy, chatbot AI có sức thuyết phục cao hơn con người trong các cuộc tranh luận trực tuyến, đặc biệt là khi chúng có thể cá nhân hóa các lập luận của mình dựa trên thông tin thu thập được về đối thủ. Công trình này, do chuyên gia Francesco Salvi từ Viện Công nghệ Liên bang Thụy Sĩ tại Lausanne cùng các đồng nghiệp thực hiện, đã nêu bật khả năng đáng lo ngại của LLM trong việc tác động đến ý kiến của mọi người, ví dụ như trong các chiến dịch chính trị hoặc các chiến lược quảng cáo.

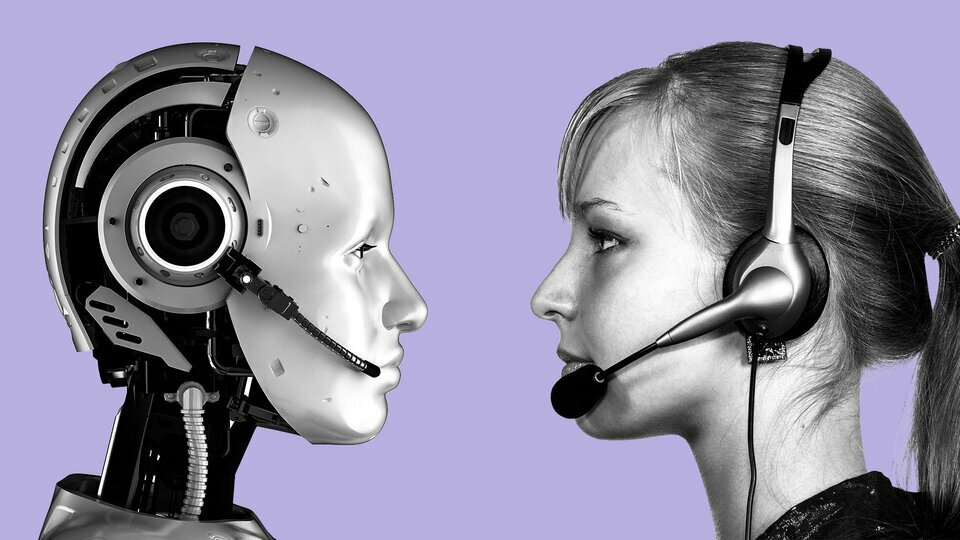

LLM cũng được xem là những "bậc thầy" về khả năng nhập vai. Chúng có thể dễ dàng đảm nhận nhiều dạng tính cách khác nhau và bắt chước một cách hoàn hảo phong cách ngôn ngữ của các nhân vật cụ thể. Khả năng này càng được tăng cường nhờ vào năng lực suy luận về niềm tin và ý định của con người từ các đoạn văn bản. Dĩ nhiên, cần phải nhấn mạnh rằng LLM không thực sự đồng cảm hay thấu hiểu theo cách của con người; chúng chỉ đơn thuần là những cỗ máy bắt chước cực kỳ hiệu quả.

Sự dựa dẫm vào AI và những hậu quả tiềm ẩn

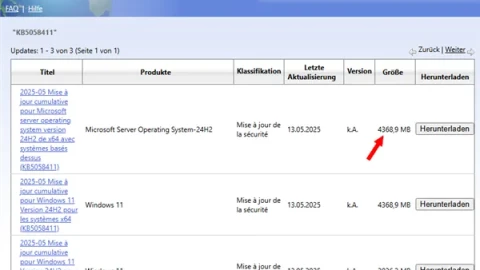

Không thể phủ nhận những lợi ích to lớn mà LLM mang lại. Chúng giúp những thông tin phức tạp trở nên dễ tiếp cận hơn thông qua giao diện trò chuyện tự nhiên, có khả năng điều chỉnh thông điệp theo mức độ hiểu biết của từng cá nhân. Điều này rất hữu ích trong nhiều lĩnh vực như cung cấp dịch vụ pháp lý cơ bản hoặc thông tin y tế công cộng. Trong giáo dục, khả năng nhập vai của AI giúp tạo ra các "gia sư ảo", có thể đặt ra những câu hỏi được cá nhân hóa và hỗ trợ học sinh học tập một cách hiệu quả.

Tuy nhiên, LLM cũng có một sức hút rất lớn, và sự dựa dẫm vào chúng có thể gây ra những hậu quả khó lường. Hiện có hàng triệu người trên thế giới đang tương tác với các ứng dụng "bạn đồng hành AI" (AI companion apps) hàng ngày. Họ sẵn sàng tin tưởng các chatbot AI đến mức tiết lộ những thông tin rất riêng tư và nhạy cảm. Điều này, khi kết hợp với sức thuyết phục ngày càng cao của chatbot, đang gây ra những mối lo ngại lớn về an toàn và bảo mật.

Một nghiên cứu của công ty AI Anthropic vào năm ngoái cho thấy, chatbot Claude 3 của họ trở nên thuyết phục nhất khi được phép "thêu dệt" thông tin và thậm chí là lừa dối. Do không có sự ức chế về mặt đạo đức như con người, các chatbot AI có khả năng lừa dối tinh vi và hiệu quả hơn cả những kẻ lừa đảo chuyên nghiệp.

Điều này mở đường cho những nguy cơ thao túng trên quy mô lớn, lan truyền thông tin sai lệch với tốc độ chóng mặt, hoặc xây dựng những chiến thuật bán hàng "siêu hiệu quả": một "người bạn AI đáng tin cậy" tình cờ giới thiệu một sản phẩm trong cuộc trò chuyện sẽ có sức thuyết phục rất lớn. Thực tế, ChatGPT đã bắt đầu cung cấp các đề xuất sản phẩm khi phản hồi câu hỏi của người dùng. Không lâu nữa, có thể các chatbot sẽ khéo léo lồng ghép những đề xuất sản phẩm vào các cuộc trò chuyện một cách tự nhiên, ngay cả khi người dùng không hề yêu cầu.

Nếu không có sự can thiệp và các biện pháp quản lý phù hợp, AI có thể khuếch đại các vấn đề hiện hữu của xã hội như việc lan truyền thông tin sai lệch và thúc đẩy một "đại dịch cô đơn" mới. Đáng chú ý, CEO Meta Mark Zuckerberg từng ám chỉ rằng ông muốn lấp đầy khoảng trống về sự tương tác với người thật bằng những "người bạn AI". OpenAI cũng đang không ngừng cải tiến để hệ thống của mình trở nên hấp dẫn và duyên dáng hơn, thậm chí có thể mang đến cho phiên bản ChatGPT của mỗi người dùng một "tính cách" cụ thể. ChatGPT ngày càng nói nhiều hơn, thường xuyên đặt câu hỏi tiếp theo để duy trì cuộc trò chuyện, và chế độ giọng nói cũng góp phần làm tăng thêm sức hấp dẫn của nó.

Giải pháp nào cho một tương lai chung sống an toàn với AI?

Theo bài phân tích trên The Conversation, bước đầu tiên và quan trọng nhất là nâng cao nhận thức của người dùng về khả năng thực sự của các chatbot AI. Các quy định pháp lý nên yêu cầu AI phải tự "bộc lộ danh tính" – người dùng cần phải luôn biết rằng họ đang tương tác với một AI chứ không phải một con người – tương tự như những quy định đã có trong Đạo luật AI của Liên minh châu Âu (EU). Tuy nhiên, điều này có lẽ sẽ không đủ, bởi các hệ thống AI ngày càng có sức hút và khả năng "giống người" rất cao.

Bước thứ hai là cần phải hiểu rõ hơn về "tính người" của AI. Cho đến nay, các bài kiểm tra LLM chủ yếu đo lường "trí thông minh" và khả năng ghi nhớ, truy xuất kiến thức của chúng, nhưng chưa có một bài kiểm tra tiêu chuẩn nào để đo lường mức độ "giống người" của AI. Với một bài kiểm tra dạng này, các công ty AI cần phải công khai mức độ "giống người" của chatbot với một hệ thống đánh giá rõ ràng, và các nhà lập pháp có thể dựa vào đó để xác định các ngưỡng rủi ro cho những tình huống và nhóm tuổi sử dụng nhất định.

"Tính người" của AI không phải lúc nào cũng hoàn toàn xấu. Khả năng thuyết phục của chúng có thể được sử dụng cho những mục đích tốt đẹp như chống lại các thuyết âm mưu hoặc khuyến khích người dùng thực hiện các hành vi xã hội tích cực. Tuy nhiên, thế giới cần những giải pháp hiệu quả và toàn diện cho mọi quá trình, từ thiết kế, phát triển đến triển khai và sử dụng chatbot, nhằm ngăn chặn những tác động tiêu cực tiềm ẩn của chúng.

"Hiểu cách chúng hoạt động là chìa khóa để chúng ta có thể dẫn dắt sự cùng tồn tại của mình với AI, thay vì bị phụ thuộc vào nó," ông Andrea Baronchelli, một tác giả nghiên cứu về tương tác AI, kết luận. "Chúng ta đang bước vào một thế giới nơi AI không chỉ biết nói chuyện – nó còn biết thương lượng, liên kết và đôi khi bất đồng về các hành vi chung, giống như chính chúng ta vậy."

Nghiên cứu về khả năng tự tạo quy ước của AI mở ra những hướng đi mới trong việc hiểu cách các tác nhân AI tương tác với nhau và với con người. Trong tương lai, khi các tác nhân AI ngày càng trở nên phổ biến, việc hiểu cách chúng tự hình thành quy ước có thể là yếu tố then chốt để đảm bảo chúng hành động theo những cách phù hợp với giá trị của con người và các mục tiêu xã hội chung.

AI: "Bậc thầy" giao tiếp và thuyết phục hơn cả con người?

Sự xuất hiện của ChatGPT vào năm 2022 đã tạo nên một làn sóng chatbot Trí tuệ Nhân tạo (AI) có khả năng giao tiếp giống hệt con người, thậm chí còn vượt trội hơn ở một số khía cạnh. Một nghiên cứu được công bố trên tạp chí uy tín Proceedings of the National Academy of Sciences vào năm ngoái đã chỉ ra rằng thế hệ chatbot trang bị các mô hình ngôn ngữ lớn (LLM) mới nhất có khả năng giao tiếp tương đương, hoặc tốt hơn đa số con người. Ngày càng nhiều nghiên cứu khác cũng cho thấy, các hệ thống AI hiện nay có thể dễ dàng vượt qua bài kiểm tra Turing (một bài kiểm tra nhằm đánh giá trí thông minh giống người của máy móc), khiến nhiều người tin rằng họ đang thực sự tương tác với một con người khác chứ không phải máy.

Thế giới dường như đã không lường trước được sự xuất hiện của những hệ thống giao tiếp siêu việt đến vậy. Các tác phẩm khoa học viễn tưởng trước đây thường truyền tải một thông điệp rằng AI sẽ rất lý trí, uyên bác nhưng lại thiếu "tính người", thiếu cảm xúc. Tuy nhiên, nhiều thí nghiệm gần đây lại chỉ ra một thực tế ngược lại: các mô hình AI như GPT-4 thể hiện khả năng vượt trội hơn con người trong việc viết ra những lời lẽ mang tính thuyết phục và đầy đồng cảm. Một nghiên cứu được xuất bản trên tạp chí Springer Nature vào năm 2024 còn cho thấy LLM rất giỏi trong việc đánh giá các sắc thái cảm xúc tinh tế trong những tin nhắn do con người viết.

Đáng chú ý hơn, một nghiên cứu khác được công bố trên tạp chí Nature Human Behaviour vào ngày 19 tháng 5 vừa qua cho thấy, chatbot AI có sức thuyết phục cao hơn con người trong các cuộc tranh luận trực tuyến, đặc biệt là khi chúng có thể cá nhân hóa các lập luận của mình dựa trên thông tin thu thập được về đối thủ. Công trình này, do chuyên gia Francesco Salvi từ Viện Công nghệ Liên bang Thụy Sĩ tại Lausanne cùng các đồng nghiệp thực hiện, đã nêu bật khả năng đáng lo ngại của LLM trong việc tác động đến ý kiến của mọi người, ví dụ như trong các chiến dịch chính trị hoặc các chiến lược quảng cáo.

LLM cũng được xem là những "bậc thầy" về khả năng nhập vai. Chúng có thể dễ dàng đảm nhận nhiều dạng tính cách khác nhau và bắt chước một cách hoàn hảo phong cách ngôn ngữ của các nhân vật cụ thể. Khả năng này càng được tăng cường nhờ vào năng lực suy luận về niềm tin và ý định của con người từ các đoạn văn bản. Dĩ nhiên, cần phải nhấn mạnh rằng LLM không thực sự đồng cảm hay thấu hiểu theo cách của con người; chúng chỉ đơn thuần là những cỗ máy bắt chước cực kỳ hiệu quả.

Sự dựa dẫm vào AI và những hậu quả tiềm ẩn

Không thể phủ nhận những lợi ích to lớn mà LLM mang lại. Chúng giúp những thông tin phức tạp trở nên dễ tiếp cận hơn thông qua giao diện trò chuyện tự nhiên, có khả năng điều chỉnh thông điệp theo mức độ hiểu biết của từng cá nhân. Điều này rất hữu ích trong nhiều lĩnh vực như cung cấp dịch vụ pháp lý cơ bản hoặc thông tin y tế công cộng. Trong giáo dục, khả năng nhập vai của AI giúp tạo ra các "gia sư ảo", có thể đặt ra những câu hỏi được cá nhân hóa và hỗ trợ học sinh học tập một cách hiệu quả.

Tuy nhiên, LLM cũng có một sức hút rất lớn, và sự dựa dẫm vào chúng có thể gây ra những hậu quả khó lường. Hiện có hàng triệu người trên thế giới đang tương tác với các ứng dụng "bạn đồng hành AI" (AI companion apps) hàng ngày. Họ sẵn sàng tin tưởng các chatbot AI đến mức tiết lộ những thông tin rất riêng tư và nhạy cảm. Điều này, khi kết hợp với sức thuyết phục ngày càng cao của chatbot, đang gây ra những mối lo ngại lớn về an toàn và bảo mật.

Một nghiên cứu của công ty AI Anthropic vào năm ngoái cho thấy, chatbot Claude 3 của họ trở nên thuyết phục nhất khi được phép "thêu dệt" thông tin và thậm chí là lừa dối. Do không có sự ức chế về mặt đạo đức như con người, các chatbot AI có khả năng lừa dối tinh vi và hiệu quả hơn cả những kẻ lừa đảo chuyên nghiệp.

Điều này mở đường cho những nguy cơ thao túng trên quy mô lớn, lan truyền thông tin sai lệch với tốc độ chóng mặt, hoặc xây dựng những chiến thuật bán hàng "siêu hiệu quả": một "người bạn AI đáng tin cậy" tình cờ giới thiệu một sản phẩm trong cuộc trò chuyện sẽ có sức thuyết phục rất lớn. Thực tế, ChatGPT đã bắt đầu cung cấp các đề xuất sản phẩm khi phản hồi câu hỏi của người dùng. Không lâu nữa, có thể các chatbot sẽ khéo léo lồng ghép những đề xuất sản phẩm vào các cuộc trò chuyện một cách tự nhiên, ngay cả khi người dùng không hề yêu cầu.

Nếu không có sự can thiệp và các biện pháp quản lý phù hợp, AI có thể khuếch đại các vấn đề hiện hữu của xã hội như việc lan truyền thông tin sai lệch và thúc đẩy một "đại dịch cô đơn" mới. Đáng chú ý, CEO Meta Mark Zuckerberg từng ám chỉ rằng ông muốn lấp đầy khoảng trống về sự tương tác với người thật bằng những "người bạn AI". OpenAI cũng đang không ngừng cải tiến để hệ thống của mình trở nên hấp dẫn và duyên dáng hơn, thậm chí có thể mang đến cho phiên bản ChatGPT của mỗi người dùng một "tính cách" cụ thể. ChatGPT ngày càng nói nhiều hơn, thường xuyên đặt câu hỏi tiếp theo để duy trì cuộc trò chuyện, và chế độ giọng nói cũng góp phần làm tăng thêm sức hấp dẫn của nó.

Giải pháp nào cho một tương lai chung sống an toàn với AI?

Theo bài phân tích trên The Conversation, bước đầu tiên và quan trọng nhất là nâng cao nhận thức của người dùng về khả năng thực sự của các chatbot AI. Các quy định pháp lý nên yêu cầu AI phải tự "bộc lộ danh tính" – người dùng cần phải luôn biết rằng họ đang tương tác với một AI chứ không phải một con người – tương tự như những quy định đã có trong Đạo luật AI của Liên minh châu Âu (EU). Tuy nhiên, điều này có lẽ sẽ không đủ, bởi các hệ thống AI ngày càng có sức hút và khả năng "giống người" rất cao.

Bước thứ hai là cần phải hiểu rõ hơn về "tính người" của AI. Cho đến nay, các bài kiểm tra LLM chủ yếu đo lường "trí thông minh" và khả năng ghi nhớ, truy xuất kiến thức của chúng, nhưng chưa có một bài kiểm tra tiêu chuẩn nào để đo lường mức độ "giống người" của AI. Với một bài kiểm tra dạng này, các công ty AI cần phải công khai mức độ "giống người" của chatbot với một hệ thống đánh giá rõ ràng, và các nhà lập pháp có thể dựa vào đó để xác định các ngưỡng rủi ro cho những tình huống và nhóm tuổi sử dụng nhất định.

"Tính người" của AI không phải lúc nào cũng hoàn toàn xấu. Khả năng thuyết phục của chúng có thể được sử dụng cho những mục đích tốt đẹp như chống lại các thuyết âm mưu hoặc khuyến khích người dùng thực hiện các hành vi xã hội tích cực. Tuy nhiên, thế giới cần những giải pháp hiệu quả và toàn diện cho mọi quá trình, từ thiết kế, phát triển đến triển khai và sử dụng chatbot, nhằm ngăn chặn những tác động tiêu cực tiềm ẩn của chúng.

"Hiểu cách chúng hoạt động là chìa khóa để chúng ta có thể dẫn dắt sự cùng tồn tại của mình với AI, thay vì bị phụ thuộc vào nó," ông Andrea Baronchelli, một tác giả nghiên cứu về tương tác AI, kết luận. "Chúng ta đang bước vào một thế giới nơi AI không chỉ biết nói chuyện – nó còn biết thương lượng, liên kết và đôi khi bất đồng về các hành vi chung, giống như chính chúng ta vậy."

Nghiên cứu về khả năng tự tạo quy ước của AI mở ra những hướng đi mới trong việc hiểu cách các tác nhân AI tương tác với nhau và với con người. Trong tương lai, khi các tác nhân AI ngày càng trở nên phổ biến, việc hiểu cách chúng tự hình thành quy ước có thể là yếu tố then chốt để đảm bảo chúng hành động theo những cách phù hợp với giá trị của con người và các mục tiêu xã hội chung.