Nhung Phan

Intern Writer

Nhóm đội ngũ cựu nghiên cứu DeepSeek, Microsoft, Stanford, Northwestern, University of Washington vừa công bố RAGEN – phương pháp huấn luyện và đánh giá tác nhân AI mới, giúp tăng cường độ tin cậy, giảm hiện tượng "sập" khi huấn luyện học tập củng cố.

RAGEN tập trung vào các vấn đề tương tác đa số lượt xem, nơi AI phải thích nghi, ghi nhớ và suy luận trong điều kiện bất chấp, thay vì chỉ giải quyết nhiệm vụ tĩnh như học toán hay sinh mã mã.

Framework cốt lõi StarPO (Tối ưu hóa Chính sách Tư duy - Hành động-Thưởng) bao gồm hai pha: triển khai (AI tạo ra chuỗi tương tác hoàn chỉnh có suy luận) và cập nhật (tối ưu hóa dựa trên tổng thưởng chuẩn hóa), giúp quá trình học ổn định, dễ giải quyết hơn so với hệ thống truyền tải PPO phương pháp.

Đội ngũ sử dụng các biến thể Qwen 1.5 và Qwen 2.5 (nguồn mở, khả năng bổ sung chỉ dẫn tốt) làm nền tảng cho mọi thử nghiệm, đảm bảo khả năng so sánh và tái lập.

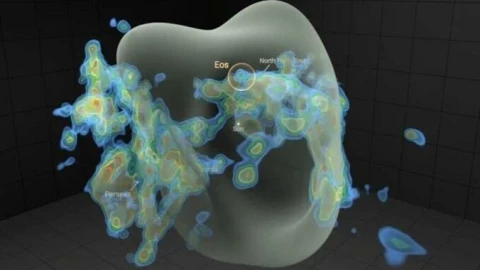

RAGEN kiểm tra AI Agent qua ba môi trường: Bandit (rủi ro-ngắn hạn), Sokoban (giải quyết nhiều lượt xem, quyết định không thể đảo ngược), Frozen Lake (kế hoạch thích nghi, ngẫu nhiên), tập trung vào khả năng quyết định, không dựa vào kiến thức thực tế.

Vấn đề lớn là "Echo Trap": AI cấm đầu suy luận tốt, nhưng RL truyền thống thưởng cho các câu tắt, khiến AI lặp lại hành vi, mất khả năng suy luận – biểu hiện qua biến thưởng, gradient tăng đột biến, mất dấu vết suy luận.

Để giải quyết, nhóm phát triển StarPO-S với ba cải tiến: lọc triển khai dựa trên bất kỳ mức độ nào, loại bỏ hình phạt KL (cho phép AI khám phá tự làm hơn), cắt PPO bất chấp xứng đáng (tăng cường học từ chuỗi thưởng cao). Kết quả: giảm hoặc loại bỏ hiện tượng, tăng hiệu suất trên cả ba bài toán.

Ba yếu tố thì chốt giúp RL ổn định: đa dạng vấn đề cấm đầu, cho phép nhiều hành động mỗi lần, và làm mới dữ liệu triển khai liên tục để tránh học từ lỗi tín hiệu.

Demo trực quan trên Github cho phép quan sát toàn bộ quá trình suy nghĩ – hành động của AI, tăng minh bạch.

Tuy nhiên, dấu vết suy luận dễ mất đi trong các số tiền nhiều như nếu không có thưởng trực tiếp cho quá trình này, cho thấy cần thiết kế khen thưởng tinh vi hơn.

RAGEN, StarPO, StarPO-S đã bố trí nguồn mở trên Github, nhưng chưa có giấy phép rõ ràng, có thể hạn chế quyền sử dụng.

RAGEN dễ dàng mở rộng môi trường mới, phù hợp cho doanh nghiệp mong muốn tự thiết kế bài toán huấn luyện đại lý AI.

Thách thức còn lại: khả năng mở rộng cho các hoạt động thực tế, duy trì suy luận lâu dài, thiết kế thưởng phù hợp cho các quy trình làm việc doanh nghiệp.

RAGEN là phương pháp RL mới giúp AI Agent suy luận tốt hơn, chống huấn luyện, thử nghiệm thành công trên Qwen, ba môi trường khác nhau. Framework StarPO-S cải thiện hiệu suất, tăng minh bạch, dễ dàng mở rộng môi trường mới, đã bố trí nguồn mở nhưng chưa rõ giấy phép.

RAGEN là phương pháp RL mới giúp AI Agent suy luận tốt hơn, chống huấn luyện, thử nghiệm thành công trên Qwen, ba môi trường khác nhau. Framework StarPO-S cải thiện hiệu suất, tăng minh bạch, dễ dàng mở rộng môi trường mới, đã bố trí nguồn mở nhưng chưa rõ giấy phép.

Nguồn bài viết: https://songai.vn/posts/ragen-phuong-phap-moi-huan-luyen-ai-agent

RAGEN tập trung vào các vấn đề tương tác đa số lượt xem, nơi AI phải thích nghi, ghi nhớ và suy luận trong điều kiện bất chấp, thay vì chỉ giải quyết nhiệm vụ tĩnh như học toán hay sinh mã mã.

Framework cốt lõi StarPO (Tối ưu hóa Chính sách Tư duy - Hành động-Thưởng) bao gồm hai pha: triển khai (AI tạo ra chuỗi tương tác hoàn chỉnh có suy luận) và cập nhật (tối ưu hóa dựa trên tổng thưởng chuẩn hóa), giúp quá trình học ổn định, dễ giải quyết hơn so với hệ thống truyền tải PPO phương pháp.

Đội ngũ sử dụng các biến thể Qwen 1.5 và Qwen 2.5 (nguồn mở, khả năng bổ sung chỉ dẫn tốt) làm nền tảng cho mọi thử nghiệm, đảm bảo khả năng so sánh và tái lập.

RAGEN kiểm tra AI Agent qua ba môi trường: Bandit (rủi ro-ngắn hạn), Sokoban (giải quyết nhiều lượt xem, quyết định không thể đảo ngược), Frozen Lake (kế hoạch thích nghi, ngẫu nhiên), tập trung vào khả năng quyết định, không dựa vào kiến thức thực tế.

Vấn đề lớn là "Echo Trap": AI cấm đầu suy luận tốt, nhưng RL truyền thống thưởng cho các câu tắt, khiến AI lặp lại hành vi, mất khả năng suy luận – biểu hiện qua biến thưởng, gradient tăng đột biến, mất dấu vết suy luận.

Để giải quyết, nhóm phát triển StarPO-S với ba cải tiến: lọc triển khai dựa trên bất kỳ mức độ nào, loại bỏ hình phạt KL (cho phép AI khám phá tự làm hơn), cắt PPO bất chấp xứng đáng (tăng cường học từ chuỗi thưởng cao). Kết quả: giảm hoặc loại bỏ hiện tượng, tăng hiệu suất trên cả ba bài toán.

Ba yếu tố thì chốt giúp RL ổn định: đa dạng vấn đề cấm đầu, cho phép nhiều hành động mỗi lần, và làm mới dữ liệu triển khai liên tục để tránh học từ lỗi tín hiệu.

Demo trực quan trên Github cho phép quan sát toàn bộ quá trình suy nghĩ – hành động của AI, tăng minh bạch.

Tuy nhiên, dấu vết suy luận dễ mất đi trong các số tiền nhiều như nếu không có thưởng trực tiếp cho quá trình này, cho thấy cần thiết kế khen thưởng tinh vi hơn.

RAGEN, StarPO, StarPO-S đã bố trí nguồn mở trên Github, nhưng chưa có giấy phép rõ ràng, có thể hạn chế quyền sử dụng.

RAGEN dễ dàng mở rộng môi trường mới, phù hợp cho doanh nghiệp mong muốn tự thiết kế bài toán huấn luyện đại lý AI.

Thách thức còn lại: khả năng mở rộng cho các hoạt động thực tế, duy trì suy luận lâu dài, thiết kế thưởng phù hợp cho các quy trình làm việc doanh nghiệp.

Nguồn bài viết: https://songai.vn/posts/ragen-phuong-phap-moi-huan-luyen-ai-agent