Thế Việt

Writer

Nhân viên tại OpenAI có thể “mất tất cả cổ phần mà họ kiếm được trong thời gian làm việc tại công ty, có thể trị giá hàng triệu đô la” nếu họ không ký một thỏa thuận không tiết lộ thông tin và không chê bai về công ty sau khi nghỉ việc, theo một tài liệu mới bị rò rỉ.

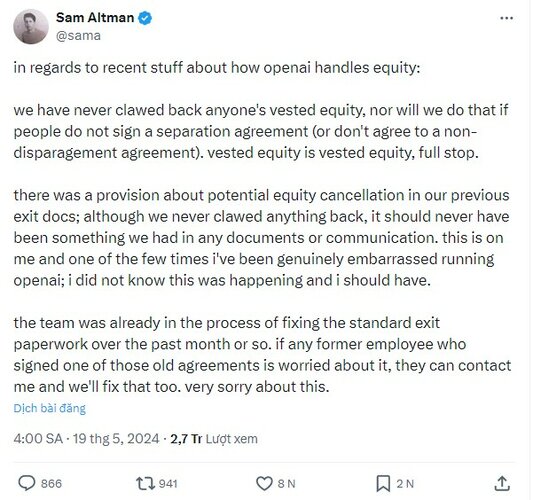

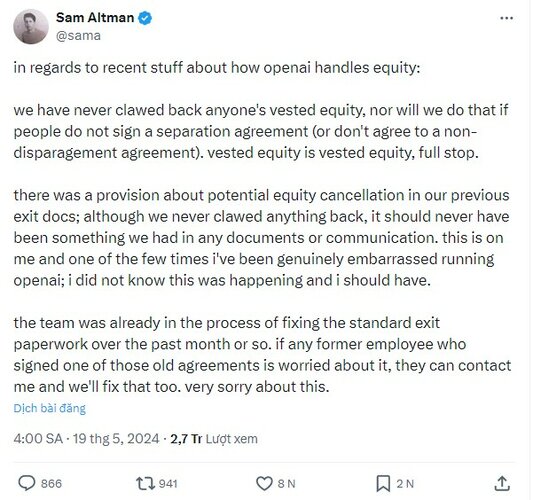

Giám đốc điều hành OpenAI Sam Altman đã xác nhận trên mạng xã hội X rằng điều khoản như vậy đã tồn tại, nhưng khẳng định “công ty chưa bao giờ lấy lại cổ phẩn của bất kỳ ai, OpenAI cũng sẽ không làm điều đó nếu nhân viên không ký thỏa thuận nghỉ việc (hoặc không đồng ý với thỏa thuận không chê bai công ty).”

Người phát ngôn của OpenAI đã lặp lại điều này trong một tuyên bố với Vox và Altman cho biết công ty “đang trong quá trình sửa chữa các thủ tục giấy tờ nghỉ việc tiêu chuẩn trong khoảng một tháng qua”. Nhưng như Vox lưu ý trong báo cáo của mình, ít nhất một cựu nhân viên OpenAI đã lên tiếng công khai về việc hy sinh cổ phần bằng cách từ chối ký cam kết bảo mật NDA khi nghỉ việc.

Trong phản hồi của Altman, Giám đốc điều hành đã xin lỗi và nói rằng ông “xấu hổ” sau khi biết về điều khoản này, điều mà ông khẳng định trước đây ông không hề biết. “Đây là điều khoản về khả năng hủy bỏ cổ phần trong các tài liệu rút lui trước đây của chúng tôi; mặc dù chúng tôi chưa bao giờ lấy lại được bất cứ thứ gì, nhưng lẽ ra nó không bao giờ là thứ chúng tôi có trong bất kỳ tài liệu hoặc thông tin liên lạc nào,” anh viết trên X. “điều này là do tôi và một trong số ít lần tôi thực sự xấu hổ khi điều hành OpenAI; tôi đã không biết điều này đang xảy ra”. Ngoài việc thừa nhận rằng công ty đang thay đổi thủ tục cho giấy nghỉ việc, Altman tiếp tục nói, “Nếu bất kỳ nhân viên cũ nào đã ký một trong những thỏa thuận cũ đó lo lắng về điều đó, họ có thể liên hệ với tôi và chúng tôi cũng sẽ khắc phục điều đó .”

OpenAI đang tiếp tục đứng trước nhiều tình huống rối ren. Jan Leike, Giám đốc an toàn của OpenAI, tuyên bố nghỉ việc và chỉ trích Sam Altman chạy theo những sản phẩm hào nhoáng thay vì phát triển AI có trách nhiệm. Jan Leike là đồng lãnh đạo dự án Superalignment (Siêu điều chỉnh) của OpenAI. Dự án được thành lập vào tháng 7/2023, chuyên phát triển giải pháp công nghệ giám sát AI, đề phòng một ngày nào đó trí tuệ nhân tạo thông minh hơn con người. Trước đó không lâu, Ilya Sutskever, nhà khoa học trưởng của OpenAI, cũng đăng thông báo: "Sau gần một thập kỷ, tôi quyết định rời OpenAI.

Theo Leike, ông tham gia OpenAI vì nghĩ đây là nơi tốt nhất cho việc nghiên cứu cách kiểm soát siêu trí tuệ AGI. "Tuy nhiên, tôi đã không đồng ý với lãnh đạo OpenAI trong một thời gian dài về các ưu tiên cốt lõi của công ty", ông viết.

Cựu lãnh đạo OpenAI cho rằng công ty nên tập trung và dành nhiều tài nguyên hơn vào an ninh, giám sát, chuẩn bị, an toàn, bảo mật, siêu liên kết, tác động xã hội và các chủ đề liên quan. "Tôi lo ngại chúng ta đang không đi đúng quỹ đạo để đạt được điều đó", Leike nói.

Việc nhóm của ông nghiên cứu cách điều chỉnh AI sao cho phù hợp và an toàn với nhân loại đã đi ngược hướng phát triển của công ty hiện tại. Trong vài tháng qua, nhóm gặp khó khăn khi không có đủ tài nguyên máy tính để thực hiện các nghiên cứu quan trọng.

Quyết định rời đi của Ilya Sutskever và Jan Leike cũng như việc giải tán nhóm Superalignment diễn ra vài ngày sau khi OpenAI công bố GPT-4o với khả năng được đánh giá là "gần tương đương con người".

Bên cạnh đó, The Information đưa tin Diane Yoon, Phó chủ tịch phụ trách nhân sự và Chris Clark, Giám đốc các sáng kiến chiến lược và phi lợi nhuận, cũng đã từ chức tại OpenAI. Tuần trước, Business Insider cũng cho biết hai nhà nghiên cứu về an toàn AI cũng đã nghỉ việc tại công ty của Sam Altman. Một trong hai nhà nghiên cứu nói ông không còn niềm tin vào việc OpenAI hứa hẹn sẽ hành xử có trách nhiệm khi bước vào thời kỳ của AGI.

#GPT4otoàntri #OpenAI #GPT4o

Giám đốc điều hành OpenAI Sam Altman đã xác nhận trên mạng xã hội X rằng điều khoản như vậy đã tồn tại, nhưng khẳng định “công ty chưa bao giờ lấy lại cổ phẩn của bất kỳ ai, OpenAI cũng sẽ không làm điều đó nếu nhân viên không ký thỏa thuận nghỉ việc (hoặc không đồng ý với thỏa thuận không chê bai công ty).”

Người phát ngôn của OpenAI đã lặp lại điều này trong một tuyên bố với Vox và Altman cho biết công ty “đang trong quá trình sửa chữa các thủ tục giấy tờ nghỉ việc tiêu chuẩn trong khoảng một tháng qua”. Nhưng như Vox lưu ý trong báo cáo của mình, ít nhất một cựu nhân viên OpenAI đã lên tiếng công khai về việc hy sinh cổ phần bằng cách từ chối ký cam kết bảo mật NDA khi nghỉ việc.

Trong phản hồi của Altman, Giám đốc điều hành đã xin lỗi và nói rằng ông “xấu hổ” sau khi biết về điều khoản này, điều mà ông khẳng định trước đây ông không hề biết. “Đây là điều khoản về khả năng hủy bỏ cổ phần trong các tài liệu rút lui trước đây của chúng tôi; mặc dù chúng tôi chưa bao giờ lấy lại được bất cứ thứ gì, nhưng lẽ ra nó không bao giờ là thứ chúng tôi có trong bất kỳ tài liệu hoặc thông tin liên lạc nào,” anh viết trên X. “điều này là do tôi và một trong số ít lần tôi thực sự xấu hổ khi điều hành OpenAI; tôi đã không biết điều này đang xảy ra”. Ngoài việc thừa nhận rằng công ty đang thay đổi thủ tục cho giấy nghỉ việc, Altman tiếp tục nói, “Nếu bất kỳ nhân viên cũ nào đã ký một trong những thỏa thuận cũ đó lo lắng về điều đó, họ có thể liên hệ với tôi và chúng tôi cũng sẽ khắc phục điều đó .”

OpenAI đang tiếp tục đứng trước nhiều tình huống rối ren. Jan Leike, Giám đốc an toàn của OpenAI, tuyên bố nghỉ việc và chỉ trích Sam Altman chạy theo những sản phẩm hào nhoáng thay vì phát triển AI có trách nhiệm. Jan Leike là đồng lãnh đạo dự án Superalignment (Siêu điều chỉnh) của OpenAI. Dự án được thành lập vào tháng 7/2023, chuyên phát triển giải pháp công nghệ giám sát AI, đề phòng một ngày nào đó trí tuệ nhân tạo thông minh hơn con người. Trước đó không lâu, Ilya Sutskever, nhà khoa học trưởng của OpenAI, cũng đăng thông báo: "Sau gần một thập kỷ, tôi quyết định rời OpenAI.

Theo Leike, ông tham gia OpenAI vì nghĩ đây là nơi tốt nhất cho việc nghiên cứu cách kiểm soát siêu trí tuệ AGI. "Tuy nhiên, tôi đã không đồng ý với lãnh đạo OpenAI trong một thời gian dài về các ưu tiên cốt lõi của công ty", ông viết.

Cựu lãnh đạo OpenAI cho rằng công ty nên tập trung và dành nhiều tài nguyên hơn vào an ninh, giám sát, chuẩn bị, an toàn, bảo mật, siêu liên kết, tác động xã hội và các chủ đề liên quan. "Tôi lo ngại chúng ta đang không đi đúng quỹ đạo để đạt được điều đó", Leike nói.

Việc nhóm của ông nghiên cứu cách điều chỉnh AI sao cho phù hợp và an toàn với nhân loại đã đi ngược hướng phát triển của công ty hiện tại. Trong vài tháng qua, nhóm gặp khó khăn khi không có đủ tài nguyên máy tính để thực hiện các nghiên cứu quan trọng.

Quyết định rời đi của Ilya Sutskever và Jan Leike cũng như việc giải tán nhóm Superalignment diễn ra vài ngày sau khi OpenAI công bố GPT-4o với khả năng được đánh giá là "gần tương đương con người".

Bên cạnh đó, The Information đưa tin Diane Yoon, Phó chủ tịch phụ trách nhân sự và Chris Clark, Giám đốc các sáng kiến chiến lược và phi lợi nhuận, cũng đã từ chức tại OpenAI. Tuần trước, Business Insider cũng cho biết hai nhà nghiên cứu về an toàn AI cũng đã nghỉ việc tại công ty của Sam Altman. Một trong hai nhà nghiên cứu nói ông không còn niềm tin vào việc OpenAI hứa hẹn sẽ hành xử có trách nhiệm khi bước vào thời kỳ của AGI.

#GPT4otoàntri #OpenAI #GPT4o