Thoại Viết Hoàng

Writer

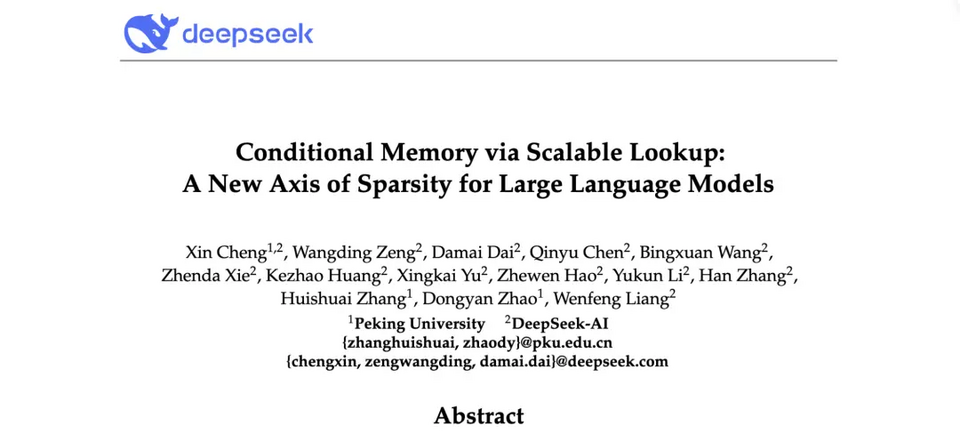

Sáng sớm nay, DeepSeek, nổi tiếng với những công trình nghiên cứu thầm lặng nhưng có tầm ảnh hưởng lớn, đã công bố một thành tựu công nghệ quan trọng khác bằng cách phát hành mã nguồn mở một bài báo và mô-đun mới, Engram, trên kho lưu trữ GitHub chính thức. Bài báo có tiêu đề "Bộ nhớ có điều kiện thông qua tra cứu có thể mở rộng: Một trục thưa thớt mới cho các mô hình ngôn ngữ lớn", một lần nữa liệt kê Liang Wenfeng (Lương Văn Phong) là đồng tác giả.

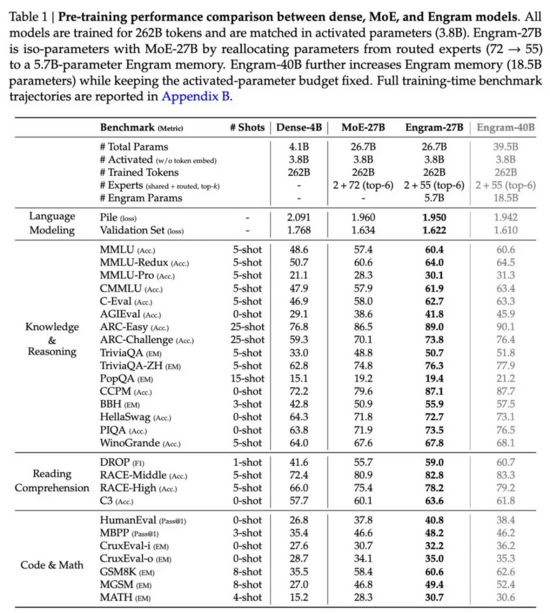

So với các kiến trúc mô hình quy mô lớn truyền thống, phương pháp này đề xuất một cơ chế "tách biệt tra cứu-tính toán" mới. Bằng cách giới thiệu cấu trúc bộ nhớ tra cứu có khả năng mở rộng, nó cải thiện đáng kể hiệu suất của mô hình trong việc truy xuất tri thức, suy luận, mã hóa và các tác vụ toán học trong điều kiện tham số và sức mạnh tính toán bằng nhau. Cả mã nguồn và toàn bộ bài báo đều là mã nguồn mở.

Địa chỉ bài báo: https://github.com/deepseek-ai/Engram/blob/main/Engram_paper.pdf

Địa chỉ mã nguồn: https://github.com/deepseek-ai/Engram

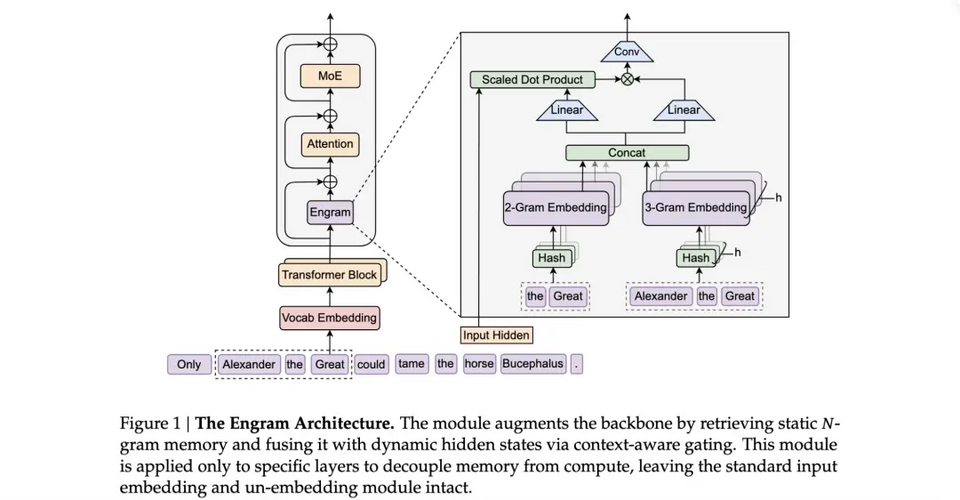

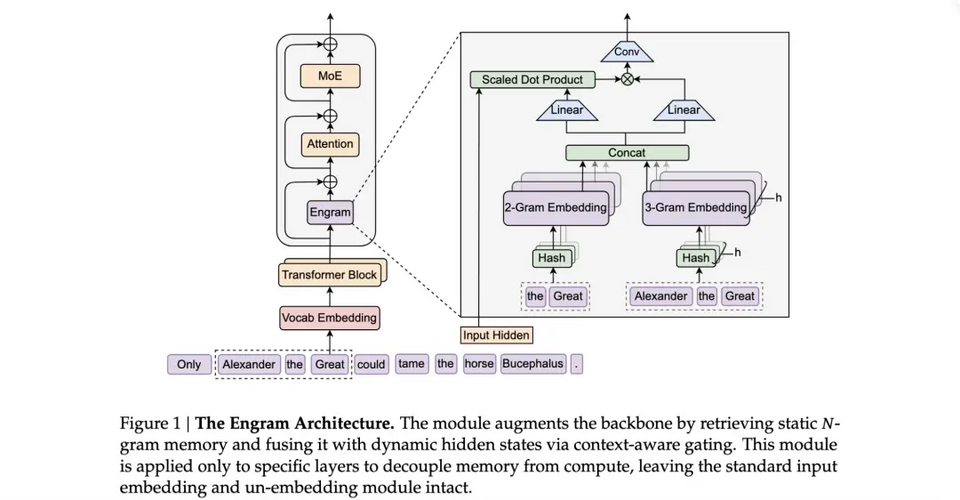

Kiến trúc tổng thể của phương pháp Engram mới này, tách biệt quá trình tra cứu và tính toán, được thể hiện trong sơ đồ sau:

Tại sao cần có ký ức (engram)? Vậy tại sao chúng ta cần Engram?

Hiện nay, các kiến trúc mô hình ngôn ngữ quy mô lớn phổ biến vẫn dựa trên cấu trúc Transformer và Mixture-of-Experts (MoE) . MoE là một trong những công nghệ chủ chốt để thúc đẩy quy mô tham số và mở rộng khả năng. Thông qua cơ chế định tuyến động, nó chỉ kích hoạt một số tham số nhất định để giảm chi phí tính toán trong khi vẫn đạt được sự mở rộng quy mô lớn về năng lực xử lý tác vụ. Các mô hình của DeepSeek (như DeepSeek V2 và DeepSeek V3) cũng sử dụng các phương pháp MoE tiên tiến để mở rộng quá trình huấn luyện.

Tuy nhiên, trong các kiến trúc Transformer truyền thống này (cho dù là Dense hay MoE), các tham số mô hình thực chất đóng hai vai trò rất khác nhau:

Trí nhớ thực tế (ghi nhớ): lưu trữ một lượng lớn kiến thức thực tế. Ví dụ như "Thủ đô của Pháp là gì?" và "Ngọn núi cao nhất thế giới là gì?". Loại thông tin này tương đối cứng nhắc và chủ yếu dựa vào kiểu tra cứu bảng.

Suy luận logic và tính toán: chịu trách nhiệm về các chuỗi logic phức tạp, suy luận nhiều bước và hiểu ngữ cảnh. Ví dụ, "tìm ra các lỗi có thể xảy ra từ logic của đoạn mã này" hoặc "phân tích một lập luận triết học phức tạp".

Các mô hình ngôn ngữ quy mô lớn hiện nay thường kết hợp hai khía cạnh này. Khi bạn cố gắng để mô hình ghi nhớ nhiều kiến thức hơn, bạn phải tăng số lượng tham số. Trong các mô hình Dense truyền thống, việc tăng số lượng tham số đồng nghĩa với sự gia tăng đột biến về chi phí tính toán (FLOPs) trong quá trình lan truyền tiến. Mặc dù kiến trúc MoE giải quyết được vấn đề "sức mạnh tính toán bùng nổ theo số lượng tham số" thông qua kích hoạt thưa, nghiên cứu của DeepSeek cho thấy các chuyên gia MoE vẫn chưa đủ hiệu quả khi xử lý các nhiệm vụ "ghi nhớ máy móc" .

Mạng nơ-ron về bản chất là các phép biến đổi toán học liên tục, và việc sử dụng các phép toán ma trận tốn kém để mô phỏng "tra cứu bảng" đơn giản là một sự lãng phí rất lớn. Engram của DeepSeek được thiết kế để giải quyết vấn đề này - "tra cứu bảng khi cần thiết và thực hiện các phép tính khi cần thiết".

Các ý tưởng cốt lõi và kiến trúc của Engram

Tập trung vào vấn đề cốt lõi, tại sao phương pháp Engram có thể giải quyết được những vấn đề nêu trên?

Thuật ngữ “Engram” bắt nguồn từ khoa học thần kinh và có nghĩa là “dấu vết trí nhớ”. Nó là một mô-đun bộ nhớ có thể mở rộng và tìm kiếm được, được các mô hình ngôn ngữ sử dụng để nhớ lại các mẫu hoặc các mảnh thông tin mà chúng có thể đã thấy trong quá khứ trong quá trình suy luận.

Một trong những công nghệ cốt lõi của Engram là phương pháp nhúng N-gram băm hiện đại hóa .

Phương pháp truyền thống: Mô hình liên tục trích xuất các đặc trưng từ văn bản đầu vào thông qua các phép biến đổi phi tuyến tính của nhiều lớp tự chú ý và lớp MLP.

Phương pháp Engram: Phương pháp này chia chuỗi token đầu vào thành N-gram (N từ liên tiếp) và sử dụng thuật toán băm để ánh xạ các phân đoạn này vào một bảng tra cứu khổng lồ, có thể học được.

Vì nó sử dụng chỉ mục băm, việc tra cứu này mang tính xác định và có độ phức tạp thời gian là O(1). Điều này có nghĩa là bất kể mô hình lưu trữ bao nhiêu nghìn tỷ phân đoạn bộ nhớ, tốc độ truy xuất gần như không đổi và chi phí tính toán cực kỳ thấp.

Ý nghĩa của O(1) là thời gian cần thiết cho một lần tra cứu là hằng số và không phụ thuộc vào kích thước của bảng N-gram.

Nói cách khác, thiết kế này về cơ bản chuyển giao một số "trách nhiệm bộ nhớ" từ tính toán thần kinh sâu (chẳng hạn như nhận dạng và điền lại các mẫu chuỗi và các phân đoạn kiến thức cố định), sao cho mô hình có cả các kênh thần kinh hoạt động (như Transformer + MoE) để xử lý các phép tính phức tạp và các kênh bộ nhớ tĩnh để xử lý hiệu quả các mẫu cố định. Đây được gọi là "trục thưa thớt mới".

Nói một cách đơn giản, MoE chịu trách nhiệm cho các suy luận thần kinh đòi hỏi nhiều tính toán và các chức năng tổ hợp phức tạp, trong khi Engram chịu trách nhiệm cho việc truy xuất bộ nhớ về các mẫu cố định và tái tạo mẫu. Cả hai cùng nhau tạo thành một kiến trúc tổng thể hiệu quả hơn.

Hơn nữa, nó sở hữu bộ nhớ có điều kiện. Không giống như các bảng tra cứu tĩnh đơn giản, Engram là "có điều kiện". Nó xác định những ký ức nào cần được truy xuất dựa trên các trạng thái ẩn của ngữ cảnh hiện tại.

Về mặt thiết kế kiến trúc, mô-đun Engram nằm ở giai đoạn đầu của lớp Transformer. Nó chịu trách nhiệm "Tái cấu trúc mẫu", nghĩa là trước khi lớp tính toán (MoE hoặc Dense) bắt đầu hoạt động, nó truy xuất các thông tin nền và các mẫu lịch sử có liên quan làm "nguyên liệu" để cung cấp cho lớp logic tiếp theo.

Nó có mối quan hệ như thế nào với MoE (Hội đồng chuyên gia)?

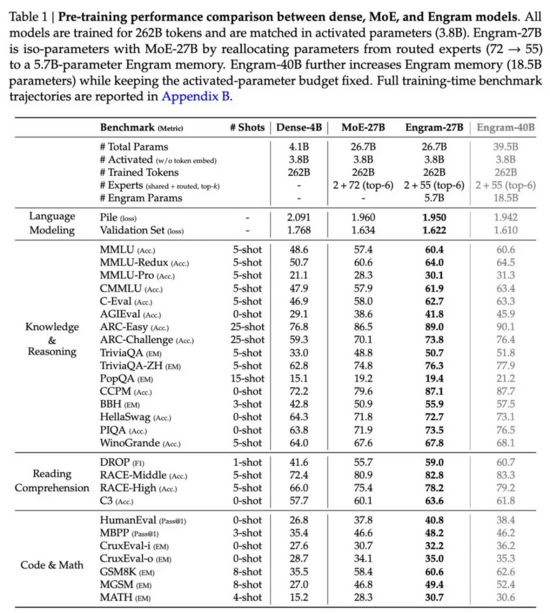

Bài báo chỉ rõ rằng Engram cung cấp một trục thưa thớt mới, khác với phương pháp tính toán có điều kiện của MoE, nó cung cấp dung lượng bộ nhớ tĩnh thông qua tra cứu có điều kiện. Sơ đồ dưới đây giải thích sự khác biệt giữa Engram và MoE từ bốn khía cạnh: mục tiêu, phương pháp tính toán, hướng tối ưu hóa và vị trí hành động.

Cuối cùng, DeepSeek kết hợp Engram với MoE để tạo thành một hệ thống kép:

Mô-đun Engram chịu trách nhiệm "lưu trữ và truy xuất nhanh" một lượng lớn điểm kiến thức.

Chuyên gia Bộ Giáo dục: Không còn gánh nặng ghi nhớ, tôi có thể hoàn toàn tập trung vào "lý luận logic và tổng hợp".

Sự phân công lao động này tối ưu hóa đáng kể hiệu quả tham số. Trong mô hình thử nghiệm 27B, mô-đun Engram có thể chiếm một số lượng lớn tham số cho bộ nhớ, nhưng lại tiêu thụ rất ít năng lượng tính toán (FLOPs) trong quá trình suy luận thực tế.

Cuối cùng, DeepSeek kết hợp Engram với MoE để tạo thành một hệ thống kép:

Mô-đun Engram chịu trách nhiệm "lưu trữ và truy xuất nhanh" một lượng lớn điểm kiến thức.

Chuyên gia Bộ Giáo dục: Không còn gánh nặng ghi nhớ, tôi có thể hoàn toàn tập trung vào "lý luận logic và tổng hợp".

Sự phân công lao động này tối ưu hóa đáng kể hiệu quả tham số. Trong mô hình thử nghiệm 27B, mô-đun Engram có thể chiếm một số lượng lớn tham số cho bộ nhớ, nhưng lại tiêu thụ rất ít năng lượng tính toán (FLOPs) trong quá trình suy luận thực tế.

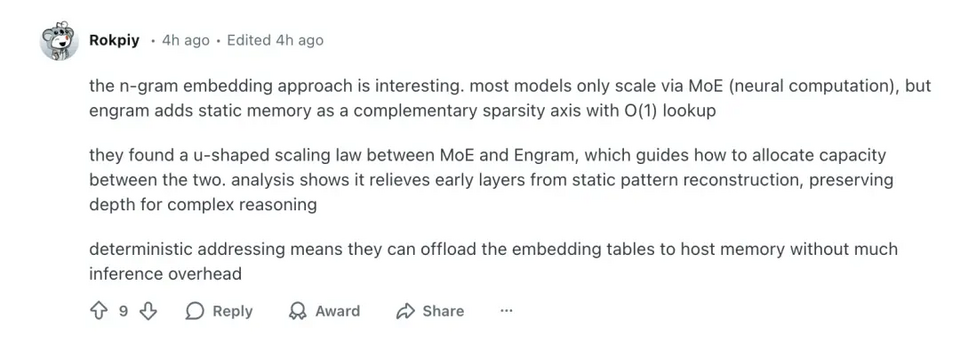

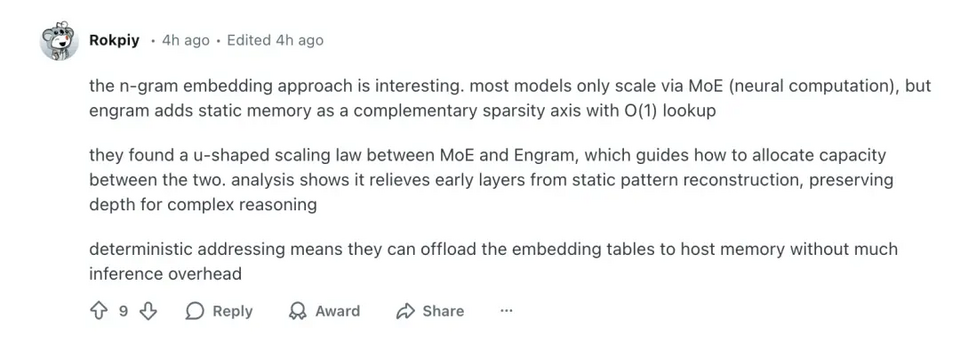

Trong khi đó, một người dùng bày tỏ sự quan tâm trực quan đến cơ chế tra cứu n-gram này, và bình luận:

Ngay cả trong môi trường không dựa vào GPU, phương pháp tra cứu O(1) này vẫn có thể đạt được, mang lại cho nhiều nhà phát triển kỳ vọng thực tế hơn về việc triển khai cục bộ các hàm mô hình lớn như vậy.

Trong một số bình luận kỹ thuật, một số người đã chỉ ra rằng:

Từ góc độ logic công nghệ hiện tại, việc bổ sung tra cứu bộ nhớ tĩnh vào LLM dường như là một hướng phát triển "tự nhiên".

Những quan điểm này phản ánh một điểm quan trọng: cộng đồng chuyên gia đang bắt đầu chuyển từ tư duy mở rộng tham số thuần túy sang thiết kế kiến trúc "thông minh" hơn, bao gồm sự hợp tác giữa các mô-đun bảng tra cứu và mạng nơ-ron.

Nhiều nhà phát triển cấp cao đã đề cập thêm trong cuộc thảo luận rằng thiết kế này về mặt khái niệm tương tự như một sự chuyển đổi hiện đại của các kỹ thuật xử lý ngôn ngữ tự nhiên truyền thống (như nhúng n-gram), kết hợp các cơ chế định địa chỉ hiệu quả (định địa chỉ xác định) và các mô-đun suy luận thần kinh. Trên lý thuyết, sự kết hợp này có tính khả thi và thực tiễn cao (đây chính là đóng góp cốt lõi của Engram).

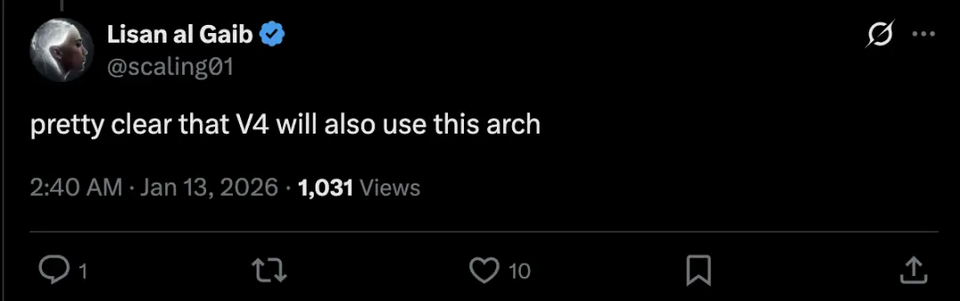

Một bình luận khác từ cộng đồng chỉ ra rằng Engram rất có thể là nền tảng công nghệ cốt lõi của mẫu V4 sắp ra mắt của DeepSeek:

Mô-đun Engram có khả năng trở thành một phần quan trọng của DeepSeek V4, và báo trước những cải tiến về kiến trúc trong bộ nhớ và sự hợp tác suy luận cho thế hệ tiếp theo của các mô hình DeepSeek.

Trên nền tảng X, một số cư dân mạng cũng đưa ra suy đoán tương tự, tin rằng V4 cũng sẽ áp dụng kiến trúc này.

Một số cư dân mạng đã nói đùa rằng ban đầu họ muốn sao chép công nghệ của Google, nhưng giờ họ lại sao chép DeepSeek vì nó tốt hơn của Google! Một số cư dân mạng cũng chỉ ra rằng Meta đã từng có những ý tưởng tương tự trước đây, nhưng sử dụng các công nghệ khác nhau.

Liệu kiến trúc này có được sử dụng trong V4 không? Một thiết lập hệ thống kép với MoE và Engram có vẻ thông minh hơn là chỉ đơn giản là cộng dồn các tham số. Chúng ta sẽ phải chờ đợi kết quả thử nghiệm thực tế để xem hiệu năng của nó như thế nào. #DeepSeekV4

So với các kiến trúc mô hình quy mô lớn truyền thống, phương pháp này đề xuất một cơ chế "tách biệt tra cứu-tính toán" mới. Bằng cách giới thiệu cấu trúc bộ nhớ tra cứu có khả năng mở rộng, nó cải thiện đáng kể hiệu suất của mô hình trong việc truy xuất tri thức, suy luận, mã hóa và các tác vụ toán học trong điều kiện tham số và sức mạnh tính toán bằng nhau. Cả mã nguồn và toàn bộ bài báo đều là mã nguồn mở.

Địa chỉ bài báo: https://github.com/deepseek-ai/Engram/blob/main/Engram_paper.pdf

Địa chỉ mã nguồn: https://github.com/deepseek-ai/Engram

Kiến trúc tổng thể của phương pháp Engram mới này, tách biệt quá trình tra cứu và tính toán, được thể hiện trong sơ đồ sau:

Tại sao cần có ký ức (engram)? Vậy tại sao chúng ta cần Engram?

Hiện nay, các kiến trúc mô hình ngôn ngữ quy mô lớn phổ biến vẫn dựa trên cấu trúc Transformer và Mixture-of-Experts (MoE) . MoE là một trong những công nghệ chủ chốt để thúc đẩy quy mô tham số và mở rộng khả năng. Thông qua cơ chế định tuyến động, nó chỉ kích hoạt một số tham số nhất định để giảm chi phí tính toán trong khi vẫn đạt được sự mở rộng quy mô lớn về năng lực xử lý tác vụ. Các mô hình của DeepSeek (như DeepSeek V2 và DeepSeek V3) cũng sử dụng các phương pháp MoE tiên tiến để mở rộng quá trình huấn luyện.

Tuy nhiên, trong các kiến trúc Transformer truyền thống này (cho dù là Dense hay MoE), các tham số mô hình thực chất đóng hai vai trò rất khác nhau:

Trí nhớ thực tế (ghi nhớ): lưu trữ một lượng lớn kiến thức thực tế. Ví dụ như "Thủ đô của Pháp là gì?" và "Ngọn núi cao nhất thế giới là gì?". Loại thông tin này tương đối cứng nhắc và chủ yếu dựa vào kiểu tra cứu bảng.

Suy luận logic và tính toán: chịu trách nhiệm về các chuỗi logic phức tạp, suy luận nhiều bước và hiểu ngữ cảnh. Ví dụ, "tìm ra các lỗi có thể xảy ra từ logic của đoạn mã này" hoặc "phân tích một lập luận triết học phức tạp".

Các mô hình ngôn ngữ quy mô lớn hiện nay thường kết hợp hai khía cạnh này. Khi bạn cố gắng để mô hình ghi nhớ nhiều kiến thức hơn, bạn phải tăng số lượng tham số. Trong các mô hình Dense truyền thống, việc tăng số lượng tham số đồng nghĩa với sự gia tăng đột biến về chi phí tính toán (FLOPs) trong quá trình lan truyền tiến. Mặc dù kiến trúc MoE giải quyết được vấn đề "sức mạnh tính toán bùng nổ theo số lượng tham số" thông qua kích hoạt thưa, nghiên cứu của DeepSeek cho thấy các chuyên gia MoE vẫn chưa đủ hiệu quả khi xử lý các nhiệm vụ "ghi nhớ máy móc" .

Mạng nơ-ron về bản chất là các phép biến đổi toán học liên tục, và việc sử dụng các phép toán ma trận tốn kém để mô phỏng "tra cứu bảng" đơn giản là một sự lãng phí rất lớn. Engram của DeepSeek được thiết kế để giải quyết vấn đề này - "tra cứu bảng khi cần thiết và thực hiện các phép tính khi cần thiết".

Các ý tưởng cốt lõi và kiến trúc của Engram

Tập trung vào vấn đề cốt lõi, tại sao phương pháp Engram có thể giải quyết được những vấn đề nêu trên?

Thuật ngữ “Engram” bắt nguồn từ khoa học thần kinh và có nghĩa là “dấu vết trí nhớ”. Nó là một mô-đun bộ nhớ có thể mở rộng và tìm kiếm được, được các mô hình ngôn ngữ sử dụng để nhớ lại các mẫu hoặc các mảnh thông tin mà chúng có thể đã thấy trong quá khứ trong quá trình suy luận.

Một trong những công nghệ cốt lõi của Engram là phương pháp nhúng N-gram băm hiện đại hóa .

Phương pháp truyền thống: Mô hình liên tục trích xuất các đặc trưng từ văn bản đầu vào thông qua các phép biến đổi phi tuyến tính của nhiều lớp tự chú ý và lớp MLP.

Phương pháp Engram: Phương pháp này chia chuỗi token đầu vào thành N-gram (N từ liên tiếp) và sử dụng thuật toán băm để ánh xạ các phân đoạn này vào một bảng tra cứu khổng lồ, có thể học được.

Vì nó sử dụng chỉ mục băm, việc tra cứu này mang tính xác định và có độ phức tạp thời gian là O(1). Điều này có nghĩa là bất kể mô hình lưu trữ bao nhiêu nghìn tỷ phân đoạn bộ nhớ, tốc độ truy xuất gần như không đổi và chi phí tính toán cực kỳ thấp.

Ý nghĩa của O(1) là thời gian cần thiết cho một lần tra cứu là hằng số và không phụ thuộc vào kích thước của bảng N-gram.

Nói cách khác, thiết kế này về cơ bản chuyển giao một số "trách nhiệm bộ nhớ" từ tính toán thần kinh sâu (chẳng hạn như nhận dạng và điền lại các mẫu chuỗi và các phân đoạn kiến thức cố định), sao cho mô hình có cả các kênh thần kinh hoạt động (như Transformer + MoE) để xử lý các phép tính phức tạp và các kênh bộ nhớ tĩnh để xử lý hiệu quả các mẫu cố định. Đây được gọi là "trục thưa thớt mới".

Nói một cách đơn giản, MoE chịu trách nhiệm cho các suy luận thần kinh đòi hỏi nhiều tính toán và các chức năng tổ hợp phức tạp, trong khi Engram chịu trách nhiệm cho việc truy xuất bộ nhớ về các mẫu cố định và tái tạo mẫu. Cả hai cùng nhau tạo thành một kiến trúc tổng thể hiệu quả hơn.

Hơn nữa, nó sở hữu bộ nhớ có điều kiện. Không giống như các bảng tra cứu tĩnh đơn giản, Engram là "có điều kiện". Nó xác định những ký ức nào cần được truy xuất dựa trên các trạng thái ẩn của ngữ cảnh hiện tại.

Về mặt thiết kế kiến trúc, mô-đun Engram nằm ở giai đoạn đầu của lớp Transformer. Nó chịu trách nhiệm "Tái cấu trúc mẫu", nghĩa là trước khi lớp tính toán (MoE hoặc Dense) bắt đầu hoạt động, nó truy xuất các thông tin nền và các mẫu lịch sử có liên quan làm "nguyên liệu" để cung cấp cho lớp logic tiếp theo.

Nó có mối quan hệ như thế nào với MoE (Hội đồng chuyên gia)?

Bài báo chỉ rõ rằng Engram cung cấp một trục thưa thớt mới, khác với phương pháp tính toán có điều kiện của MoE, nó cung cấp dung lượng bộ nhớ tĩnh thông qua tra cứu có điều kiện. Sơ đồ dưới đây giải thích sự khác biệt giữa Engram và MoE từ bốn khía cạnh: mục tiêu, phương pháp tính toán, hướng tối ưu hóa và vị trí hành động.

| Kích thước | Bộ Giáo dục | Engram |

|---|---|---|

| Mục tiêu | Phẫu thuật viên thần kinh kích hoạt có điều kiện | Tra cứu bộ nhớ tĩnh có điều kiện |

| Phương pháp tính toán | Chuyên gia tính toán/kích hoạt dày đặc Wuji | Tra cứu bảng O(1) |

| Hướng tối ưu hóa | Giảm hoạt động tính toán thần kinh | Giảm thiểu tính toán thần kinh để tái tạo các mẫu đã biết. |

| Địa điểm hành động | Lý luận sâu sắc | Tái tạo mẫu/truy xuất bộ nhớ giai đoạn đầu |

Mô-đun Engram chịu trách nhiệm "lưu trữ và truy xuất nhanh" một lượng lớn điểm kiến thức.

Chuyên gia Bộ Giáo dục: Không còn gánh nặng ghi nhớ, tôi có thể hoàn toàn tập trung vào "lý luận logic và tổng hợp".

Sự phân công lao động này tối ưu hóa đáng kể hiệu quả tham số. Trong mô hình thử nghiệm 27B, mô-đun Engram có thể chiếm một số lượng lớn tham số cho bộ nhớ, nhưng lại tiêu thụ rất ít năng lượng tính toán (FLOPs) trong quá trình suy luận thực tế.

Cuối cùng, DeepSeek kết hợp Engram với MoE để tạo thành một hệ thống kép:

Mô-đun Engram chịu trách nhiệm "lưu trữ và truy xuất nhanh" một lượng lớn điểm kiến thức.

Chuyên gia Bộ Giáo dục: Không còn gánh nặng ghi nhớ, tôi có thể hoàn toàn tập trung vào "lý luận logic và tổng hợp".

Sự phân công lao động này tối ưu hóa đáng kể hiệu quả tham số. Trong mô hình thử nghiệm 27B, mô-đun Engram có thể chiếm một số lượng lớn tham số cho bộ nhớ, nhưng lại tiêu thụ rất ít năng lượng tính toán (FLOPs) trong quá trình suy luận thực tế.

Trong khi đó, một người dùng bày tỏ sự quan tâm trực quan đến cơ chế tra cứu n-gram này, và bình luận:

Ngay cả trong môi trường không dựa vào GPU, phương pháp tra cứu O(1) này vẫn có thể đạt được, mang lại cho nhiều nhà phát triển kỳ vọng thực tế hơn về việc triển khai cục bộ các hàm mô hình lớn như vậy.

Trong một số bình luận kỹ thuật, một số người đã chỉ ra rằng:

Từ góc độ logic công nghệ hiện tại, việc bổ sung tra cứu bộ nhớ tĩnh vào LLM dường như là một hướng phát triển "tự nhiên".

Những quan điểm này phản ánh một điểm quan trọng: cộng đồng chuyên gia đang bắt đầu chuyển từ tư duy mở rộng tham số thuần túy sang thiết kế kiến trúc "thông minh" hơn, bao gồm sự hợp tác giữa các mô-đun bảng tra cứu và mạng nơ-ron.

Nhiều nhà phát triển cấp cao đã đề cập thêm trong cuộc thảo luận rằng thiết kế này về mặt khái niệm tương tự như một sự chuyển đổi hiện đại của các kỹ thuật xử lý ngôn ngữ tự nhiên truyền thống (như nhúng n-gram), kết hợp các cơ chế định địa chỉ hiệu quả (định địa chỉ xác định) và các mô-đun suy luận thần kinh. Trên lý thuyết, sự kết hợp này có tính khả thi và thực tiễn cao (đây chính là đóng góp cốt lõi của Engram).

Một bình luận khác từ cộng đồng chỉ ra rằng Engram rất có thể là nền tảng công nghệ cốt lõi của mẫu V4 sắp ra mắt của DeepSeek:

Mô-đun Engram có khả năng trở thành một phần quan trọng của DeepSeek V4, và báo trước những cải tiến về kiến trúc trong bộ nhớ và sự hợp tác suy luận cho thế hệ tiếp theo của các mô hình DeepSeek.

Trên nền tảng X, một số cư dân mạng cũng đưa ra suy đoán tương tự, tin rằng V4 cũng sẽ áp dụng kiến trúc này.

Một số cư dân mạng đã nói đùa rằng ban đầu họ muốn sao chép công nghệ của Google, nhưng giờ họ lại sao chép DeepSeek vì nó tốt hơn của Google! Một số cư dân mạng cũng chỉ ra rằng Meta đã từng có những ý tưởng tương tự trước đây, nhưng sử dụng các công nghệ khác nhau.

Liệu kiến trúc này có được sử dụng trong V4 không? Một thiết lập hệ thống kép với MoE và Engram có vẻ thông minh hơn là chỉ đơn giản là cộng dồn các tham số. Chúng ta sẽ phải chờ đợi kết quả thử nghiệm thực tế để xem hiệu năng của nó như thế nào. #DeepSeekV4