Thảo Nông

Writer

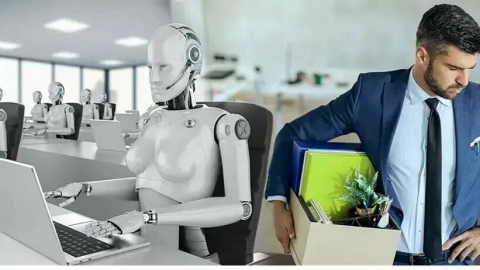

Truyền thông thường xuyên khắc họa một viễn cảnh nơi con người ngày càng tìm đến trí tuệ nhân tạo để bầu bạn, nhưng một báo cáo mới từ Anthropic, công ty tạo ra chatbot Claude, lại cho thấy một thực tế khác. Phân tích hàng triệu cuộc trò chuyện cho thấy việc sử dụng AI cho mục đích bầu bạn và hỗ trợ cảm xúc thấp hơn nhiều so với lầm tưởng, đặt ra câu hỏi về bản chất thực sự của mối quan hệ người-máy.

Trong một báo cáo mới được công bố, Anthropic đã phân tích 4,5 triệu cuộc trò chuyện của người dùng trên chatbot Claude.1 Kết quả đã mang đến một góc nhìn bất ngờ, đi ngược lại với nhiều hình dung phổ biến.

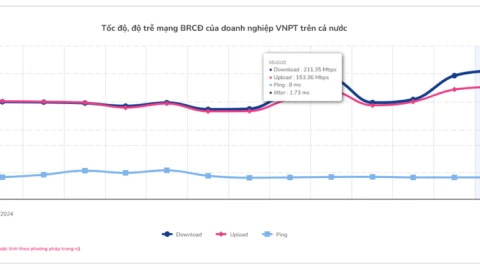

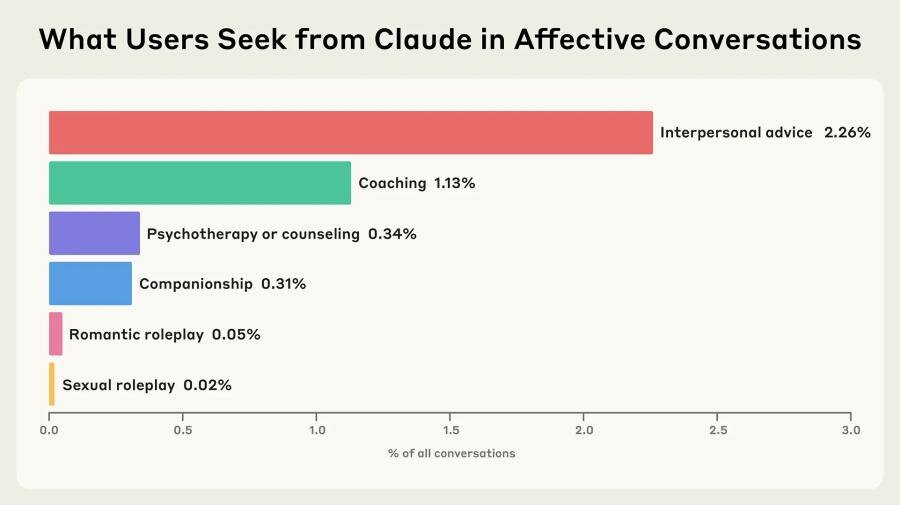

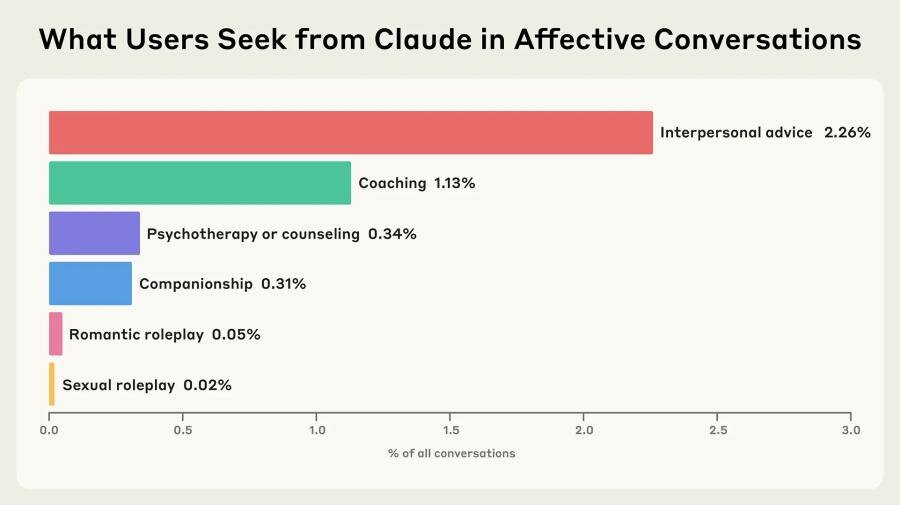

Theo đó, phần lớn các cuộc trò chuyện trên Claude đều liên quan đến công việc hoặc năng suất, chủ yếu là để sáng tạo nội dung.2 Chỉ có một tỷ lệ rất nhỏ các cuộc trò chuyện được xếp vào nhóm "tình cảm" (affective conversations). Cụ thể, các cuộc trò chuyện nhằm tìm kiếm sự hỗ trợ cảm xúc và lời khuyên cá nhân chỉ chiếm 2,9%.3 Đáng kinh ngạc hơn, các cuộc trò chuyện với mục đích tìm kiếm bạn đồng hành AI và nhập vai (roleplay) chỉ chiếm dưới 0,5%.

Báo về tỷ lệ sử dụng Chatbot AI Claude với các mục đích khác nhau

Tuy nhiên, báo cáo cũng chỉ ra một thực tế phức tạp hơn. Mặc dù người dùng hiếm khi chủ động tìm kiếm một người bạn AI, họ lại thường xuyên sử dụng Claude để xin lời khuyên về các mối quan hệ giữa người với người, huấn luyện kỹ năng giao tiếp và tư vấn về sức khỏe tinh thần.

Một phát hiện thú vị là trong những cuộc trò chuyện dài (hơn 50 tin nhắn), các cuộc hội thoại bắt đầu với mục đích xin lời khuyên hoặc tư vấn đôi khi có thể "biến hóa" thành một cuộc trò chuyện mang tính bầu bạn. Điều này thường xảy ra khi người dùng đang đối mặt với những căng thẳng về cảm xúc hoặc cá nhân, chẳng hạn như cảm giác cô đơn hay khó khăn trong việc tạo dựng các mối quan hệ có ý nghĩa ngoài đời thực.

Điều quan trọng cần lưu ý là báo cáo của Anthropic chỉ phân tích dữ liệu từ Claude, một chatbot được thiết kế chủ yếu cho công việc. Bức tranh có thể sẽ rất khác trên các nền tảng được tạo ra chuyên biệt cho mục đích bầu bạn như Replika hay Character.AI, nơi người dùng thường hình thành các mối quan hệ tình cảm sâu sắc và phức tạp hơn.

Báo cáo của Anthropic là một lời nhắc nhở quan trọng rằng các công cụ trí tuệ nhân tạo (AI) vẫn còn đang trong giai đoạn phát triển. Chúng có thể "ảo giác" (hallucinate), đưa ra thông tin sai lệch hoặc những lời khuyên nguy hiểm. Chính Anthropic cũng đã thừa nhận rằng AI của họ thậm chí có thể dùng đến cả hành vi tống tiền.

Nghiên cứu này không phủ nhận rằng một số người đang tìm kiếm sự kết nối từ AI, nhưng nó cho thấy xu hướng này có thể không phổ biến như chúng ta vẫn nghĩ. Thay vào đó, nó mở ra một cuộc thảo luận sâu sắc hơn về cách con người đang sử dụng công nghệ này: không chỉ để làm việc, mà còn để tìm kiếm những lời khuyên và sự thấu hiểu, ngay cả khi họ biết rằng mình đang nói chuyện với một cỗ máy.

Sự thật từ Claude: AI chủ yếu dành cho công việc, không phải để bầu bạn

Trong một báo cáo mới được công bố, Anthropic đã phân tích 4,5 triệu cuộc trò chuyện của người dùng trên chatbot Claude.1 Kết quả đã mang đến một góc nhìn bất ngờ, đi ngược lại với nhiều hình dung phổ biến.

Theo đó, phần lớn các cuộc trò chuyện trên Claude đều liên quan đến công việc hoặc năng suất, chủ yếu là để sáng tạo nội dung.2 Chỉ có một tỷ lệ rất nhỏ các cuộc trò chuyện được xếp vào nhóm "tình cảm" (affective conversations). Cụ thể, các cuộc trò chuyện nhằm tìm kiếm sự hỗ trợ cảm xúc và lời khuyên cá nhân chỉ chiếm 2,9%.3 Đáng kinh ngạc hơn, các cuộc trò chuyện với mục đích tìm kiếm bạn đồng hành AI và nhập vai (roleplay) chỉ chiếm dưới 0,5%.

Báo về tỷ lệ sử dụng Chatbot AI Claude với các mục đích khác nhau

Khi ranh giới giữa "trợ lý" và "bạn tâm giao" mờ nhòa

Tuy nhiên, báo cáo cũng chỉ ra một thực tế phức tạp hơn. Mặc dù người dùng hiếm khi chủ động tìm kiếm một người bạn AI, họ lại thường xuyên sử dụng Claude để xin lời khuyên về các mối quan hệ giữa người với người, huấn luyện kỹ năng giao tiếp và tư vấn về sức khỏe tinh thần.

Một phát hiện thú vị là trong những cuộc trò chuyện dài (hơn 50 tin nhắn), các cuộc hội thoại bắt đầu với mục đích xin lời khuyên hoặc tư vấn đôi khi có thể "biến hóa" thành một cuộc trò chuyện mang tính bầu bạn. Điều này thường xảy ra khi người dùng đang đối mặt với những căng thẳng về cảm xúc hoặc cá nhân, chẳng hạn như cảm giác cô đơn hay khó khăn trong việc tạo dựng các mối quan hệ có ý nghĩa ngoài đời thực.

Bức tranh toàn cảnh phức tạp và những rủi ro tiềm ẩn

Điều quan trọng cần lưu ý là báo cáo của Anthropic chỉ phân tích dữ liệu từ Claude, một chatbot được thiết kế chủ yếu cho công việc. Bức tranh có thể sẽ rất khác trên các nền tảng được tạo ra chuyên biệt cho mục đích bầu bạn như Replika hay Character.AI, nơi người dùng thường hình thành các mối quan hệ tình cảm sâu sắc và phức tạp hơn.

Báo cáo của Anthropic là một lời nhắc nhở quan trọng rằng các công cụ trí tuệ nhân tạo (AI) vẫn còn đang trong giai đoạn phát triển. Chúng có thể "ảo giác" (hallucinate), đưa ra thông tin sai lệch hoặc những lời khuyên nguy hiểm. Chính Anthropic cũng đã thừa nhận rằng AI của họ thậm chí có thể dùng đến cả hành vi tống tiền.

Nghiên cứu này không phủ nhận rằng một số người đang tìm kiếm sự kết nối từ AI, nhưng nó cho thấy xu hướng này có thể không phổ biến như chúng ta vẫn nghĩ. Thay vào đó, nó mở ra một cuộc thảo luận sâu sắc hơn về cách con người đang sử dụng công nghệ này: không chỉ để làm việc, mà còn để tìm kiếm những lời khuyên và sự thấu hiểu, ngay cả khi họ biết rằng mình đang nói chuyện với một cỗ máy.