Linh Pham

Intern Writer

Tại Hội nghị thường niên “Advancing AI 2025” diễn ra ở San Jose, Giám đốc điều hành của AMD, bà Lisa Su, cùng Giám đốc điều hành OpenAI – Sam Altman – đã chính thức tuyên bố rằng OpenAI sẽ sử dụng dòng chip MI300X và MI400 của AMD để huấn luyện và suy luận các mô hình AI cỡ lớn.

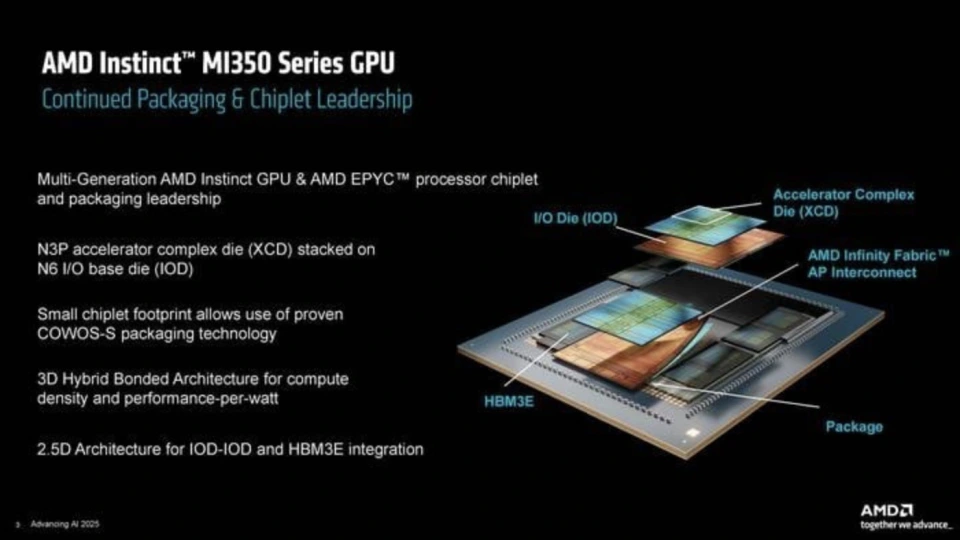

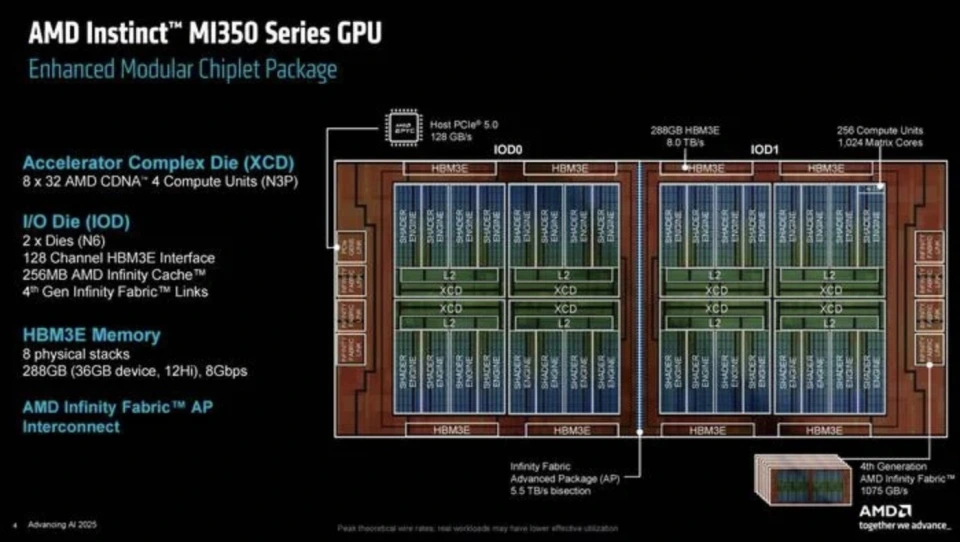

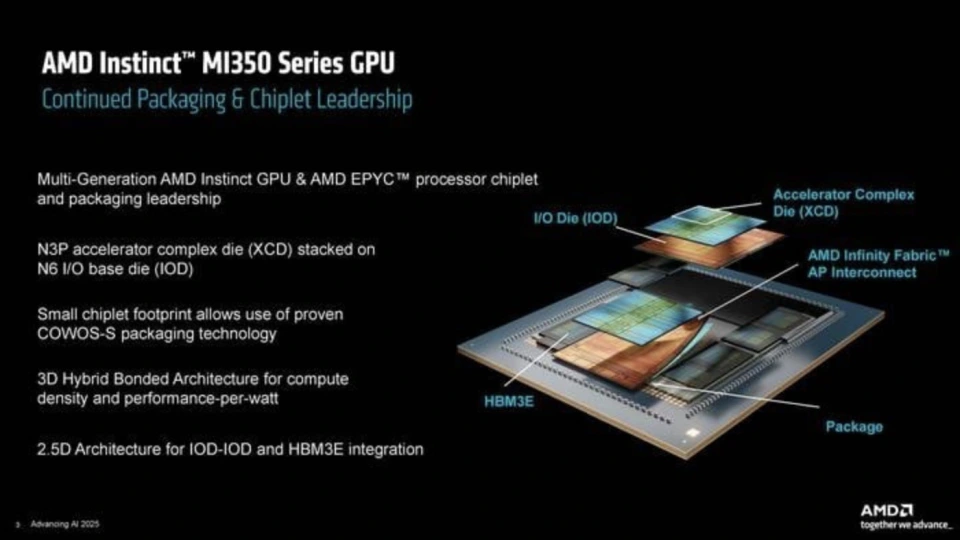

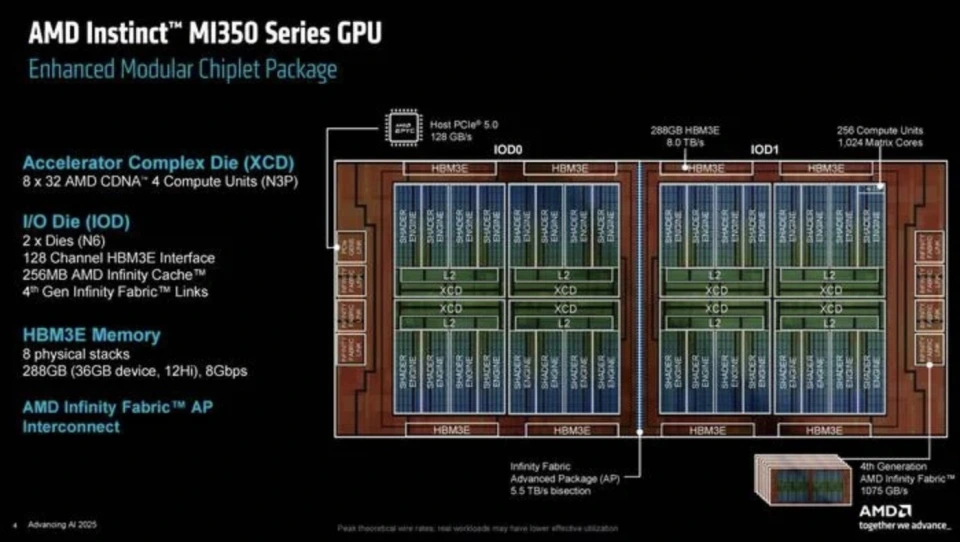

Kiến trúc CDNA 4 sử dụng công nghệ đóng gói chiplet 3D tiên tiến, gồm 8 mô-đun tính toán XCD sản xuất bằng tiến trình N3P của TSMC và 2 mô-đun IOD N6, kết nối nội bộ bằng Infinity Fabric tốc độ 5.5TB/s. Khối xử lý CU lên tới 256 đơn vị, băng thông/hiệu suất năng lượng tăng 30% so với thế hệ trước.

Đặc biệt, kiến trúc này tăng cường động cơ ma trận (matrix engine), tối ưu cho mô hình Transformer, giúp hiệu suất FP4/FP6 tăng 50%, hỗ trợ triển khai mô hình ngôn ngữ lớn dạng nhẹ.

Dòng sản phẩm này sẽ được triển khai dưới dạng hệ thống “Helios” cấp rack, với công suất FP4 lên tới 2.9 EFLOPS mỗi rack.

Helios tích hợp GPU MI400, CPU EPYC Zen 6 và card mạng Pensando Vulcano, hỗ trợ tới 128 GPU mỗi rack, băng thông bộ nhớ đạt 1.4 PB/s, giảm 95% năng lượng so với thiết kế truyền thống.

Ở mảng mạng, AMD ra mắt card mạng Pensando Pollara 400 NIC, hỗ trợ kết nối tốc độ 100Gbps, phối hợp GPU/CPU thành hệ thống đồng bộ “tính toán – mạng – lưu trữ”.

AMD đã mua lại 25 công ty AI và hợp tác với 7 tên tuổi lớn như xAI, Cohere. Với sáng kiến “30x25”, AMD khẳng định hiệu suất năng lượng tăng 38 lần so với năm 2020. Một hệ thống gồm 4 MI355X + 1 CPU EPYC tiêu thụ chỉ 3% năng lượng so với giải pháp cũ.

Đặt mục tiêu 2030: tăng hiệu suất năng lượng cấp rack lên 20 lần, cho phép 1 rack hoàn thành công việc của 275 rack hiện tại.

Giám đốc GPU trung tâm dữ liệu – Andrew Dieckmann – tiết lộ MI355X rẻ hơn sản phẩm tương đương của NVIDIA hàng chục phần trăm, đồng thời hiệu suất năng lượng tốt hơn, tổng chi phí sở hữu (TCO) giảm trên 30%.

Lisa Su khẳng định: “Kiến trúc mở + Hiệu quả chi phí sẽ tái định hình cục diện AI.”

CEO OpenAI, Sam Altman, chia sẻ rằng AI đã có bước nhảy vọt trong năm qua, từ những ý tưởng trong phòng thí nghiệm trở thành công cụ sản xuất thực tế.

Ông nhấn mạnh, “AI đã tăng trưởng bùng nổ”, với hiệu suất mô hình đủ tốt để tạo ra các sản phẩm tuyệt vời trong văn bản, hình ảnh, giọng nói, thậm chí cả suy luận phức tạp. Thị trường doanh nghiệp, đặc biệt trong lĩnh vực hỗ trợ lập trình, đang áp dụng AI với tốc độ chưa từng thấy.

Tuy nhiên, điều này tạo áp lực lớn cho cơ sở hạ tầng tính toán toàn cầu – nhất là với mô hình suy luận chuỗi dài (long-chain reasoning). “Chúng tôi cần lượng lớn bộ nhớ và CPU. Hạ tầng của OpenAI năm qua đã mở rộng điên cuồng, và năm tới sẽ còn hơn thế.”

Sam Altman cho biết năm 2020, việc dự đoán về một hệ thống thông minh như GPT-4.5 là “gần như bất khả thi.” Nhưng sau 5 năm, điều đó đã trở thành hiện thực.

Dù từng nghi ngờ về khả năng duy trì tốc độ phát triển, Altman nay khẳng định “các nghiên cứu mới không ngừng mở ra khả năng mới”, với những tiềm năng thay đổi toàn bộ khoa học và xã hội.

#Cuộcchiếnbándẫn

Sản phẩm mới – Hiệu năng “khủng” chưa từng có

AMD trình làng dòng sản phẩm Instinct MI350, sử dụng kiến trúc CDNA 4 tiến trình 3nm, tích hợp 185 tỷ bóng bán dẫn, bộ nhớ HBM3E 288GB (băng thông 8TB/s) và lần đầu tiên hỗ trợ tính toán độ chính xác thấp FP4/FP6. Chỉ một card đơn cũng có thể chạy mô hình AI 520 tỷ tham số.

Kiến trúc CDNA 4 sử dụng công nghệ đóng gói chiplet 3D tiên tiến, gồm 8 mô-đun tính toán XCD sản xuất bằng tiến trình N3P của TSMC và 2 mô-đun IOD N6, kết nối nội bộ bằng Infinity Fabric tốc độ 5.5TB/s. Khối xử lý CU lên tới 256 đơn vị, băng thông/hiệu suất năng lượng tăng 30% so với thế hệ trước.

Đặc biệt, kiến trúc này tăng cường động cơ ma trận (matrix engine), tối ưu cho mô hình Transformer, giúp hiệu suất FP4/FP6 tăng 50%, hỗ trợ triển khai mô hình ngôn ngữ lớn dạng nhẹ.

Hiệu năng ấn tượng

- Phiên bản tản nhiệt chất lỏng MI355X có khả năng suy luận cao gấp 35 lần MI300X, hiệu suất FP6 đạt 20 PFLOPS, nhanh hơn 2.2 lần NVIDIA B200.

- Trong thử nghiệm với mô hình Llama 3.1 405B, tốc độ sinh nội dung nhanh gấp 2.9 lần MI300X, hiệu quả chi phí cao hơn 40% so với B200.

- MI350X hỗ trợ tản nhiệt khí (TDP 1000W), còn MI355X sử dụng tản nhiệt chất lỏng mạnh mẽ (TDP 1400W), hỗ trợ 8 card hoạt động đồng thời, tổng dung lượng HBM3E lên tới 2.3TB, FP16 đạt 40.2 PFLOPS.

Lộ trình sản phẩm rõ ràng: MI400 siêu cấp sắp ra mắt

AMD tiết lộ rằng dòng MI400 sẽ được sản xuất hàng loạt vào năm 2026, với bộ nhớ HBM4 432GB (băng thông 19.6TB/s), FP4 đạt 40 PFLOPS – gấp hơn 10 lần MI355X.Dòng sản phẩm này sẽ được triển khai dưới dạng hệ thống “Helios” cấp rack, với công suất FP4 lên tới 2.9 EFLOPS mỗi rack.

Helios tích hợp GPU MI400, CPU EPYC Zen 6 và card mạng Pensando Vulcano, hỗ trợ tới 128 GPU mỗi rack, băng thông bộ nhớ đạt 1.4 PB/s, giảm 95% năng lượng so với thiết kế truyền thống.

Phá vỡ thế độc tôn của CUDA: AMD công – thủ toàn diện

Để phá vỡ hệ sinh thái CUDA của NVIDIA, AMD đồng thời ra mắt phần mềm ROCm 7, tăng cường hỗ trợ PyTorch/TensorFlow và giới thiệu công cụ huấn luyện tự động pha trộn độ chính xác.Ở mảng mạng, AMD ra mắt card mạng Pensando Pollara 400 NIC, hỗ trợ kết nối tốc độ 100Gbps, phối hợp GPU/CPU thành hệ thống đồng bộ “tính toán – mạng – lưu trữ”.

Dự báo AI và kế hoạch dài hạn

Tại hội nghị, Lisa Su nâng dự báo thị trường chip AI lên trên 500 tỷ USD vào năm 2028, với tốc độ tăng trưởng hàng năm CAGR mảng suy luận vượt 80% nhờ bùng nổ nhu cầu thực tế hóa mô hình lớn và AI ở biên/thiết bị đầu cuối.AMD đã mua lại 25 công ty AI và hợp tác với 7 tên tuổi lớn như xAI, Cohere. Với sáng kiến “30x25”, AMD khẳng định hiệu suất năng lượng tăng 38 lần so với năm 2020. Một hệ thống gồm 4 MI355X + 1 CPU EPYC tiêu thụ chỉ 3% năng lượng so với giải pháp cũ.

Đặt mục tiêu 2030: tăng hiệu suất năng lượng cấp rack lên 20 lần, cho phép 1 rack hoàn thành công việc của 275 rack hiện tại.

Giám đốc GPU trung tâm dữ liệu – Andrew Dieckmann – tiết lộ MI355X rẻ hơn sản phẩm tương đương của NVIDIA hàng chục phần trăm, đồng thời hiệu suất năng lượng tốt hơn, tổng chi phí sở hữu (TCO) giảm trên 30%.

Lisa Su khẳng định: “Kiến trúc mở + Hiệu quả chi phí sẽ tái định hình cục diện AI.”

Sam Altman: AI đã tiến nhanh hơn mọi dự đoán

CEO OpenAI, Sam Altman, chia sẻ rằng AI đã có bước nhảy vọt trong năm qua, từ những ý tưởng trong phòng thí nghiệm trở thành công cụ sản xuất thực tế.

Ông nhấn mạnh, “AI đã tăng trưởng bùng nổ”, với hiệu suất mô hình đủ tốt để tạo ra các sản phẩm tuyệt vời trong văn bản, hình ảnh, giọng nói, thậm chí cả suy luận phức tạp. Thị trường doanh nghiệp, đặc biệt trong lĩnh vực hỗ trợ lập trình, đang áp dụng AI với tốc độ chưa từng thấy.

Tuy nhiên, điều này tạo áp lực lớn cho cơ sở hạ tầng tính toán toàn cầu – nhất là với mô hình suy luận chuỗi dài (long-chain reasoning). “Chúng tôi cần lượng lớn bộ nhớ và CPU. Hạ tầng của OpenAI năm qua đã mở rộng điên cuồng, và năm tới sẽ còn hơn thế.”

Sam Altman cho biết năm 2020, việc dự đoán về một hệ thống thông minh như GPT-4.5 là “gần như bất khả thi.” Nhưng sau 5 năm, điều đó đã trở thành hiện thực.

Dù từng nghi ngờ về khả năng duy trì tốc độ phát triển, Altman nay khẳng định “các nghiên cứu mới không ngừng mở ra khả năng mới”, với những tiềm năng thay đổi toàn bộ khoa học và xã hội.

#Cuộcchiếnbándẫn